伯克利开源Ray Tune:大规模AI实验利器

极客时间编辑部

讲述:丁婵大小:7.56M时长:05:31

日前,伯克利 BAIR 博客分享了开发两个重要软件库 Ray Tune 和 Ray Cluster Launcher 的经验,这两个库现在支持很多流行的开源 AI 库,很多 BAIR 研究人员用它们来执行大规模 AI 实验。以下为原文内容。

理解研究基础设施

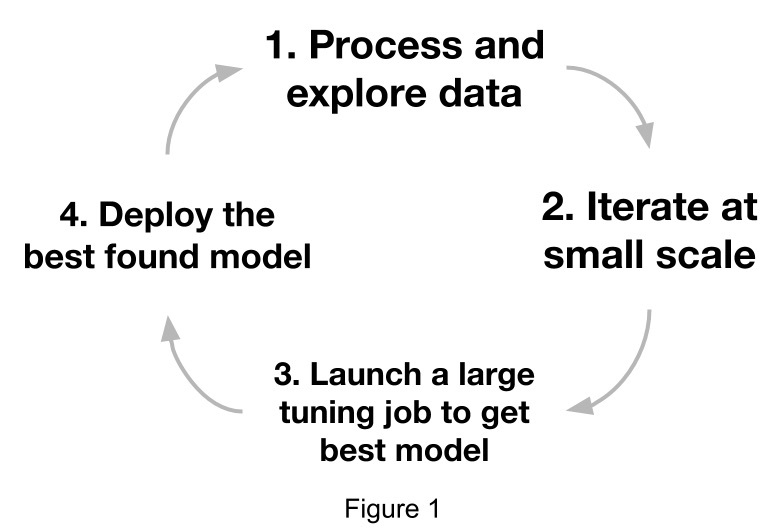

为了更全面地理解这些内容,我们先来查看业界的标准机器学习工作流。

典型的“研究”工作流实际是步骤 2 和 3 之间的紧密循环,大致如下图所示。

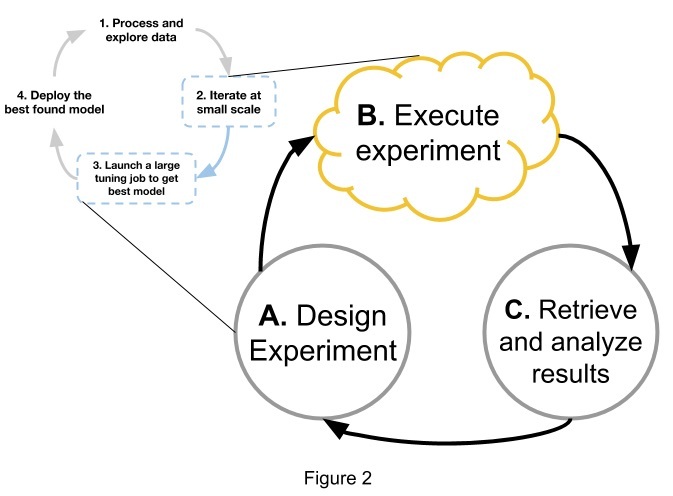

该研究工作流在很大程度上是个迭代的过程,通常受到实验执行步骤(如上图中的 B 所示)的制约。一个“实验”包括多个训练作业或“试验”,其中每个试验都是训练单个模型的任务。每个试验可能使用一组不同的配置参数(超参数)或不同的种子来训练一个模型。

在伯克利,我们看到转向云的 AI 研究人员花费大量时间来编写自己的实验执行工具,这些工具整理云供应商的 API 以启动实例、设置依赖项和启动实验。

不幸的是,除了开发这些工具所要投入的大量时间以外,这些临时的解决方法还常常在功能上受到限制:

简化的架构:每个试验通常在单独的节点上启动,没有任何集中控制逻辑。这让研究人员难以实施优化技术。

缺乏故障处理:如果实例失败,那么训练作业的结果会永远丢失。研究人员常常在电子表格上跟踪实时实验来手动管理故障转移,但是,这么做既费时又容易出错。

没有竞价性实例折扣(Spot Instance Discount):缺乏容错能力也意味着放弃云供应商提供的竞价性实例折扣(最高可达 90% )。

总之,在云资源上测试和管理分布式实验既费力又容易出错。因此,采用易于使用的框架以在执行和研究之间架起桥梁可以大大加快研究过程。来自 BAIR 的几个实验室成员协作构建了两个互补的工具,用于在云中进行 AI 实验:

Ray Tune:用于训练和超函数调优的容错框架。它协调并行作业以支持并行超参数优化;自动检查点,并在机器有故障时恢复训练作业;提供了很多最先进的超参数搜索算法。

Ray Cluster Launcher :一个实用程序,用于管理 AWS、GCP 和 Kubernetes 之间的资源调配和集群配置。

Ray Tune

利用 Ray Actor API 并添加故障处理来解决问题,也就是 Ray 提供一个 API 从一个 Python 类来创建一个“actor”。这使得类和对象可以在并行和分布式设置中使用 。

#### 基于 Actor 的训练

Ray Tune 使用一个可训练的(Trainable)类接口来定义一个 actor 类,这个类专门用于训练模型。该接口公开了如 _train、_stop、_save 和 _restore 等方法,这些方法允许 Ray Tune 监视中间的训练指标并杀死效果不佳的试验。

更重要的是,通过利用 Actor API,我们可以在 Ray Tune 中实施并行超参数优化模式,而这些是研究人员以前使用的实验执行工具无法做到的。

容错

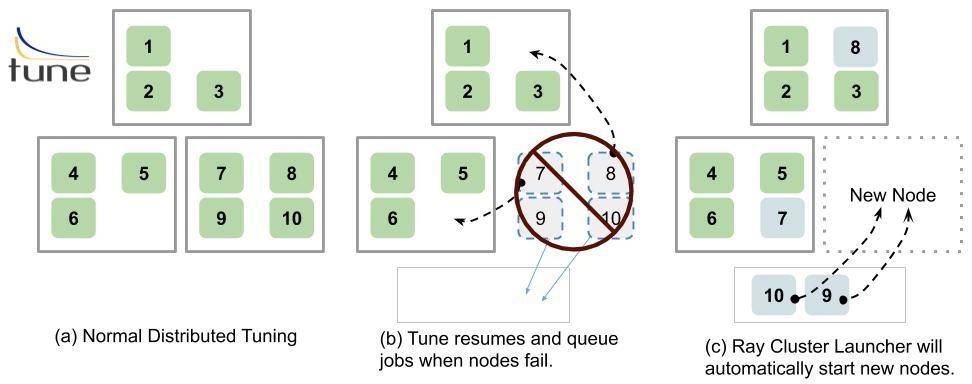

为了可以使用竞价型实例,我们构建了 Ray Tune 以在集群不同的机器中自动地建立检查点并恢复训练作业,这样,实验将对抢占和集群大小的调整具有弹性。

它是如何工作的呢?

如果在某个节点丢失的时候,有个训练作业仍在其上执行且该训练作业(试验)的检查点存在,那么,Ray Tune 将一直等到有可用资源可用,以再次执行该试验。

如果该试验被放置在一个不同的节点上,那么,Tune 将自动把之前的检查点文件推送到那个节点并恢复状态,即使失败,该试验也可以从最新的检查点恢复。

Ray Cluster Launcher

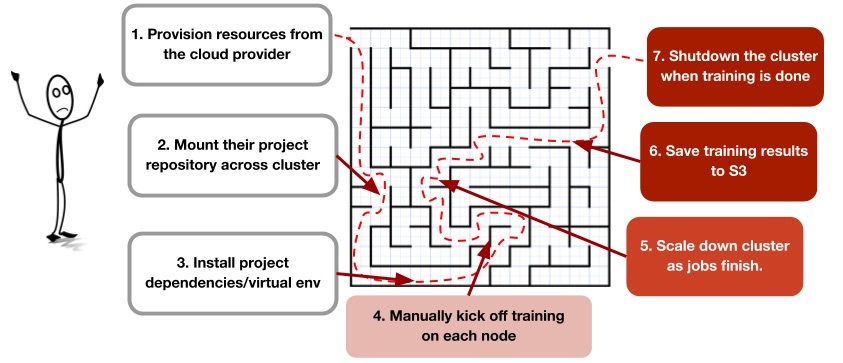

上面,我们描述了为自动化集群设置过程而整理云供应商 API 的痛苦之处。但是,即使有了用于分解集群的工具,研究人员还是必须经过繁琐的工作流才能进行实验:

为了简化一下这个过程,我们构建了 Ray Cluster Launcher,这个工具会调配资源并自动调整资源大小,并且在 AWS EC2、GCP 和 Kubernetes 上启动一个 Ray 集群。然后,我们把以上用于进行一个实验的步骤抽象成一个简短的配置文件和一个命令:

下面的命令用来启动一个集群、上传并运行一个用于分布式超参数调整的脚本,然后关闭该集群。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

该免费文章来自《极客视点》,如需阅读全部文章,

请先领取课程

请先领取课程

免费领取

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

全部留言(1)

- 最新

- 精选

小斧代码看上去很炫酷。

小斧代码看上去很炫酷。

收起评论