43 | PCA主成分分析(下):为什么要计算协方差矩阵的特征值和特征向量?

该思维导图由 AI 生成,仅供参考

基于 Python 的案例分析

- 深入了解

- 翻译

- 解释

- 总结

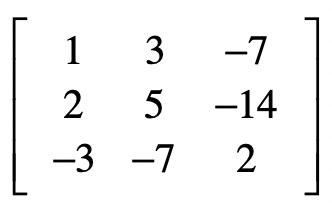

PCA主成分分析是一种常用的降维方法,本文详细介绍了PCA的操作步骤和核心思想。首先,文章通过Python代码实例分析了PCA的操作过程,包括数据标准化、协方差矩阵的计算、特征值和特征向量的求解以及样本矩阵的变换。其次,文章解释了为什么要使用协方差矩阵,以及特征值和特征向量的含义,为什么选择特征值最大的主成分能涵盖最多的信息量。通过这些解释,读者可以更深入地理解PCA方法的原理和应用。整体而言,本文通过具体案例和理论解释相结合的方式,帮助读者快速了解PCA主成分分析的操作步骤和背后的核心思想,为初学者提供了一份有益的学习参考。文章内容深入浅出,适合初学者快速理解PCA的操作步骤和核心思想。

《程序员的数学基础课》,新⼈⾸单¥68

全部留言(20)

- 最新

- 精选

Wing·三金思考题: 基于分类的特征选择 优点:可以根据标签,有针对性地选择特征,可解释性强; 缺点:若是已有的特征未能反映数据的本质关系,可能会起不到精简特征的作用,因为每个特征几乎同等地重要。 基于 PCA 的特征降维: 优点:可以组合相关性强的特征维度,挖掘数据的本质特征; 缺点:因为失去了原始特征的描述,导致新的特征可解释性很差。

Wing·三金思考题: 基于分类的特征选择 优点:可以根据标签,有针对性地选择特征,可解释性强; 缺点:若是已有的特征未能反映数据的本质关系,可能会起不到精简特征的作用,因为每个特征几乎同等地重要。 基于 PCA 的特征降维: 优点:可以组合相关性强的特征维度,挖掘数据的本质特征; 缺点:因为失去了原始特征的描述,导致新的特征可解释性很差。作者回复: 写得很到位

2019-04-0421 半城柳色 / 半声笛这也是为什么,我们需要使用原始的数据去左乘这个特征向量,来获取降维后的新数据。 对于这句话还是不太理解,这个特征向量是协方差矩阵的特征向量,如果是协方差矩阵乘上特征向量,就能使得特征向量伸缩,也就是获得了协方差矩阵的主要方向(在特征值最大情况下),但是原始数据乘上协方差矩阵的特征向量,为啥得到的也是它的主成分?

半城柳色 / 半声笛这也是为什么,我们需要使用原始的数据去左乘这个特征向量,来获取降维后的新数据。 对于这句话还是不太理解,这个特征向量是协方差矩阵的特征向量,如果是协方差矩阵乘上特征向量,就能使得特征向量伸缩,也就是获得了协方差矩阵的主要方向(在特征值最大情况下),但是原始数据乘上协方差矩阵的特征向量,为啥得到的也是它的主成分?作者回复: 你可以这么理解,协方差特征向量,告诉你了哪些特征是强相关的,并把这些强相关的特征捆绑在一起,组成一个新的维度达到降维的效果。所以原始数据左乘这个特征向量就是为了达到把若干强相关的原始特征值捆绑在一起,生成一个新的特征值,最终达到降维的目的。一个矩阵乘以自己的特征向量并不一定能达到降维的效果。

2019-07-2413- Geek_a50e46老师您好,我这边还有点疑惑,就是这里的降维,究竟降的或者说去掉的是那几维特征。或者换个问法,计算出的特征值分别对应哪个列的特征呢?谢谢

作者回复: 降维的方法有很多,有一些比较容易理解的,就是去掉冗余的信息维度,这里PCA稍微复杂一些,通常不是直接去掉某些维度,而是生成更少的一些维度,而这些维度是原始维度的融合。举个最简单的例子,如果原来有3个特征x1, x2和x3,那么新的维度可能是0.5 * x1 + 0.1 * x2 - x3,这一个维度就包含了之前三个维度的所表达的90%以上的信息,那么我们就可以将3维降到1维。

2020-02-169 - Paul Shan我个人的理解,基于分类标签的选择主要选择那些和预测结果相关度高的特征,这类似于从结果出发反向选择那些有紧密联系的特征。这种方法精度较高,而且特征是原始的,容易理解。但是需要大量有标记的数据。 而PCA主成分分析法是从特征出发,分析特征之间的相关性和特征本身的信息量,最终重新合成特征,这些新的特征最大程度包含原特征的信息量。这种方法的好处是不需要标记数据。缺点是只是对特征分析,现实世界预测列和特征列的关系可能并不是特征列之间的相关性就能表达,而且新的特征是合成的,不好理解。

作者回复: 很好的总结👍

2019-10-105  动摇的小指南针老师,PCA的原理实际上就想使目标矩阵X的列向量组x1,x2,x3..方差最大,同时协方差为0。而协方差矩阵刚好满足这样的特征,只需要找到可以让协方差矩阵对角化的矩阵P,就可以使x1,x2,x3的彼此协方差化为0(即正交),而保留方差的特征,而对角化的矩阵P也就是X矩阵的特征向量集合。不知道我说的对不对

动摇的小指南针老师,PCA的原理实际上就想使目标矩阵X的列向量组x1,x2,x3..方差最大,同时协方差为0。而协方差矩阵刚好满足这样的特征,只需要找到可以让协方差矩阵对角化的矩阵P,就可以使x1,x2,x3的彼此协方差化为0(即正交),而保留方差的特征,而对角化的矩阵P也就是X矩阵的特征向量集合。不知道我说的对不对作者回复: 是的,主要的思想就是如此

2019-07-153 蚂蚁内推+v老师你好,问一下离散型的纬度是不是不适合参与这种方式降纬啊?如果有纬度是离散的,那应该怎么处理呢?

蚂蚁内推+v老师你好,问一下离散型的纬度是不是不适合参与这种方式降纬啊?如果有纬度是离散的,那应该怎么处理呢?作者回复: 只要是数值型,如果是离散的也是可以的。如果不是数值型,要看看能否转换成数值型,以及转成数值型之后大小变化是否还有意义。

2019-03-252 建强基于分类标签的特征选择,通过特征对类别划分的增益大小,即特征对样本类别的影响程度,来决定该特征是否对类别的判断是否有价值,主要用于有明确目标的监督式学习中。 优点:计算信息量较小,公式可解释性强,适用于监督式学习,特征可以是非数值型,缺点:易受噪声干扰影响精度。 基于PCA的特征分析,是分析样本特征本身所含的信息量大小,来决定特征是否有价值,并通过保留信息量大的特征,去除信息量小的特征,来达到特征降维的目的。 优点:精度较高,不受噪声干扰,适用于无监督式学习,缺点:计算量大,公式不直观,难理解,且特征值必须是数值型。 这是我个人的一点肤浅理解,请老师指正。

建强基于分类标签的特征选择,通过特征对类别划分的增益大小,即特征对样本类别的影响程度,来决定该特征是否对类别的判断是否有价值,主要用于有明确目标的监督式学习中。 优点:计算信息量较小,公式可解释性强,适用于监督式学习,特征可以是非数值型,缺点:易受噪声干扰影响精度。 基于PCA的特征分析,是分析样本特征本身所含的信息量大小,来决定特征是否有价值,并通过保留信息量大的特征,去除信息量小的特征,来达到特征降维的目的。 优点:精度较高,不受噪声干扰,适用于无监督式学习,缺点:计算量大,公式不直观,难理解,且特征值必须是数值型。 这是我个人的一点肤浅理解,请老师指正。作者回复: 总结的很好,PCA主要是根据不同类型特征自身的分布情况来去除冗余的信息,所以无需标签,适合非监督的学习

2020-11-071 hp++请问: 如果左乘矩阵对某一个向量或某些向量只发生伸缩变换,不对这些向量产生旋转的效果,那么这些向量就称为这个矩阵的特征向量,而伸缩的比例就是特征值。 旋转后就不是特征向量了么

hp++请问: 如果左乘矩阵对某一个向量或某些向量只发生伸缩变换,不对这些向量产生旋转的效果,那么这些向量就称为这个矩阵的特征向量,而伸缩的比例就是特征值。 旋转后就不是特征向量了么作者回复: 如果旋转了,就表明左乘的向量不是特征向量。而乘积之后的矩阵,特征向量也发生了变化

2020-09-101 米饭我觉得本章的难点在与为什么协方差矩阵对角化可以降维,以下是我的理解: 协方差矩阵度量的就是维度和维度之间的关系。协方差矩阵主对角线上的元素就是各个维度上的方差,非主对角线上元素是各维度之间的相关性(协方差)。 既然我们的目的是为了降维,那就是让不同维度间的相关性尽可能的小,所以就可以转化为如何让协方差矩阵非对角线元素尽可能为零,要达到这个目的,就要进行矩阵对角化 不知道我的理解对不对

米饭我觉得本章的难点在与为什么协方差矩阵对角化可以降维,以下是我的理解: 协方差矩阵度量的就是维度和维度之间的关系。协方差矩阵主对角线上的元素就是各个维度上的方差,非主对角线上元素是各维度之间的相关性(协方差)。 既然我们的目的是为了降维,那就是让不同维度间的相关性尽可能的小,所以就可以转化为如何让协方差矩阵非对角线元素尽可能为零,要达到这个目的,就要进行矩阵对角化 不知道我的理解对不对作者回复: 是的,这是最核心的理念

2020-08-281 余泽锋

余泽锋 关于选择协方差作为PCA分析的对象,有些困惑。 本质上,皮尔森系数和数据标准化的协方差是一致的,那么皮尔森系数是不是跟协方差一样可以拿来衡量信息量的大小和不同维度之间的相关性。 那么选择协方差或者皮尔森系数作为PCA分析的对象岂不是差不多?

关于选择协方差作为PCA分析的对象,有些困惑。 本质上,皮尔森系数和数据标准化的协方差是一致的,那么皮尔森系数是不是跟协方差一样可以拿来衡量信息量的大小和不同维度之间的相关性。 那么选择协方差或者皮尔森系数作为PCA分析的对象岂不是差不多?作者回复: 理论上来说确实如此,我们可以通过代码来比较一下结果。

2019-04-111