20 | 基于距离的学习:聚类与度量学习

王天一

该思维导图由 AI 生成,仅供参考

截至目前,我所介绍的模型都属于监督学习范畴,它们处理具有标签的输入数据,给出意义明确的输出,回归模型输出的是连续的回归值,分类模型输出的是离散的类别标签,这些模型都属于预测模型(predictive model)。

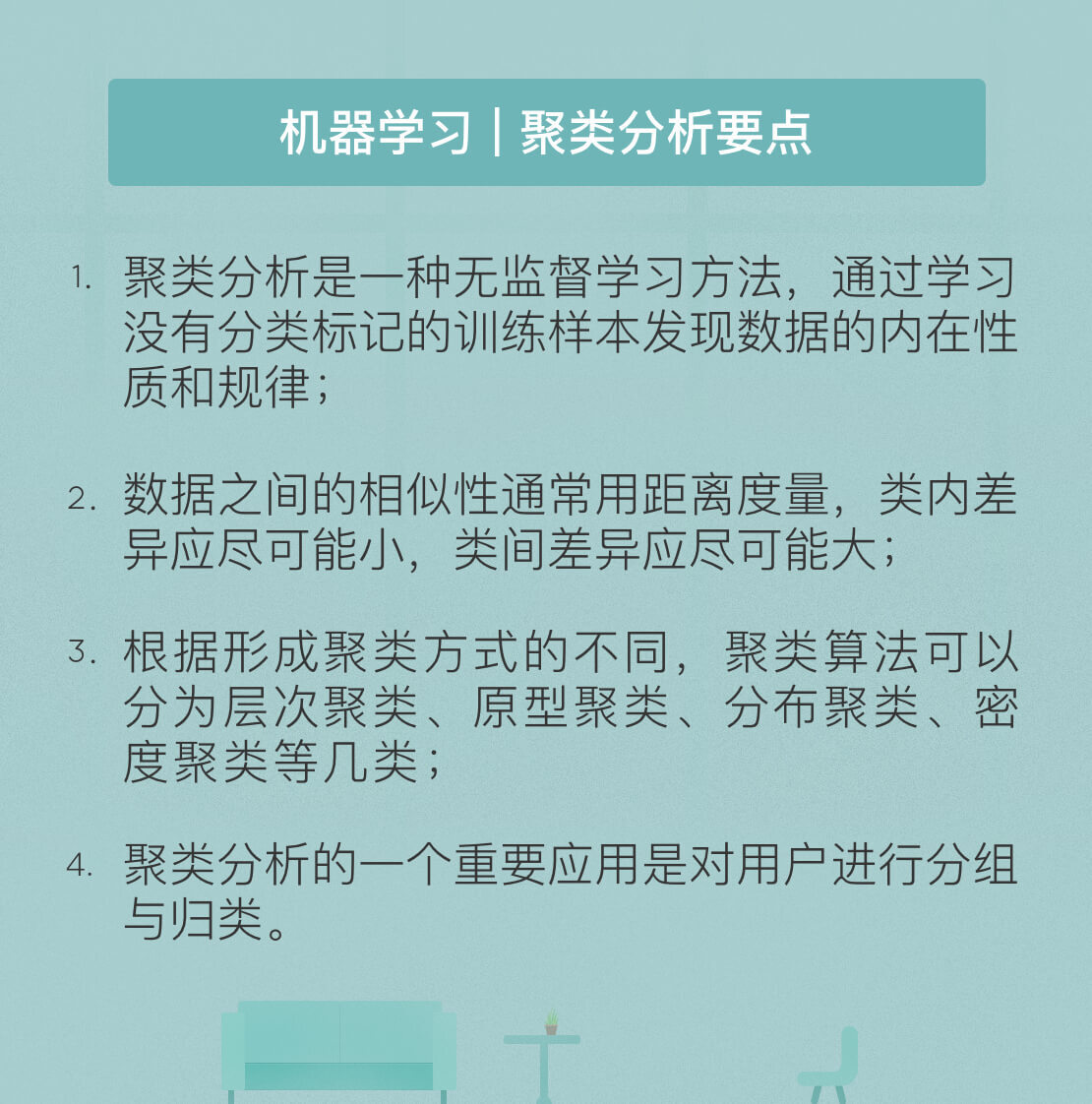

另一类模型则隶属于无监督学习,这类模型学习没有标签的数据,其作用也不是计算类别或回归值,而是要揭示关于数据隐藏结构的一些规律,因此也被称为描述模型(descriptive model)。聚类算法就是最具代表性的描述模型。

聚类分析(cluster analysis)实际上是一种分组方式,它使每一组中的组内对象的相似度都高于组间对象的相似度,分出来的每个组都是一个簇(cluster)。由于相似度是聚类的依据,作为相似度主要度量方式之一的距离就在聚类中发挥着重要作用。

在“人工智能基础课”中,我曾介绍过四种主要的聚类算法,你可以结合下面的要点图回忆一下。除了以概率分布为基础的分布聚类以外,其他三类聚类算法都涉及对距离的使用,而其中最典型的就是 均值所代表的原型聚类算法。

理解 均值算法的基础是理解它对距离的使用方式。前面介绍的 近邻算法其实也用到了距离,近邻的选择就是以距离为依据的。但近邻点是以内收的形式影响未知的数据,所有近邻点按照一定的规则共同决定处于中心的未知数据的类别。如果将这种影响的方式调转方向,让处于中心的样本作为原型(prototype),像一个小太阳一样用万有引力牵引着周围的其他样本,那么其他样本就会像卫星一样被吸附在原型周围,共同构成一个星系,也就是簇。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

本文介绍了基于距离的学习方法在聚类分析中的应用,重点讨论了$k$均值算法的原理和实际运用。$k$均值算法通过计算数据点与簇中心的距离,将数据点划分到离其最近的簇中,并不断迭代更新簇中心直到聚类结果稳定。文章还指出了$k$均值算法与高斯混合模型的关系,以及介绍了度量学习的概念。度量学习旨在构造适合于给定问题的距离度量或相似度的度量,包括全局性度量和局部度量学习。文章深入浅出地介绍了基于距离的学习方法及其扩展,为读者提供了对聚类分析和度量学习的全面了解。文章内容涵盖了聚类分析的描述模型、$k$均值算法的距离判定、高斯混合模型的概率角度、以及度量学习的全局性和局部性特点。通过本文,读者可以快速了解基于距离的学习方法在聚类分析中的应用及其相关概念,为进一步深入学习提供了良好的基础。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《机器学习 40 讲》,新⼈⾸单¥59

《机器学习 40 讲》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

全部留言(2)

- 最新

- 精选

paradox老师,您好 我有两个关于马氏距离的问题: 1、Gxi 的维度会比 xi 的原始维度有所降低,故可以用作降维,这里不理解G的含义以及为什么会使维度有所降低 2、马氏距离的好处在于引入了可调节的参数,从而使距离可以通过对数据的学习来加以改善,是不是因为中间的协方差矩阵起了权重的作用,也就是后面所说的G起了权重作用,因此可以用作降维? 谢谢!

paradox老师,您好 我有两个关于马氏距离的问题: 1、Gxi 的维度会比 xi 的原始维度有所降低,故可以用作降维,这里不理解G的含义以及为什么会使维度有所降低 2、马氏距离的好处在于引入了可调节的参数,从而使距离可以通过对数据的学习来加以改善,是不是因为中间的协方差矩阵起了权重的作用,也就是后面所说的G起了权重作用,因此可以用作降维? 谢谢!作者回复: 马氏距离的原始定义要求度量矩阵Sigma^{-1}是两个元素的协方差矩阵。但在做度量学习时,我们可以人为地生成度量矩阵,在保证距离相似性的同时降低它的秩,让它的秩小于原来的属性数目。 G是对半正定度量矩阵的分解,其作用相当于线性变换。当度量矩阵的秩较小时,线性变换G就可以将数据投影到低维空间,实现降维。

2018-08-111 ifelse

ifelse 学习打卡2023-06-05归属地:浙江

学习打卡2023-06-05归属地:浙江

收起评论