35|如何让大模型使用工具完成工作?

月影

你好,我是月影。

我们在平时工作中使用大模型的时候,实际上不仅仅是让大模型输出文本、图片或者其他多模态内容,更重要的是,要使用大模型来解决我们工作中的实际问题。

这里就涉及到一个非常重要的基本概念,就是大模型不仅仅是根据我们的提示词完成推理,给出内容结果,而且还可以调用工具,来完成各种任务。

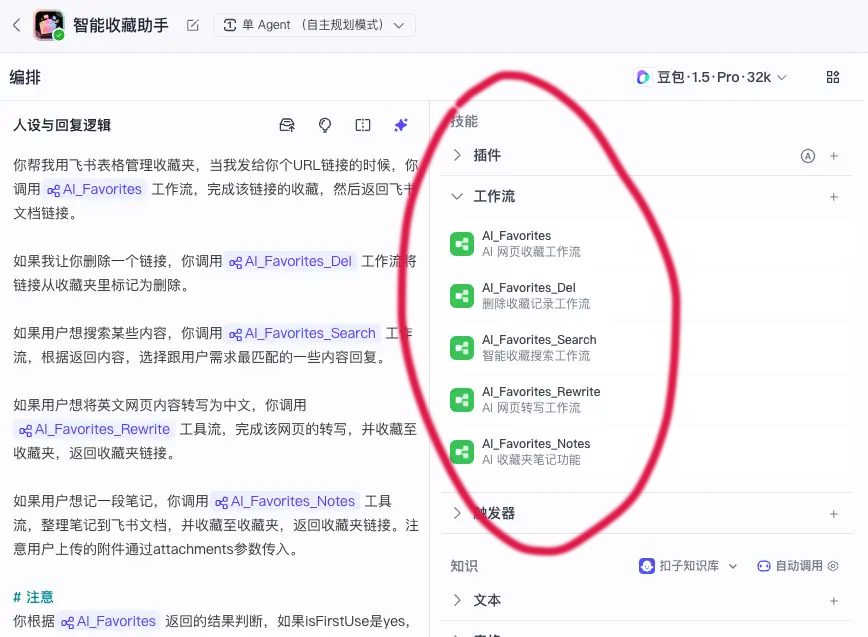

其实我们在前面的课程中,已经涉及到这部分内容,比如加餐中的 Coze 案例,很多时候,都会通过插件等方式,在工作流中调用工具,生成结果提供给 AI,而且最终我们真正对话的智能体也是通过调用工作流来完成最终的工作,同样相当于让智能体使用了工具。只不过我们之前并没有特意强调这一点。

前面介绍的 Coze、Dify 这些智能体开发平台,默认提供了配置和使用各类工具的能力

实际上,不只是 Coze、Dify 这样的平台,我们自己同样可以为大模型指定工具,不仅是在线的大模型,甚至前面介绍的本地大模型也一样可以。

这一节我们就通过实战例子,来看如何给通过 Ollama 部署的 qwen3:1.7b 配置和使用工具。

为大模型配置 tools

大部分 OpenAI API 兼容的大模型,都可以通过在请求时传递 tools 参数来告诉大模型可以调用哪些工具。tools 的参数配置格式大部分大模型官网文档中都有,而且参数形式基本上都比较一致,比如 moonshot 调用 tools,我们可以直接在官网找到相关文档:https://platform.moonshot.cn/docs/api/tool_use。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 大模型可以通过调用工具来解决实际工作中的问题。 2. OpenAI API 兼容的大模型可以通过传递 tools 参数告诉大模型可以调用哪些工具。 3. 介绍了如何给通过 Ollama 部署的 `qwen3:1.7b` 配置和使用工具。 4. 服务端代码通过 HTTP 请求调用本地 Ollama 的 REST 接口,并传入 tools 参数指定工具。 5. 前端代码配置了 vite 代理,实现了当让 AI 帮我们列出目录下的文件时,AI 请求调用 DirFile,然后处理结果返回给前端。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《跟月影学前端智能体开发》,新⼈⾸单¥59

《跟月影学前端智能体开发》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论