33|如何私有化部署和应用本地大模型

月影

你好,我是月影。

从这一讲开始,我们进入新的单元,讲一讲企业应用中可能会遇到的问题,以及该如何解决这类问题。

首先,很多公司出于数据安全合规方面的考量,都需要私有化部署大模型,而不能采用公开的大模型。这时候,就需要我们具备模型部署能力,能自己在服务器上部署开源或者特定的大模型。

实际上,现在有很多比较不错的开源大语言模型可以选择,其中包括通用对话类以及编程工具类。

适合本地部署的大模型

我为你整理了一些常用的模型。

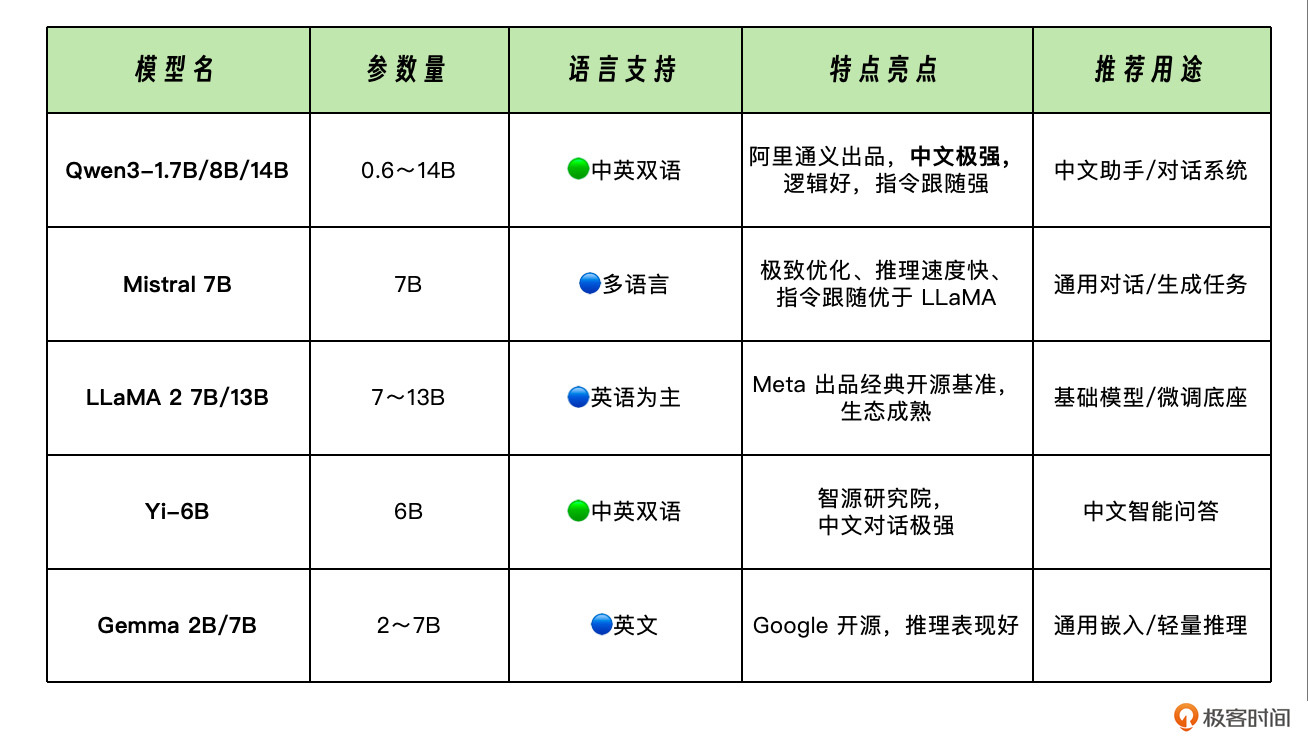

通用对话类模型

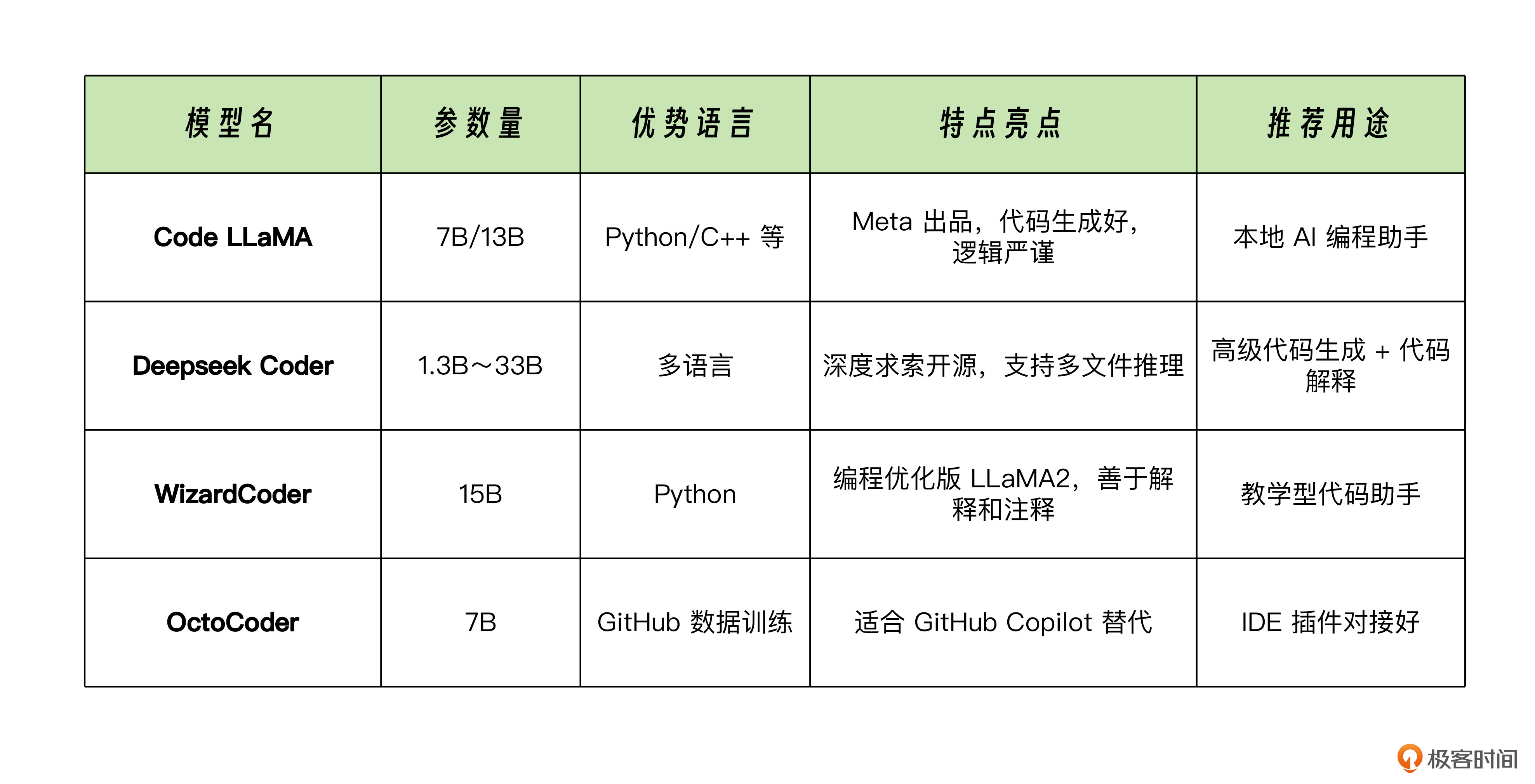

编程 / 工具类模型

除了这些模型外,还有一类专用模型,比如用来做向量嵌入的模型,通常用于构建本地知识库,在后续章节里我们再专门讨论。

如何部署本地大模型

首先安装 Ollama 命令,如果你是在 Linux 服务器上安装,可以用如下命令:

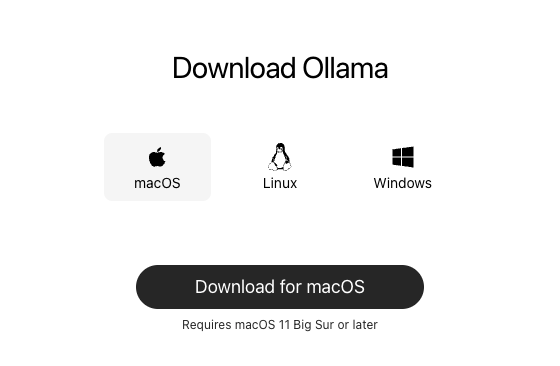

如果你是 MacOS 或 Windows,那么可以在官网直接下载安装包:

下载完成之后,我们解压运行 App,会自动安装 Ollama 命令。安装完成后,我们在终端运行:

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 企业需要私有化部署大模型以满足数据安全合规要求,因此需要具备模型部署能力。 2. 可选择适合本地部署的大模型,包括通用对话类模型和编程/工具类模型。 3. 使用 Ollama 工具可以快速部署本地大模型,并支持通过 NodeJS 调用 API。 4. 通过 HTTP 请求访问本地部署的大模型的 REST API,可以实现在前端调用本地大模型。 5. 本地部署的代码专用模型如 deepseek-coder 可以解决企业安全因素导致无法连接外网的问题。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《跟月影学前端智能体开发》,新⼈⾸单¥59

《跟月影学前端智能体开发》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论