17|评估:如何对电商客服模型专有训练进行能力测评?

蓝金伟

你好,我是金伟。

总体而言,大模型测评才是整个项目的核心。基于电商客服对问答准确性的要求,只有发布之前测试充分,才能保证发布后不出现 bug。问题是,怎么才能通过测评保证电商客服模型的准确性呢?

很多人可能会想,直接用程序自动测试?或者用其他能力更强的大模型来测评?我的实际经验表明,最重要的是人工测评。

在真实电商客服项目中,我们采用人工测评 + 自动化测评结合的方案。

我们先从测评和训练之间的关系开始说。

测评过程

首先需要注意的是,为了保证测评效果,测评数据集和训练数据集要完全隔离。真实项目里,测评分为 3 类测评,分别是人工测评,通用测评和私有 task 测评。

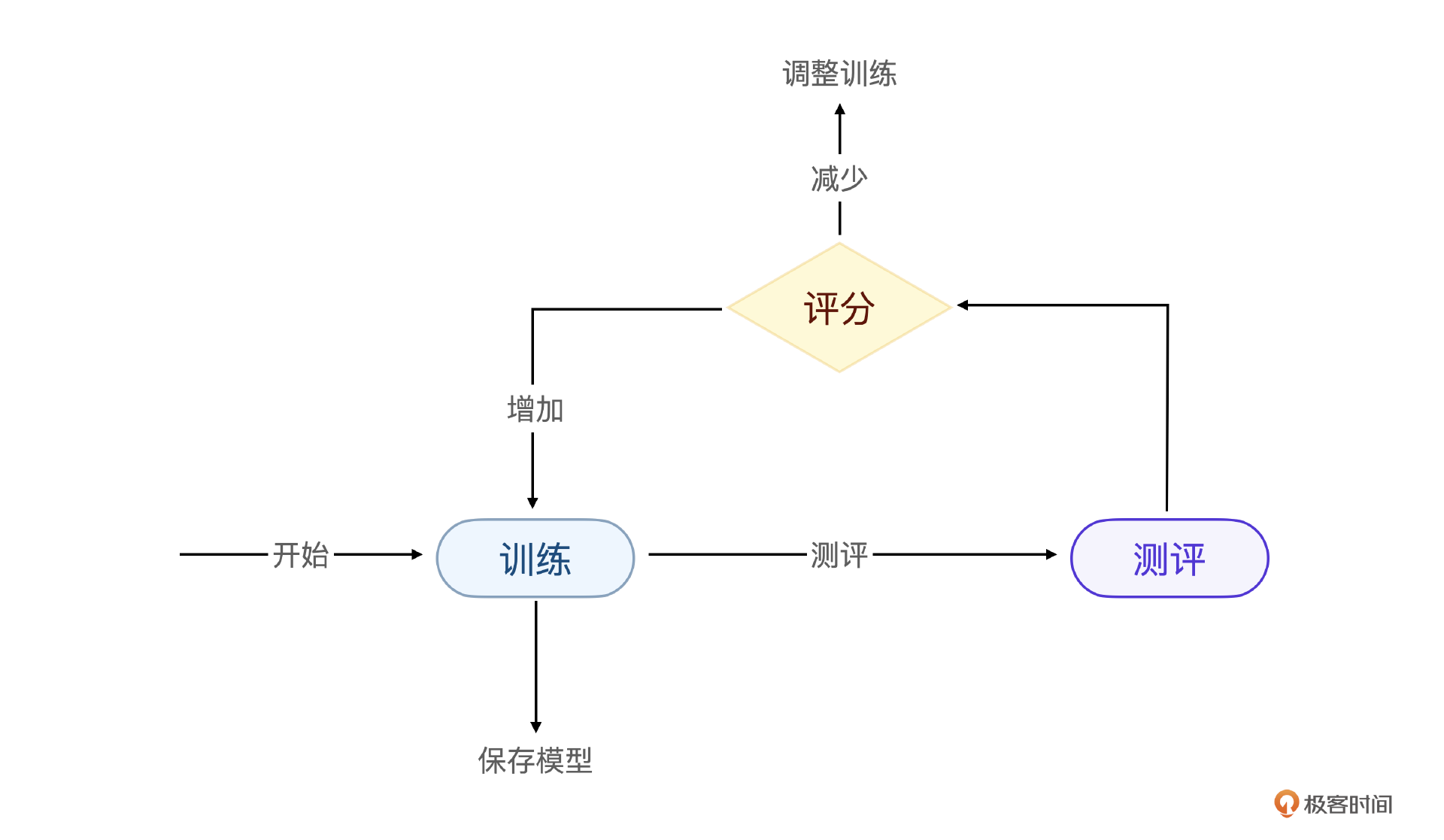

测评和训练的关系不是先训练再测评,而是在模型训练过程中分别评分,随时根据结果调整模型训练过程。

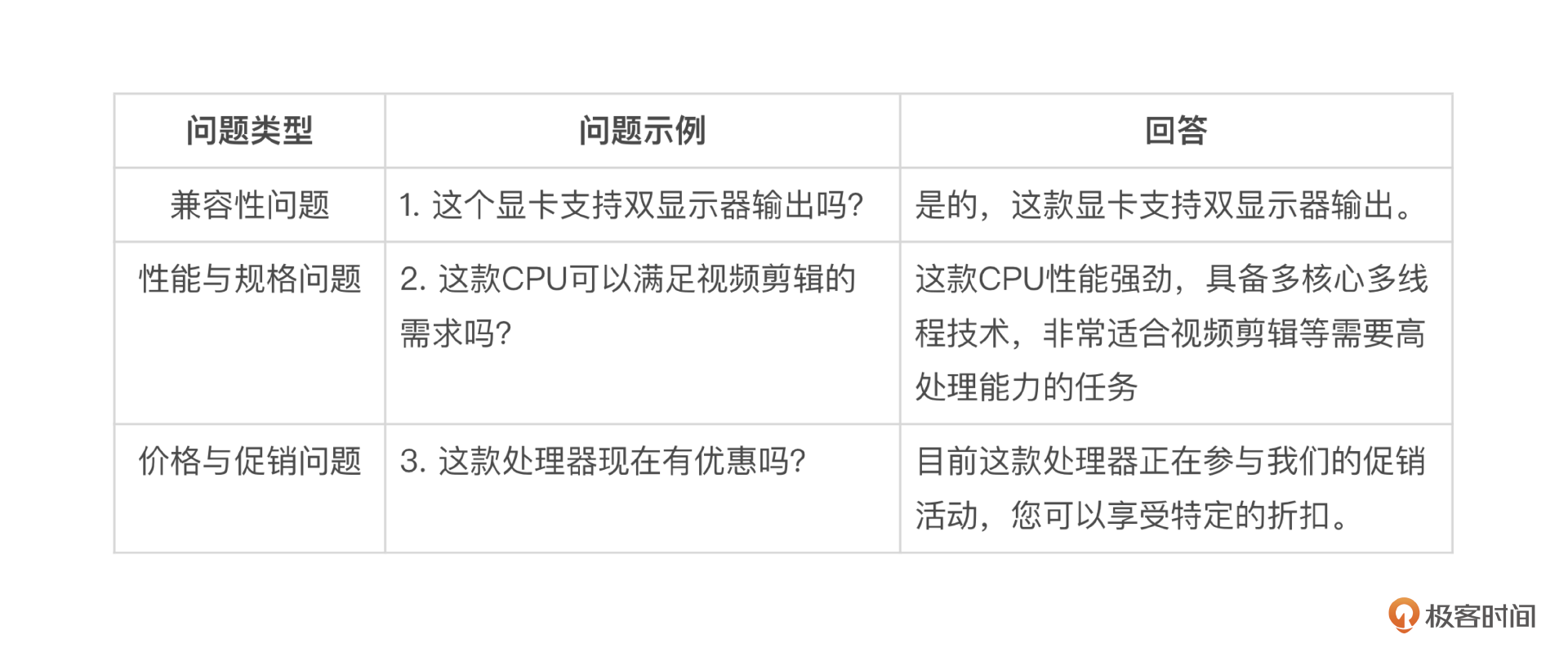

如果这 3 个测评非要做一个重要性排序的话,那么人工测评其实是最重要的。人工测评的方法是将智能客服项目最关心的能力设计为一系列问题,把问题和期望的回答写到 Excel 表格中,由人工挨个根据微调后的大模型进行评分。

需要注意,在智能客服上线之后遇到的新问题也要补充到表格里。

如果说人工测评是测试大模型微调后有多少新能力,那么通用测试集测评则是保证大模型基础和通用能力不下降。通用测试集一般是公开的,我们只要用测试集对微调后的大模型测评,结果和原有大模型的评分对比即可。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 电商客服模型的能力测评是整个项目的核心,需要在发布之前进行充分测试,以确保发布后不出现bug。 2. 采用人工测评+自动化测评结合的方案,包括人工测评、通用测评和私有task测评。 3. MMLU数据集是一个通用能力测试数据集,用于评估模型在不同领域的知识掌握情况。 4. LM-Evaluation-Harness 是一个用于评估和比较语言模型性能的工具包,可以用于评估各种开源的大模型。 5. 私有task评分也是全自动测评,基本思想是针对智能客服项目,设计关键的问题和标准答案,用自动化测评的方法来评估这些问题,并得到评分。 6. 配置文件中的 `输入列` 和 `目标列` 需要和数据集字段对应,配置文件中的 `metric_list` 表示评估算法,需要根据具体情况自定义评估算法。 7. BLEU算法被选用作为评估算法,用于评估模型的性能。 8. 在大模型微调项目中,评估过程和数据工程同样重要,需要经过数据->训练->评估->修改数据的循环过程才能微调完成。 9. 大模型微调后,原有基础能力不能下降,可以通过通用测评数据集的测评来完成,这一步和私有task一样,都可以通过 LM-Evaluation-Harness 测评框架自动化完成。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《AI 大模型项目落地实战》,新⼈⾸单¥59

《AI 大模型项目落地实战》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论