25 | Transform:Beam数据转换操作的抽象方法

该思维导图由 AI 生成,仅供参考

- 深入了解

- 翻译

- 解释

- 总结

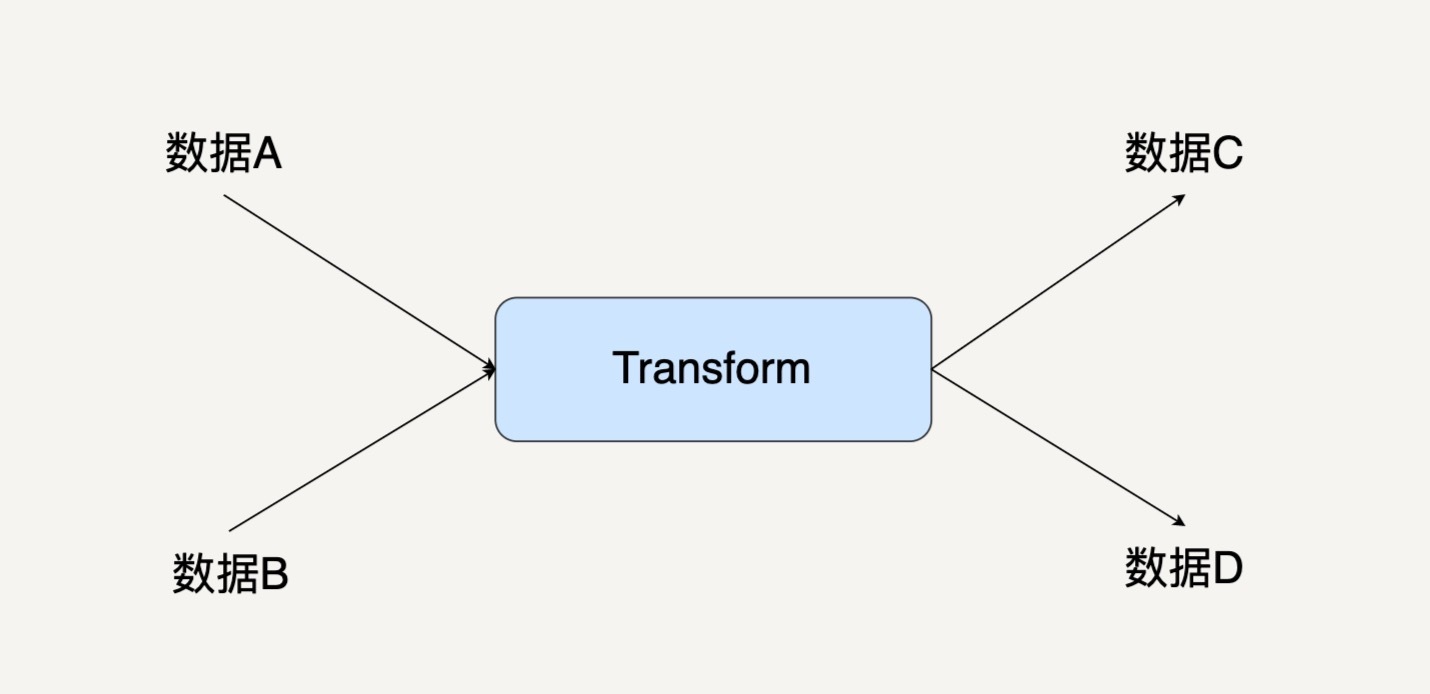

Beam数据转换操作的抽象方法通过Transform将数据转换成有向图中的节点,而PCollection则是有向图中的边。Transform的基本使用方法是通过apply()函数调用,常见的Transform接口包括ParDo和GroupByKey。ParDo是一种通用的并行处理数据操作,而GroupByKey则是按Key归并数据集。Stateful Transform和side input/side output是必用的技术点,可以实现有状态的数据处理。Transform的优化是通过lazy execution实现的,可以让Beam的优化器合并操作。文章内容涵盖了Beam数据转换操作的基本概念和常见应用场景,适合读者快速了解Beam数据处理框架的特点和使用方法。 文章中介绍了Transform的概念和基本的使用方法,通过简单的例子让读者了解如何编写Transform的编程模型DoFn类。有状态DoFn在实际应用中尤其常见,读者可以多加关注。此外,文章还提出了一个思考题,探讨了Beam的ParDo与Spark的map()或者MapReduce的map之间的相似之处和不一样之处,引发读者思考和讨论。 总的来说,这篇文章通过简洁明了的语言和实际例子,帮助读者快速了解了Beam数据处理框架的特点和使用方法,同时引发了读者的思考和讨论。

《大规模数据处理实战》,新⼈⾸单¥59

全部留言(11)

- 最新

- 精选

常超1.ParDo支持数据输出到多个PCollection,而Spark和MapReduce的map可以说是单线的。 2.ParDo提供内建的状态存储机制,而Spark和MapReduce没有(Spark Streaming有mapWithState )。

常超1.ParDo支持数据输出到多个PCollection,而Spark和MapReduce的map可以说是单线的。 2.ParDo提供内建的状态存储机制,而Spark和MapReduce没有(Spark Streaming有mapWithState )。作者回复: 不错的总结!

2019-06-19217 cricket1981ParDo能指定并行度吗?

cricket1981ParDo能指定并行度吗?作者回复: 谢谢你的提问!ParDo的level好像是不行的,如果对于整个数据流水线来说的话,可以指定numWorkers。

2019-06-192 LJKParDo是不是跟map一个意思?

LJKParDo是不是跟map一个意思?作者回复: 不是。map是一个input一个output,map是一个input可以有0个或者多个output

2019-08-221 柳年思水ParDo 有点自定义 UDX 的意思,而 Spark 或 Flink 除了支持 UDX,还内置很多常用的算子

柳年思水ParDo 有点自定义 UDX 的意思,而 Spark 或 Flink 除了支持 UDX,还内置很多常用的算子作者回复: 谢谢你的留言!其实Beam也有非常多内置的常用Transform。

2019-07-20- sxpujsSpark的算子和函数非常方便和灵活,这种通用的DoFn反而很别扭。2019-06-209

vigo推荐python,然而这章又几乎全是java事例2019-10-118

vigo推荐python,然而这章又几乎全是java事例2019-10-118 微思Statefullness、side input/side output相关的例子可以再多一点。2019-06-192

微思Statefullness、side input/side output相关的例子可以再多一点。2019-06-192 老莫mac刚开始接触并行处理架构,之前看了FLINK,后来公司选型用SPARK,走回学习SPARK的路。看了SPARK 的BEAM,我只有一个感觉,和FLINK的理念何其相像,每个处理步骤或者概念FLINK都有对应的实现。BEAM要在FLINK上面加一层,会损失效率。所以我能想象到的好处只有一个,就是BEAM能同时在FLINK和SPARK上运行,汇聚两边的结果。为了将两种不同的架构当成一种来使用,把处理目标PCOLLECTION 当成流,当成KAFKA往两边分发,两边时独立的消息处理,把结果返回,在某个地方REDUCE 或者SHUFFLE,得到结果。感觉本质上就是这样。2020-06-031

老莫mac刚开始接触并行处理架构,之前看了FLINK,后来公司选型用SPARK,走回学习SPARK的路。看了SPARK 的BEAM,我只有一个感觉,和FLINK的理念何其相像,每个处理步骤或者概念FLINK都有对应的实现。BEAM要在FLINK上面加一层,会损失效率。所以我能想象到的好处只有一个,就是BEAM能同时在FLINK和SPARK上运行,汇聚两边的结果。为了将两种不同的架构当成一种来使用,把处理目标PCOLLECTION 当成流,当成KAFKA往两边分发,两边时独立的消息处理,把结果返回,在某个地方REDUCE 或者SHUFFLE,得到结果。感觉本质上就是这样。2020-06-031 Junjie.M老师,当一个transform有多个输入pcollection时如何调用transform,是合并pcollection后调用还是各自调用。还有一个transform如何输出多个pcollection。可以给个代码示例吗2020-04-121

Junjie.M老师,当一个transform有多个输入pcollection时如何调用transform,是合并pcollection后调用还是各自调用。还有一个transform如何输出多个pcollection。可以给个代码示例吗2020-04-121 阿里斯托芬ParDo应该可以理解为是一个flatmap操作,不过是一个操作更加丰富的flatmap2022-05-17

阿里斯托芬ParDo应该可以理解为是一个flatmap操作,不过是一个操作更加丰富的flatmap2022-05-17