DeepSeek如何赋能Python编程?

尹会生

DeepSeek R1 降低了大模型的使用门槛,开发者可通过 Chat、IDE 集成、API 三种方式将其融入开发流程,结合 Python 快速实现业务集成与原型验证,提升效率,推动 AI 与实际业务深度融合。

00:00 / 00:00

1.0x

- 3.0x

- 2.5x

- 2.0x

- 1.5x

- 1.25x

- 1.0x

- 0.75x

- 0.5x

大家好,我是尹会生。

今天主要想和大家介绍一下 DeepSeek R1。从春节以来,相信大家可能已经频繁听到这个词了,那我们该如何跟进这样一个热门技术呢?今天的直播内容一方面是为了缓解我们自身的学习焦虑,另一方面也是希望大家能快速将大模型与自身业务结合,真正享受 AI 编程和大模型带来的技术红利。

在今天的直播里,我会围绕以下几个部分展开:

DeepSeek R1 发布后,它与传统大模型相比,在软件开发领域的应用有哪些不同和变化?

关于 Python 编程的重要性。我们发现,真正要把大模型用得好,最好能将其接入实际业务,而这通常需要通过 Python 编程来实现。那么为什么是 Python,而不是其他语言?

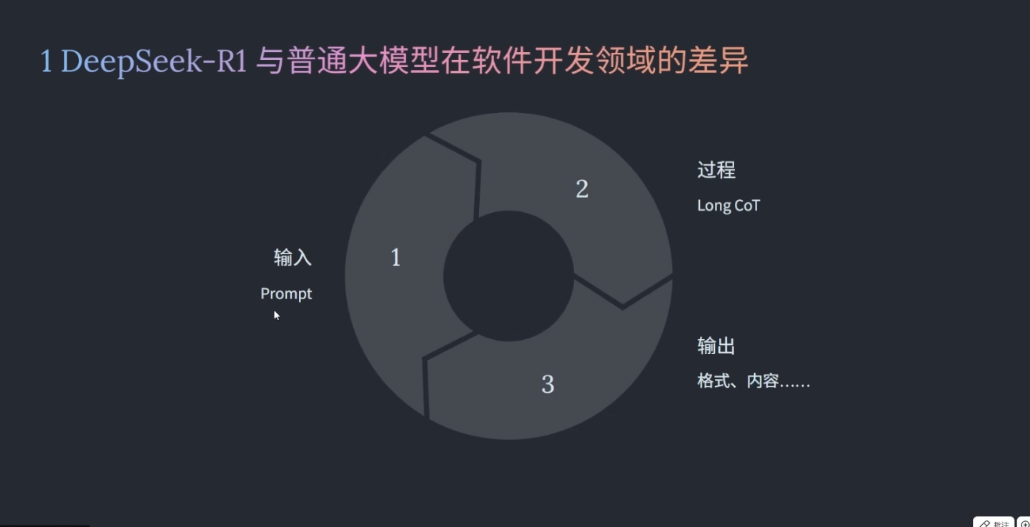

首先是 DeepSeek R1 和传统大模型在软件开发中的差异。作为程序员或开发者,我们更习惯用自己熟悉的思路和方法去分析一个工具。所以我们不会像 AI 专家或算法研究员那样,一上来就钻研强化学习、MoE 架构或者思维链这些底层技术。我们更愿意把整个系统看作一个已经上线的应用,去观察它的输入、输出,以及中间的处理过程。

因此,分析 DeepSeek R1,我们完全可以从自己熟悉的角度入手:输入、输出和过程控制。把它当作一个黑盒,从外部行为来理解它的特点。

首先,最明显的差异之一体现在输入环节,也就是“提示词”部分。我们对比一下,以前用普通大模型时是得学一些提示词公式的,比如 CRISPE 提示框架(角色、任务、步骤、输出等),经常需要明确这些结构。本质上,这就像开发系统时定义输入规范。

传统大模型在处理输入时其实挺“挑剔”的,如果你只抛出一个简单问题,它返回的结果往往不理想。但没有人一开始就告诉你,提问大模型还有个“潜规则”——叫提示词工程(Prompt Engineering)。在没掌握这个技巧之前,你反复尝试,效果还是不好,这就容易陷入恶性循环。

这就好比我们在公司里同时维护 A、B 两套软件:A 系统一直很稳定,B 系统却动不动就崩溃。时间一长,团队自然就不愿意用 B 了。技术选型也是同样的道理。

所以你会发现,传统大模型在实际业务落地中主要有这么几个难点:

你得反复调试提示词,不断尝试不同写法;

不同的提示词在不同的模型上表现还不一样——不同厂商、不同参数规模,甚至因为量化、蒸馏等技术,模型的实际表现千差万别。这就带来一个问题:没有统一的输入标准,调试成本非常高。

这就好比你写了一段代码交给测试,测试反馈说:“你这 100 行代码里有 200 个 Bug,修好再测。”这时候你是什么心情?是不是恨不得推倒重写?其实早期用普通大模型效果不好,很多时候问题就出在提示词设计上,而 DeepSeek R1 推出后大家普遍反馈更友好,也正是因为它很大程度上缓解了这个问题。

传统大模型中,提示词有很多“框架”要掌握,比如 CRISPE、QCIP-SPE 等等,它们确实能提升输出质量,但前提是你得知道这些方法、甚至背下这些模式。于是有人就想:能不能让大模型自己思考?这就引申出了“思维链”(Chain-of-Thought,CoT)——也就是一步步引导模型推理。

再后来,还出现了像“扣子”、DeFi、甚至微软的“提示词自动生成器”这类 Agent 工具,本质上都是为了降低输入设计的难度。理想情况下,我们希望能用最自然、最直接的语言表达需求,模型就能理解并输出好结果。

而 DeepSeek R1 作为一款推理优化模型,恰恰在这方面表现突出:我们不再需要套用复杂的提示词框架,用“说人话”的方式提问,它就能稳定输出我们想要的答案。这意味着使用大模型的门槛被大幅降低了。而门槛降低带来的一个直接好处就是:用大模型学习一门新编程语言(比如 Python)变得更简单。以前你既要学编程,还要学怎么“问问题”,现在你可以更专注于问题本身,直接提问、直接获取解答。

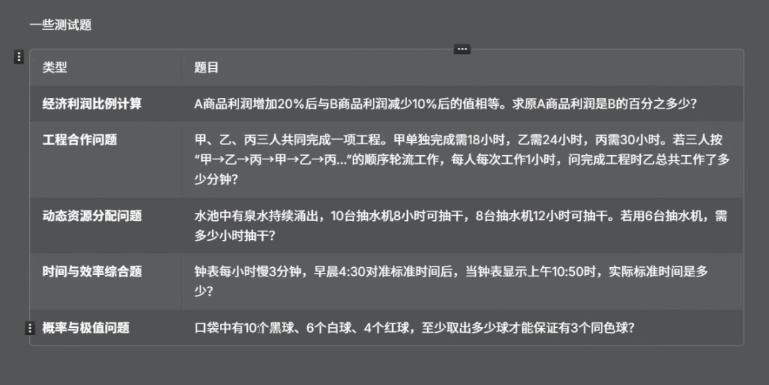

除了输入上的差异,DeepSeek R1 和传统大模型在“中间推理过程”上也有明显的不同,它支持更长的思维链(Long CoT)。不知道你有没有留意过,DeepSeek R1 不仅结果准确,它的思考过程也非常有参考价值。举个例子,我们可以用一些数学题或逻辑题(比如利润计算、工程合作问题)测试它的推理能力。这类问题没法直接得出答案,必须经过多步推导——就像产品经理提的需求,不能直接编码,得先转成开发逻辑。这时候,如果你观察 DeepSeek R1 的返回内容,它的中间推理过程实际上是在示范“如何分解问题、如何分步思考”。这个过程对我们自己分析复杂业务需求也很有帮助。

随着时间的推移,写代码久了你会发现,纯编程的硬技能(数据结构、算法、封装抽象)反而不是最难的,更难的是如何把现实需求映射成代码逻辑。如果有人能展示他的思考过程,其实是很好的学习机会。所以建议大家在使用 DeepSeek R1 时,除了看结果,也多关注它的推理链——这是隐形的学习资源。

最后是输出环节。DeepSeek R1 在软件开发场景中,无论是代码格式还是内容准确性,通常都比普通大模型表现得更稳定,但有一点要提醒:不要“画蛇添足”。意思是使用 DeepSeek R1 的时候,不用加一堆“请认真思考”“请再检查一下”这样的冗余指令,而是越直接,效果反而越好。但如果用的是传统大模型(比如 DeepSeek V3)的话,那可不能偷懒,该写的约束和上下文都得写清楚,否则它容易“自由发挥”。比如说,你让它模拟一个抽硬币概率的问题,如果附加一句“请认真思考”,它可能真会多想十分钟,导致响应变慢,还不见得更准。所以,自然、直接、清晰的提问,在 R1 上才是最高效的。

简单来说就是:用 R1,别加戏;用 V3,别偷懒。这是一个非常实用的指导原则,建议大家在实际使用中体会这两种策略的差异。

好,那从应用的角度我们已经分析了 DeepSeek R1 和传统大模型在输入、推理、输出这几个方面的区别。如果大家有兴趣,强烈建议亲自上手试一试,尤其关注:

它的提示词是否真的更“自然”;

它的 Long CoT(长思维链)是如何一步步展开的;

它的输出结构是不是更清晰。

至于 DeepSeek R1 底层的一些技术,比如 MoE(混合专家模型)、强化学习、SFT(有监督微调)等等,这次我们就不深入了。这些内容在其他视频和文章中已经讲得很透彻,我们这次更聚焦在“怎么用”而不是“为什么能”。

如果我们把 DeepSeek R1 看作一个函数,那么它的输入、处理、输出方式都发生了明显变化。那我们怎么把它嵌入到自己的开发流程中呢?本质上只有三种形式,也恰好对应软件开发中的三种典型场景:

Chat 方式:通过网页对话交互;

IDE 集成:嵌入到开发环境中,如 VS Code、PyCharm 等;

API 调用:通过接口集成到自研系统或自动化流程中。

为什么是这三种?其实它们恰好覆盖了从“理解需求”到“代码实现”的全过程:

Chat 方式适用于那些你还不清楚如何拆解的需求,或者某段代码你看不懂,需要借助大模型帮你理清思路、提升认知。它是“人机协作”的典型方式,核心是“通过交互搞懂问题”。举个例子,假如我们让 DeepSeek R1 “写一个 Python 版的 Transformer 演示程序”,它不只是直接吐代码,还会先分析你的意图。它会思考用户是要教学还是做技术验证?然后它会考虑模型规模、位置编码、注意力机制等关键部分,再给出适合理解和演示的代码。这个过程其实就是在帮你建立开发思路。

再比如,如果老板突然说“在我们游戏里加个贪吃蛇小游戏”,你第一反应可能是懵的:蛇怎么移动?食物怎么生成?规则怎么控制?这种场景就特别适合用 Chat 方式,让大模型帮你梳理设计逻辑。

所以我们说,Chat 形式的核心价值是:帮你和开发需求之间建立认知桥梁。它不是直接替代你写代码,而是先帮你把问题想清楚。

接下来,我们换一个角度提问。假设这个演示程序是写给 Java 工程师看的 Python 版 Transformer,你在编写的时候会考虑哪些问题?需要做哪些额外的思考?

这时候可能你会觉得 Chat 方式、IDE 集成、API 调用,这三种用法好像差不多。但实际上,它们对应的是不同的使用场景,解决不同的问题。这也是为什么 DeepSeek R1 最近这么受欢迎——它的“思考过程”本身就很有启发性。如果没有 R1,你生成的可能就只是一段代码;但有了 R1,它还会帮你考虑“这段代码写给谁看?他能不能看懂?”比如这段 Python 代码如果交给 Java 工程师,他可能看得懂,也可能完全懵。那我们自己在写的时候,如果要让 Java 工程师能理解,需要考虑什么呢?是不是得考虑 Java 工程师的编码习惯?比如:

Java 常用静态类型,而 Python 是动态类型,这会不会增加理解难度?

Python 语法更简洁,但 Java 工程师是否习惯这种表达?

导入哪些库?示例数据怎么设计?

要不要加注释?注释怎么写更符合 Java 工程师的习惯?

你会发现,DeepSeek R1 其实把这些细节都考虑进去了。这就是我们说的第一种使用方式:Chat 方式。Chat 方式的核心作用是对齐:对齐认知、对齐理解、对齐表达。

第二种方式是 IDE 集成,这可能是对程序员效率提升最直接的一种方式。它能在编写代码的过程中实时提供建议、检查代码逻辑、甚至补全复杂结构。

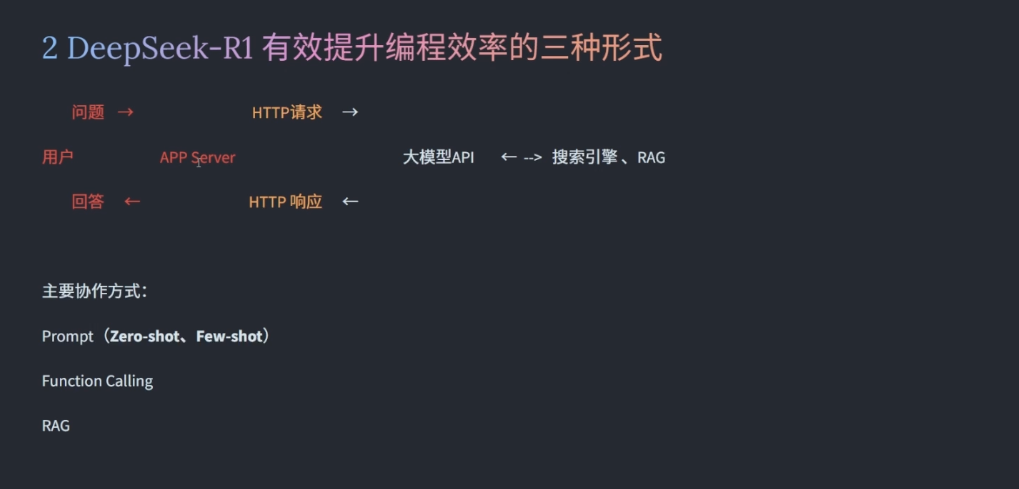

第三种方式是 API 调用。当前两种方式都不适用时,API 是唯一的替代方案,也是最接近“业务集成”的一种方式。很多人说:“大模型好像只能用在 ToC 场景,ToB 不知道怎么接?”其实不然。

如果我们把现有业务系统抽象一下,无非是用户发起请求,服务器处理并返回,中间可能涉及数据库、缓存(如 Redis)、对象存储等。那么接入大模型也非常简单:只需要在应用层后面新开一个接口,发起一个 HTTP 请求,把用户输入传给大模型,再把它返回的结果整合回你的业务逻辑中。

就像这张架构图所示:用户请求先到你的业务服务器,服务器再调用大模型 API,拿到结果后再返回给用户,整个过程清晰、直接、可扩展。

这样一来,我们的系统就具备大模型的能力了。但引入了新能力,关键是要解决实际问题,那大模型主要用来处理哪些传统应用搞不定的问题呢?举个例子,比如一些票务 App 都有一条规则:某些特价票一旦购买,是不能退的。但如果用户确实去不了,规则又允许“直系亲属”代为使用。这时候用户可能会有各种问法:

“我爸妈能去吗?”

“我儿子女儿能去吗?”

“我侄子算不算?”

“我老婆能不能用?”

“我媳妇行不行?”

你看,问题虽然相似,但表述五花八门。如果全靠人工客服回答,成本高、响应慢,还容易不一致。

而大模型正好擅长处理这类语义模糊、表达多样的问题。我们可以在 App 后台接入大模型 API,把用户问题抛给它,比如:“我儿子能不能去?”大模型能理解“儿子”属于“直系亲属”,返回“可以”,我们再把这个结果用更友好、更人性化的方式回复给用户。这样一个以前需要人工介入的场景,就通过大模型实现了自动化和智能化。

但你可能会问:大模型一定能准确回答吗?显然不能 100% 保证。这时候就需要一些技术手段来补充,比如:

Prompt 设计:用户的问题是“我儿子能不能去?”,直接抛给大模型可能缺乏上下文。我们需要在请求前用 Prompt 补充背景,比如明确规则是“仅限直系亲属使用”,甚至必要时反问用户补全信息。比如推荐手机时,如果用户说“我要拍照好的”,系统不能直接瞎推荐,而应该通过多轮对话明确品牌偏好、屏幕、电池、存储等需求。

知识库检索(RAG):面对专业问题(如票务规则、产品信息),可以先从知识库中检索准确信息,再让大模型基于这些信息生成回答。

Function Calling:有些问题需要实时查数据库,比如“我还有多少积分?”。我们可以对大模型进行微调,让模型能够将自然语言转成 SQL 查询。有时候还需要去网络中搜集信息,这时候就得调用搜索引擎。

你会发现,现在单纯“部署一个大模型”已经不稀奇了,真正的重点变成了:怎么让它更可靠?怎么让它接入业务? 也就是 RAG、Function Calling、知识库、工具调用这些技术。

而 DeepSeek R1 的优势就在于:Prompt 设计更简单、输出更稳定、工具调用能力更强,这样接入现有系统时,成本更低、效果更好。

最后我们总结一下,我们可以根据不同场景选择三种集成方式:

Chat 方式:适合前期理解和对齐需求,比如搞懂代码、分析业务;

IDE 集成:适合开发调试阶段,提升编码效率;

API 调用:适合与业务系统对接,实现自动化响应。

那为什么 Python 在这个过程中变得越来越重要了呢?其实,不管我们是用 Chat 方式、IDE 集成,还是 API 调用,本质上都是在做技术验证或原型开发,而 Python 最大的优势就是能快速实现业务逻辑,它是一门真正的“胶水语言”。

有了大模型之后,我们可以直接用自然语言描述需求,通过 Chat 方式生成 Python 代码,几乎是一对一的映射。尤其是 DeepSeek R1 推出之后,生成代码的质量和准确性都明显提升。

Python 不仅能快速处理中间流程,还有很多成熟的大模型相关框架(比如 LangChain、LlamaIndex),让我们可以轻松集成 RAG、Agent 等功能。我们可以先把框架嵌入业务,灰度一部分流量看效果,如果验证成功,再改写成 Go 或 Java——这种“小步快跑”的方式非常高效。

此外,Python 在深度学习、数据科学(如 Pandas、NumPy)、物联网、金融计算等领域都有强大的生态支持。我们可以用 Python 快速接入大模型,发起 HTTP 请求、处理响应,甚至构建完整的数据处理和业务链路。

那么今天的分享就到这里。在这次分享里,我们一同探索了 DeepSeek R1 如何以更自然、更高效的方式融入开发流程,从提示词优化、长思维链推理,到三种集成形态——Chat、IDE 和 API,以及 Python 作为“胶水语言”在大模型落地中的关键作用。

技术的本质是为人所用。DeepSeek R1 的出现,不仅降低了大模型的使用门槛,更让我们看到 AI 与业务结合的真实可能性。它不再是一个遥不可及的技术概念,而是可以切实帮助你我提升开发效率、扩展能力边界的实用工具。

我希望大家多多动手尝试,从一个小需求开始,用 DeepSeek R1 写一段代码、解一个问题、甚至搭建一个原型。只有亲自实践过,才能体会到这轮技术变革的力量,才能发现属于你自己的、人机协同的最佳模式。

未来属于敢于探索和快速学习的人。愿我们都能在 AI 的浪潮中,保持好奇,积极实践,做那个率先把技术转化为价值的人。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. DeepSeek R1在软件开发中的应用有明显的不同,特别是在输入环节的提示词设计上更加友好和稳定,降低了使用大模型的门槛。 2. DeepSeek R1支持更长的思维链,为开发者提供了隐形的学习资源,对于理解复杂业务需求具有参考价值。 3. DeepSeek R1在软件开发场景中的输出表现更加稳定,不需要加入冗余指令,而传统大模型则需要更多的约束和上下文。 4. DeepSeek R1可以通过Chat方式、IDE集成和API调用三种形式嵌入到开发流程中,覆盖了从理解需求到代码实现的全过程。 5. Chat方式的核心价值在于帮助建立认知桥梁,对齐需求和理解。 6. IDE集成适合开发调试阶段,提升编码效率。 7. API调用适合与业务系统对接,实现自动化响应。 8. Python在大模型落地中扮演着关键角色,能快速实现业务逻辑,是一门真正的“胶水语言”。 9. DeepSeek R1的出现降低了大模型的使用门槛,让AI与业务结合成为可能,提升开发效率、扩展能力边界。

2025-12-12给文章提建议

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《极客时间 VIP · 干货直播稿精选》

《极客时间 VIP · 干货直播稿精选》

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论