OpenAI 创始成员用 1000 行 C 代码手搓了一个大模型,Mac 即可运行!网友:真男人就该用C编程

核子可乐、Tina

徒手用 1000 行 C 语言实现,不依赖庞大的外部库,Mac 即可运行。

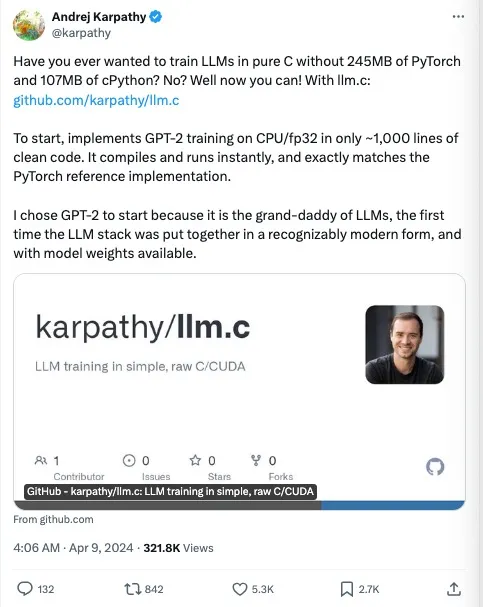

如今这年头,徒手写神经网络代码已经不算事儿了,现在流行手搓大模型训练代码了!这不,今天,特斯拉前 AI 总监、OpenAI 创始团队成员 Andrej Karpathy 仅用 1000 行简洁的 C 代码,就完成了 GPT-2 大模型训练过程。

几个小时前,Andrej Karpathy 推出了一个名为 llm.c 的项目,旨在用纯 C 语言训练 LLM,这种方法的主要优势在于它显著减少了依赖库的体积——不再需要 245MB 的 PyTorch 和 107MB 的 cPython,这样可以使得模型训练过程更为轻量化和高效。该项目还可以立即编译和运行,并且可以与 PyTorch 的参考实现媲美。

Karpathy 表示他之所以选择 GPT-2 作为首个工作示例,是因为它大语言模型鼻祖的定位,亦属现代 AI 堆栈的首次组合。因此,选择 GPT-2 作为起点,可以让我们更容易地理解和实践大型语言模型训练。

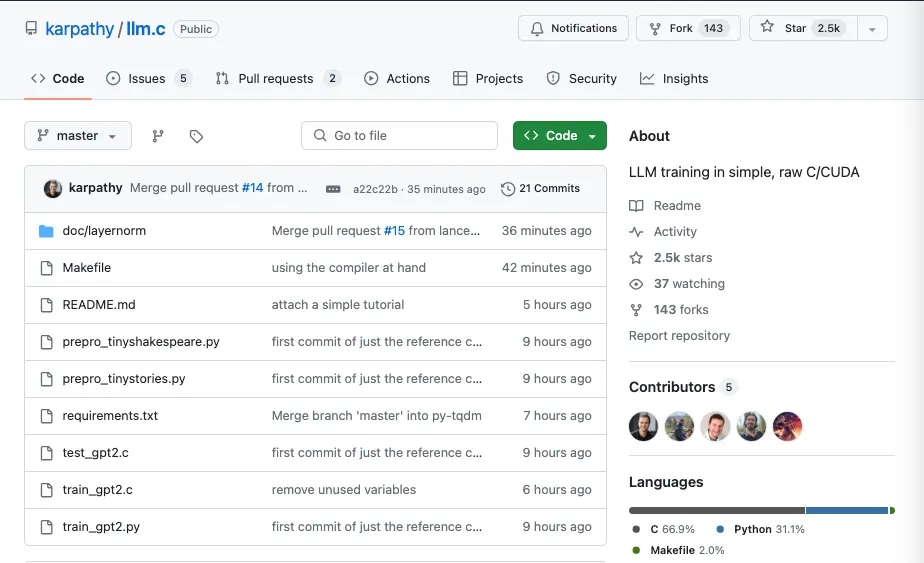

徒手实现 GPT-2 后,Karpathy 将这份代码放到了 GitHub 上,以 MIT 协议开源。短短几个小时,就超过了 2500 颗星,并且数据还在不断持续上涨…

将大模型原理拆解得无比简单

Andrej Karpathy 是全球人工智能领域的知名科学家,也是 OpenAI 的创始成员和研究科学家。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 特斯拉前 AI 总监、OpenAI 创始团队成员 Andrej Karpathy 用 1000 行简洁的 C 代码完成了 GPT-2 大模型训练过程,并将代码以 MIT 协议开源。 2. Karpathy 通过 llm.c 项目探索了一种更简单、更高效的训练大语言模型(LLM)的方法,主要优势在于减少了对庞大外部库的依赖,使得模型训练过程更为轻量化和高效。 3. 他选择 GPT-2 作为首个工作示例,以便更容易地理解和实践大型语言模型训练。 4. Karpathy 以更简单、更原始的 C/CUDA 架构来做 LLM 的训练,其中还涉及算法优化、计算资源管理等多个方面。 5. 通过 llm.c 项目,Karpathy 探索了一种更简单、更高效的训练大语言模型(LLM)的方法,减少了对庞大外部库的依赖,使得模型训练过程更为轻量化和高效。 6. 他通过 llm.c 项目探索了一种更简单、更高效的训练大语言模型(LLM)的方法,主要优势在于减少了对庞大外部库的依赖,使得模型训练过程更为轻量化和高效。 7. Karpathy 以更简单、更原始的 C/CUDA 架构来做 LLM 的训练,其中还涉及算法优化、计算资源管理等多个方面。

该试读文章来自《AI 前线》,如需阅读全部文章,

请先领取课程

请先领取课程

免费领取

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论