16|性能评估:不平衡数据集应该使用何种评估指标?

- 深入了解

- 翻译

- 解释

- 总结

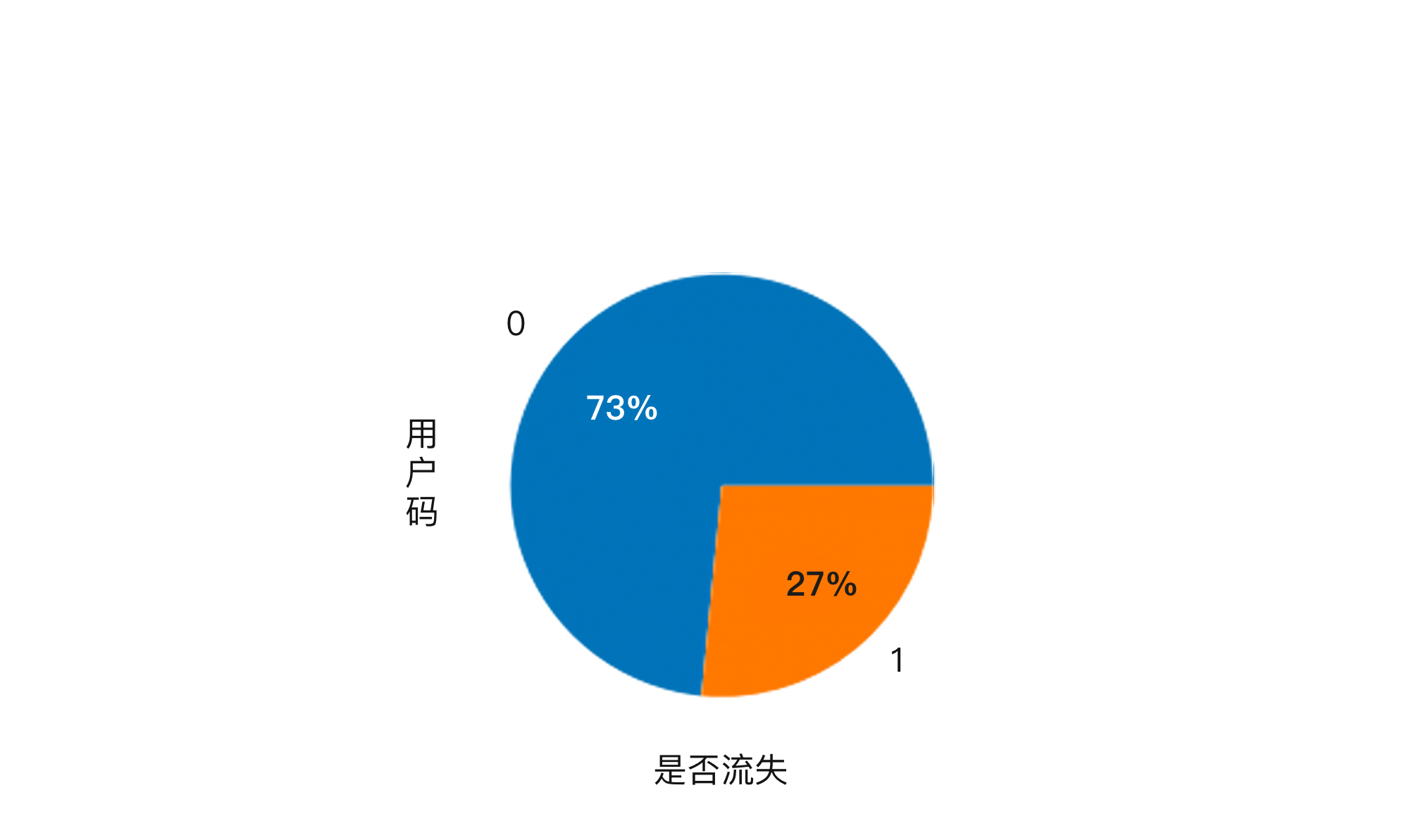

本文介绍了在机器学习中处理不平衡数据集时的性能评估方法。作者首先以一个例子引出了准确率无法完全反映模型分类性能的问题,强调了对于不平衡数据集,单一使用准确率作为评估标准是不合适的。随后,作者介绍了混淆矩阵、精确率和召回率这些重要的评估指标,以及如何计算和展示模型的混淆矩阵。文章还介绍了F1分数作为综合评估指标,能够更全面地评估模型的性能。通过具体案例和技术细节,读者可以深入了解不平衡数据集的性能评估方法,对模型的优劣进行客观评价。此外,文章还介绍了ROC曲线和AUC值的重要性,以及如何通过这些工具来比较不同模型的分类性能。最后,作者提出了两道思考题,引导读者思考如何优化神经网络模型以及如何使用分层采样来进行模型验证。整体而言,本文通过深入浅出的方式,为读者提供了处理不平衡数据集时的性能评估方法,为机器学习领域的从业者提供了有益的技术指导。

《零基础实战机器学习》,新⼈⾸单¥59

全部留言(4)

- 最新

- 精选

王平

王平 一个样本集合只能算出一个TPR和FPR,那为什么会能有多个点形成曲线呢

一个样本集合只能算出一个TPR和FPR,那为什么会能有多个点形成曲线呢作者回复: 当我们讨论TPR (真正率) 和FPR (假正率) 形成的曲线时,我们通常指的是ROC曲线(Receiver Operating Characteristic Curve)。ROC曲线中的每一个点都是基于一个特定的决策阈值得到的。 为了构造ROC曲线,我们不是只对数据集进行一次二分类预测。而是,对于每一个可能的决策阈值,都计算一次TPR和FPR,并在ROC空间中为这个阈值画一个点。将所有这些点连接起来,就得到了ROC曲线。 让我给你一个具体的例子来解释: 假设我们有一个二分类问题,而分类器为每一个样本输出一个概率,表示该样本为正类的概率。常见的决策阈值是0.5:即如果一个样本的概率大于0.5,我们预测它为正类,否则为负类。 但0.5只是其中一个可能的阈值。我们可以将阈值从0变到1,计算出每个阈值对应的TPR和FPR。 当阈值为0时,我们预测所有样本都为正类,这时FPR和TPR都是1。 当阈值为1时,我们预测所有样本都为负类,这时FPR和TPR都是0。 在0到1之间的每一个可能的阈值都会给我们一个不同的TPR和FPR,这就是为什么我们可以得到多个点并形成一个ROC曲线的原因。

2023-02-18归属地:上海1 在路上佳哥好,我认为今天的内容关键在于理解“预测值和真值共同组成的矩阵”,查准率、查全率和ROC曲线都是基于这个矩阵计算。我喜欢用真阳、假阳、真阴、假阴来理解这个矩阵,因为读医学相关内容时常看到“假阳性”一词。查准率是所有预测值为阳性的样本中确实是阳性的比率,查全率是所有实际值为阳性的样本中被预测为阳性的比率。假阳性就是没病的被当成了有病的,查准率就是1-假阳性概率。

在路上佳哥好,我认为今天的内容关键在于理解“预测值和真值共同组成的矩阵”,查准率、查全率和ROC曲线都是基于这个矩阵计算。我喜欢用真阳、假阳、真阴、假阴来理解这个矩阵,因为读医学相关内容时常看到“假阳性”一词。查准率是所有预测值为阳性的样本中确实是阳性的比率,查全率是所有实际值为阳性的样本中被预测为阳性的比率。假阳性就是没病的被当成了有病的,查准率就是1-假阳性概率。作者回复: 嗯,我也觉得。真阳、假阳比真正、假正好理解。因为我们体检报告啥的会经常读到,因此较容易关联起来。 以后我写文章时会以真阳、假阳为主!🎃

2021-10-08 谦佳哥,对于不平衡数据集,训练的时候会不会容易造成模型更倾向于把比例较大的分类分对呢?因为训练的时候是降低整体损失,比例较大的分类对损失的贡献度应该更大,最后变成了模型更倾向于把比例较大的分对?

谦佳哥,对于不平衡数据集,训练的时候会不会容易造成模型更倾向于把比例较大的分类分对呢?因为训练的时候是降低整体损失,比例较大的分类对损失的贡献度应该更大,最后变成了模型更倾向于把比例较大的分对?作者回复: 有可能,所以很多人会使用SMOTE的方法增加少数类样本的数量,把不平衡的数据集弄得较为平衡。

2021-10-042- Geek_b64f09老师好,我对这个不是太理解:“当阈值为1时,我们预测所有样本都为负类,这时FPR和TPR都是0”。我认为当阈值为1的时候,TP, FP都是0,但是FN好像也是0,这样的话,FPR可以等于0,但是TPR成了0除以0,好像没有意义。不知道这个理解是哪里不合适,希望老师指教,谢谢。2024-01-24归属地:广东