19|企业员工AI助理编程:实现多Agent

李锟

你好,我是李锟。

在上一节课中,我们探索了开发 AI 助理面临的两个技术难题,一个是支持语音输入,另一个是将 Web 应用与 AutoGPT Server 连接。我们初步确定了解决这两个难题的技术方案。这两个难题是两个不同的方向,可以独立解决,并且持续优化。这节课我们真正开始 AI 助理的开发工作。

AI 助理的分层架构

清晰的分层对于一个 Autonomous Agent 应用来说同样重要,我们从确定 AI 助理的分层架构开始开发。

第一版——四层架构

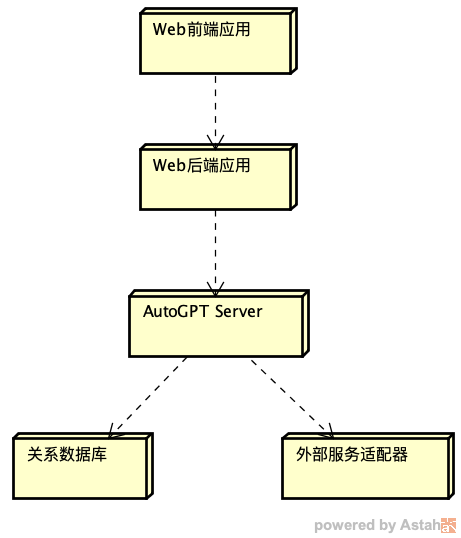

根据上节课的内容,我画了一个 AI 助理的部署图:

按照这个部署图,AI 助理可以简单划分为 4 层,从上到下单向依赖。最上层是 Web 前端 PWA 应用(JS 语言实现),为 AI 助理提供 UI,包括 GUI 和 VUI(语音用户界面)。第二层是 Web 后端 FastAPI 应用(Python 语言实现),为 Web 前端应用提供 RESTful API 和 WebSocket API。第三层是 AutoGPT Server,在其中运行多个业务相关 Agent,为 Web 后端提供 RESTful API 和 WebSocket API。最下面的第四层是基础设施层,包括关系数据库、外部服务适配器等等。

这个分层架构非常容易理解。 支持 WebSocket API 是为了获得更好的用户体验。当运行于 AutoGPT Server 中的某个 Agent 需要向 Web 前端的用户提供反馈(通知、建议、求助等等)时,使用以“推”方式工作的 WebSocket API 会比使用以 “拉” 方式工作的 RESTful API 更加高效。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. AI助理的分层架构是关键,包括Web前端PWA应用、Web后端FastAPI应用、AutoGPT Server和基础设施层的四层架构设计。 2. 通过合并Web后端应用与AutoGPT Server,实现了从四层架构到三层架构的优化,简化了架构并提高了效率。 3. 对AI助理智能体的角色建模是重要的,需要确定FastAPI应用与AutoGPT Server中的几个Agent的交互关系,以及AI助理的功能划分和实现方式。 4. 确定哪些功能需要放在AutoGPT Server中实现,哪些功能不需要,是关键的决策,需要考虑交互性和性能要求。 5. 创建了两个有代表性的入口Agent的框架代码:CollectionAgent和NotificationAgent。 6. 入口Agent的划分是粗粒度的,为了未来的可伸缩性和与AutoGPT Server的交互性考虑。 7. 下一步将具体实现入口Agent,包括其调用的细粒度Agent和相关的Block。 8. AutoGPT Server适合实现哪些类型的应用,不适合实现哪些类型的应用是需要思考的问题。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《LLM 自主智能体应用实战课》,新⼈⾸单¥59

《LLM 自主智能体应用实战课》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

全部留言(1)

- 最新

- 精选

颛顼此处当流量大了以后,要水平扩展,是将 AutoGPT Server 进行多副本部署?那每个AutoGPT Server实例负责启动6个关联的agent?这块不太理解,AutoGPT Server 是如何做到水平扩展的2025-02-21归属地:北京

颛顼此处当流量大了以后,要水平扩展,是将 AutoGPT Server 进行多副本部署?那每个AutoGPT Server实例负责启动6个关联的agent?这块不太理解,AutoGPT Server 是如何做到水平扩展的2025-02-21归属地:北京

收起评论