22|如何在与LLM交互过程中省钱及控制Rate Limits?

黄佳

你好,我是黄佳。

OpenAI 提供了强大的自然语言处理 API,但在将原型转移到生产环境时,管理与运行应用程序相关的成本是一个重要的挑战,尤其是当我们调用 OpenAI 家族中比较贵的模型的时候,这一讲我们来看看这方面的内容。

OpenAI 采用按使用量付费的定价模式,费用以 Token 为单位计算。Token 的价格因所使用的模型而异。为了估算成本,需要预测 Token 的使用量,考虑诸如流量水平、用户与应用程序交互的频率以及要处理的数据量等因素。

对话过程中的 Token

众所周知,语言模型以称为 Token 的块来读写文本。一个 Token 可以是一个字符、一个单词,甚至在某些语言中可以比一个字符更短或比一个单词更长。例如,“ChatGPT is great!” 这个句子被编码为六个 Token:[“Chat”, “G”, “PT”, “is”, “great”, “!”]。

API 调用中的 Token 总数会影响 API 调用的成本,也会影响 API 调用的时间。同时,总 Token 数必须低于模型所能容纳的最大限制。

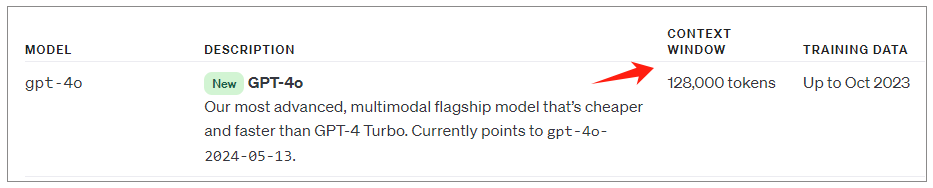

图中这个 Context Window,指的是输入输出能够容纳的 Token 总和。在 OpenAI 的 API 中,并没有对所能输出的 Token 进行限制,也就是说 max_tokens 是一个可选项。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. OpenAI采用按使用量付费的定价模式,费用以Token为单位计算,需要预测Token的使用量,考虑流量水平、用户与应用程序交互的频率以及要处理的数据量等因素。 2. Token的使用量会影响API调用的成本和时间,输入和输出Token都会被收费,而对于某些模型,输入Token和输出Token的每Token是不同的,一般来说,输入Token便宜些,输出Token更贵。 3. 控制Token数量的技巧包括精简提示词,定期对对话历史进行总结或压缩,追求简洁明了的提示,对模型进行微调以及实现查询结果的缓存机制。 4. OpenAI的速率限制系统采用了多维度的限制策略,包括每分钟请求数、每天请求数、每分钟Token数、每天Token数以及每分钟图像数等,开发者可以利用速率限制信息来优化他们的API调用策略,避免触发限制。 5. 面对速率限制,开发者可以采用指数退避重试机制和优化max_tokens参数来优化他们的API使用,另外,对于不需要即时响应的场景,可以考虑使用批处理来更有效地处理大量请求。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《大模型应用开发实战》,新⼈⾸单¥59

《大模型应用开发实战》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论