17|GPT-4o最强多模态模型实战

黄佳

你好,我是黄佳。

2024 年 5 月,又一个重磅炸弹从天而降。OpenAI 隆重推出了新的旗舰模型 GPT-4o,这个模型不仅更加强大,更加聪明,而且它的 API 还比老一代的 GPT-4-Turbo 更便宜。它最惊艳的特性就是多模态能力,尤其是在语音方面,它拥有把握人类语音中情感信息的能力(比如说仅通过语气发现你在和 ChatGPT4 对话时候是否焦躁、伤心、紧张、疲惫等),因此它能够更完美地实时处理音频、视觉和文本的推理。

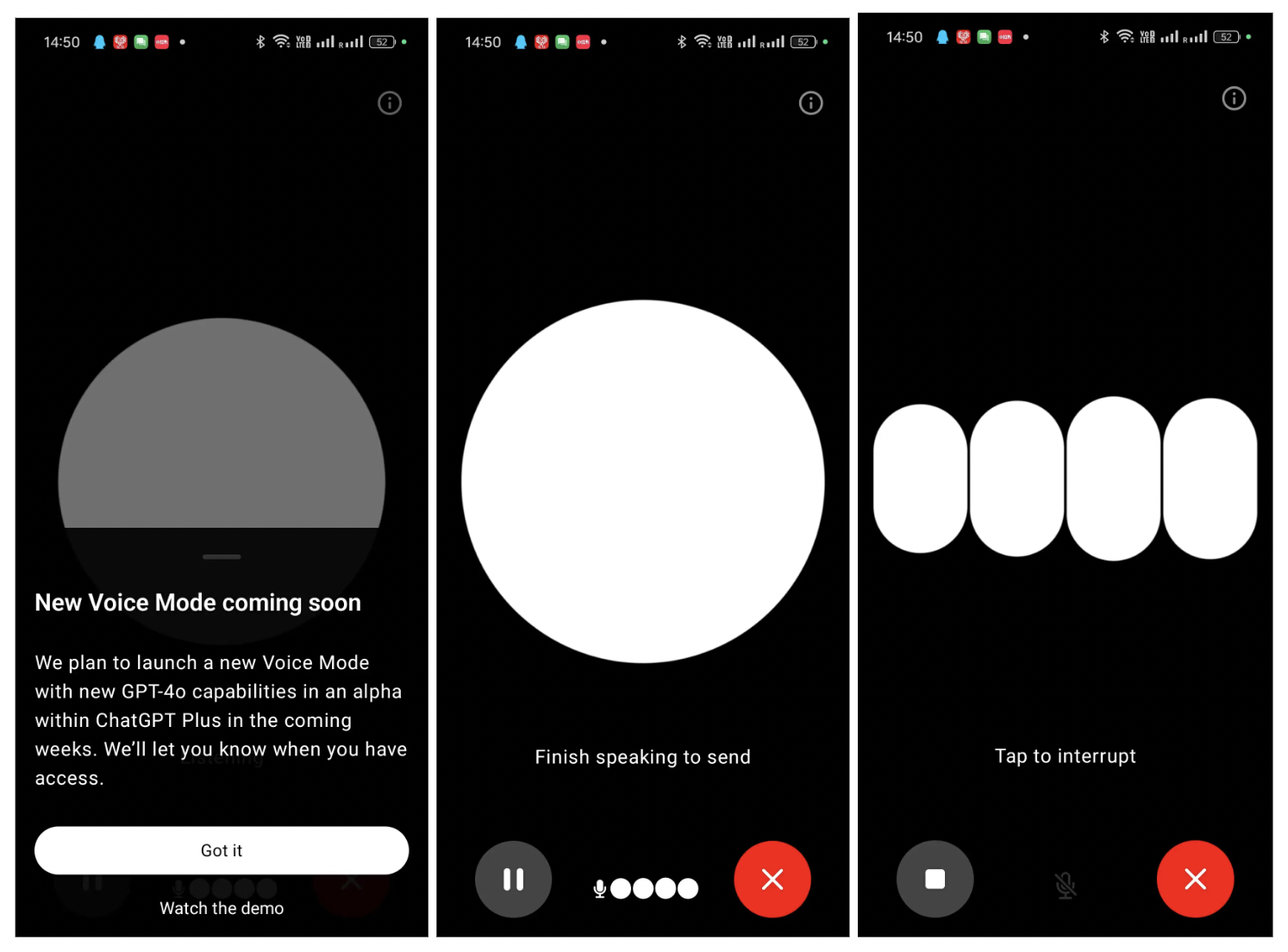

下面的几张图片,是我在 ChatGPT App 中和 GPT 对话的过程,惊喜地发现,GPT-4o 模型也即将在 App 中上线了。

ChatGPT 表示,GPT-4o 的新语音识别功能马上上线

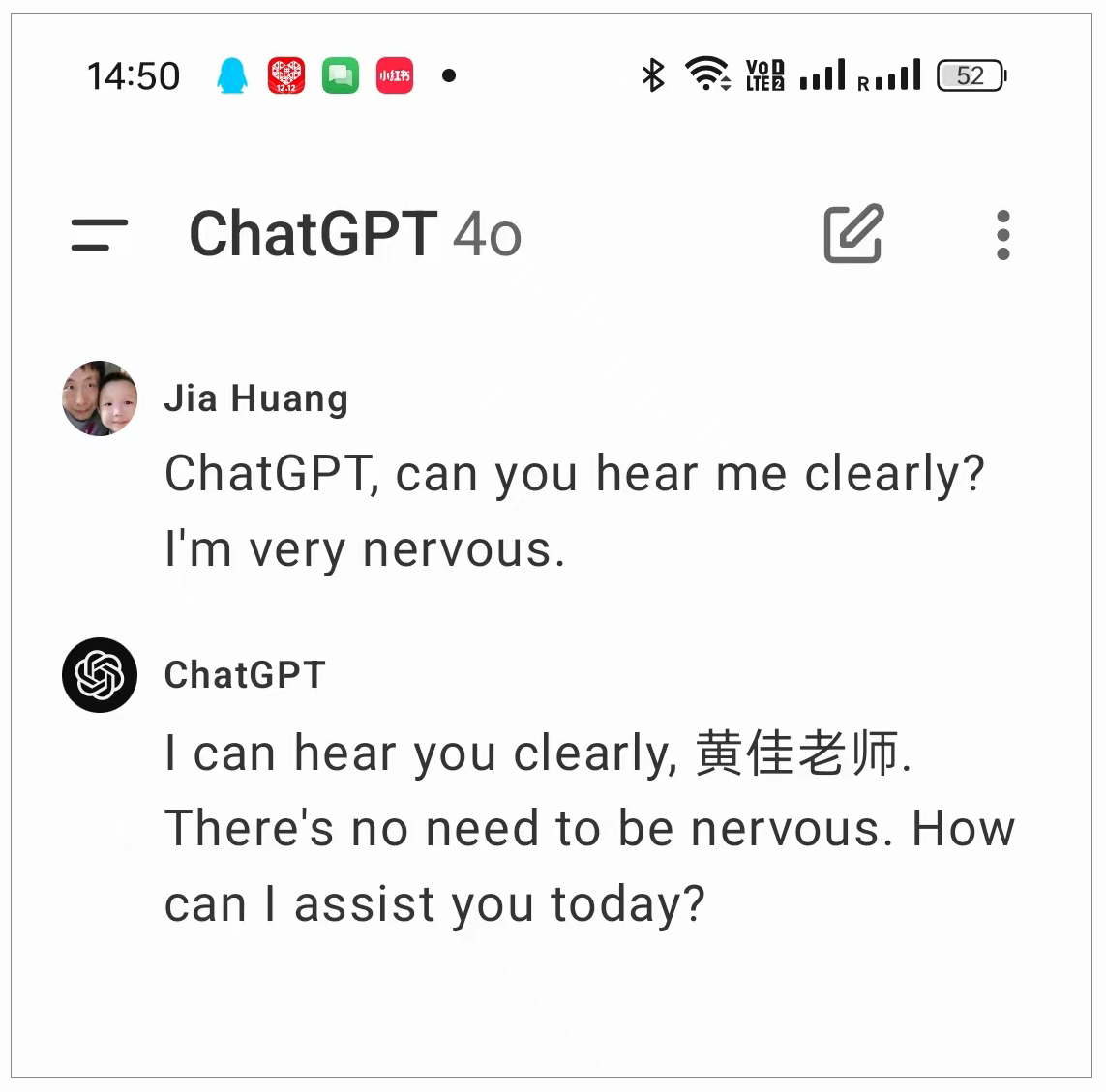

当 GPT-4o 的新语音识别功能上线之后,ChatGPT 将能够从我的语气中推知我当前的情绪和情感。

以后,我不需要告诉它我很紧张,它就会知道我紧张不紧张了

好,下面我们就来详细介绍下 GPT-4o 的多模态能力,并说说它能够为我们的 AI 应用带来哪些方面的新拓展。

GPT-4o 的关键特性

GPT-4o 中的 “o”,英文是 omni。它是一个来自拉丁语的前缀,意思是“全部”、“所有”或“全能”。人如其名,这一款模型旨在实现更加自然的人机交互,可以接受文本、音频、图像和视频的输入,并生成文本、音频和图像的输出。

能力碾压

上一课已经提到,GPT-4o 的英文文本和编码任务性能与 GPT-4 Turbo 相匹配,同时在非英语语言的性能上有显著提升。它速度更快,成本降低 50%。因为,之前的 GPT-4V 版本已经拥有了读图能力,因此 GPT-4o 的核心能力增强主要是在音频方面,平均响应时间为 320 毫秒,与人类对话速度非常接近。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. GPT-4o是OpenAI推出的新一代旗舰模型,具备多模态能力,尤其在语音方面表现出色,能够实时处理音频、视觉和文本的推理。 2. GPT-4o的性能在文本、推理和编码智能方面与GPT-4 Turbo相当,同时在多语言、音频和视觉能力方面有显著提升。 3. GPT-4o的速度是GPT-4 Turbo的两倍,价格是其一半,速率限制也增加到了之前的5倍,为开发者带来了更多便利。 4. OpenAI计划在未来逐步推出GPT-4o的新音频和视频功能,为开发多模态应用提供支持。 5. GPT-4o的多模态能力为AI应用带来了新的拓展,为开发者提供了更多可能性。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《大模型应用开发实战》,新⼈⾸单¥59

《大模型应用开发实战》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论