03|进阶应用:图生图技巧与创作社区初探

图生图可以做哪些事情?

通过重绘强度控制图生图效果

- 深入了解

- 翻译

- 解释

- 总结

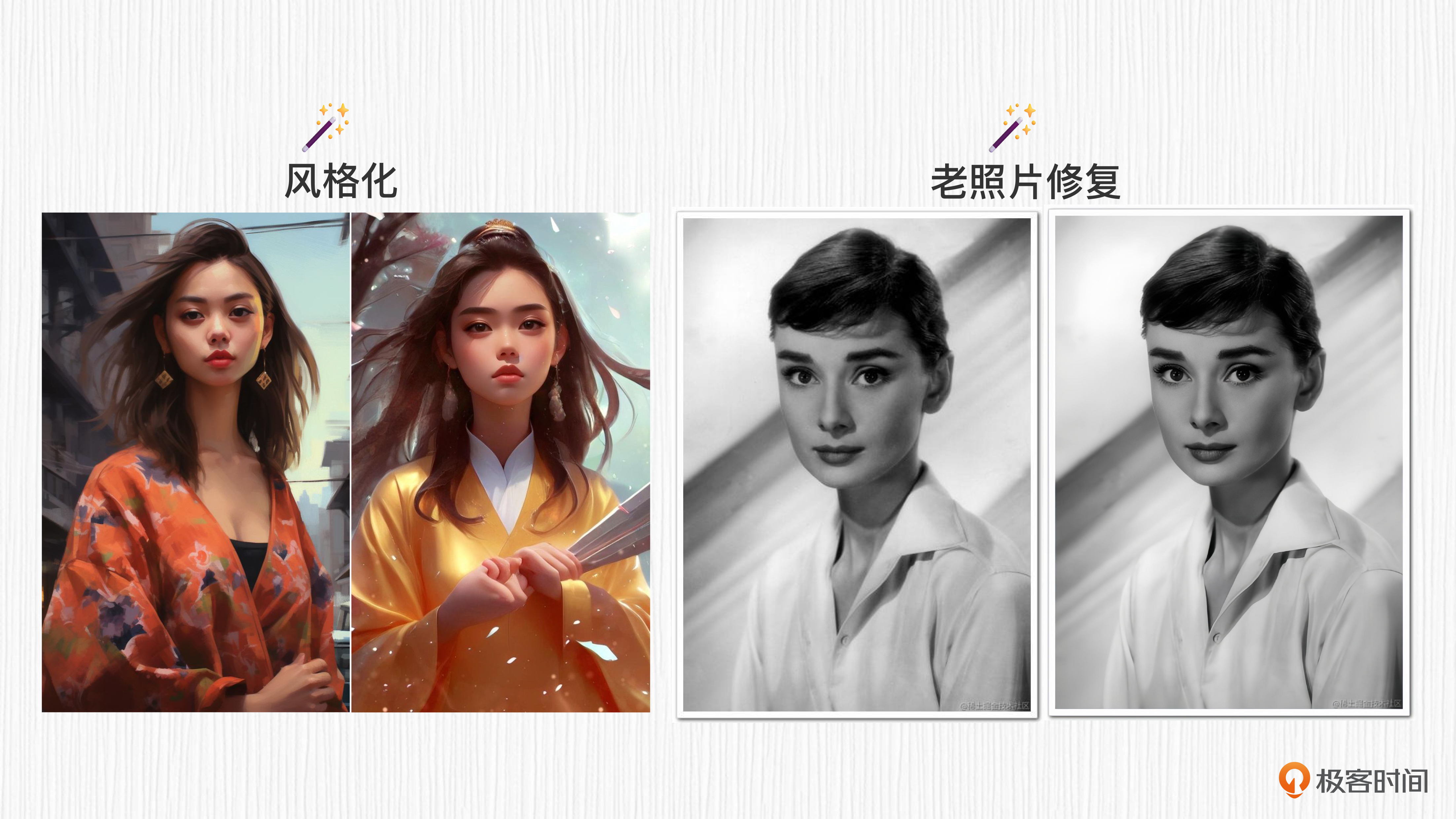

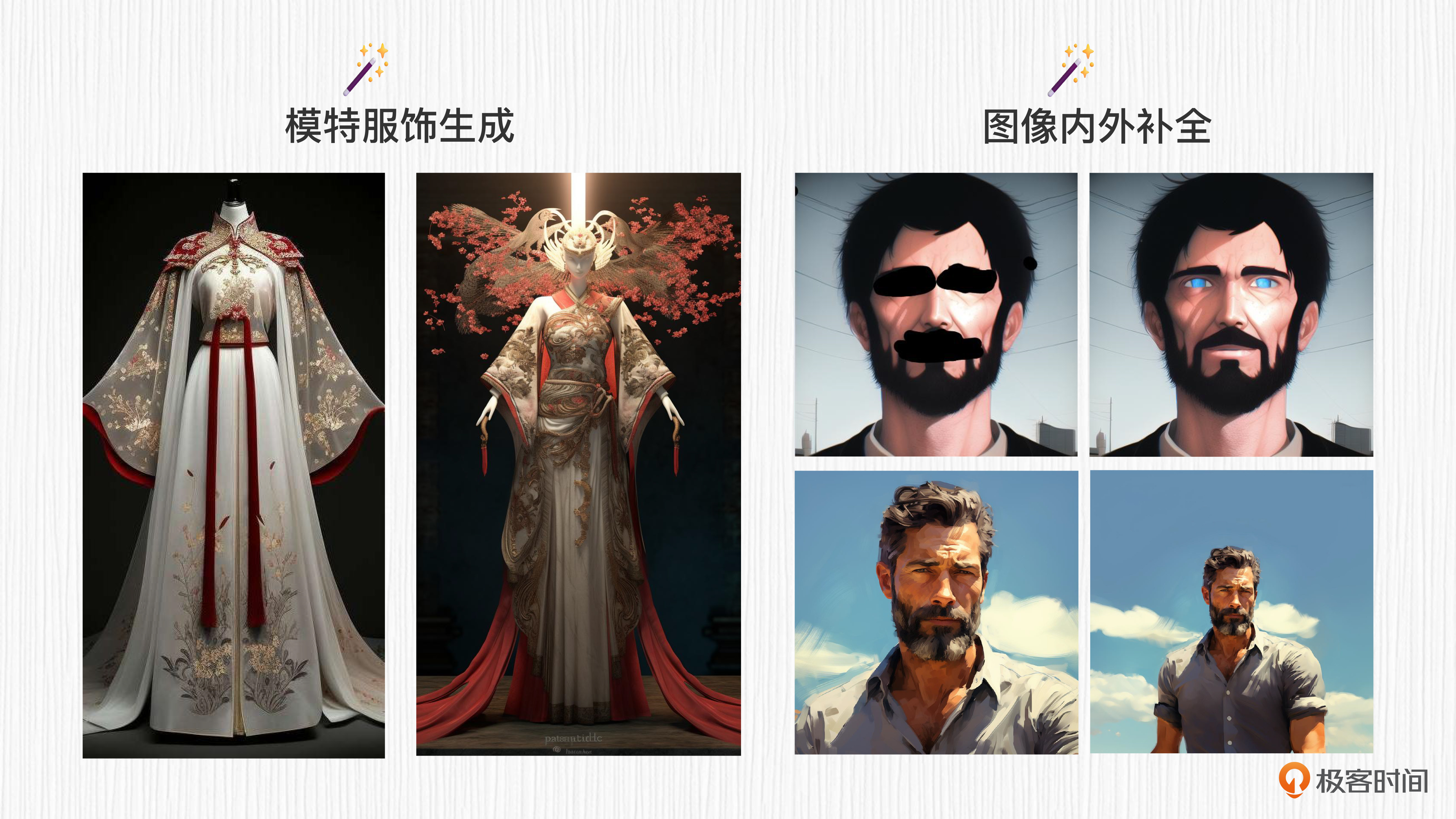

本文介绍了图生成图技巧与创作社区的初步探索。首先,文章介绍了图生成图的功能,包括风格化绘画、图像分辨率提升、衣物模特穿着等多种应用场景。然后,通过控制重绘强度来影响图生成图的绘画效果,重绘强度的调整可以使生成的图像更接近原始图像或者与prompt相关性更高。接着,文章介绍了两个开源社区Civitai和Hugging Face,它们提供了丰富多样的AI绘画模型资源,可以通过WebUI界面进行模型选择和参数设置,实现定制化的AI绘图。最后,文章强调了通过尝试不同的风格化模型、巧妙设计prompt以及合理调整参数的配合,可以显著提升AI绘画能力。整体而言,本文深入浅出地介绍了图生成图技巧和开源社区资源,为读者提供了进阶应用的技术指导和实践建议。

《AI 绘画核心技术与实战》,新⼈⾸单¥59

全部留言(13)

- 最新

- 精选

妹的银拆纳老师~催更啦~

妹的银拆纳老师~催更啦~作者回复: 好的~ 周一见!

2023-07-22归属地:上海2 五木老祖奇怪,本身sd就是一个预训练模型了,还需要加载其他模型和lora

五木老祖奇怪,本身sd就是一个预训练模型了,还需要加载其他模型和lora作者回复: 你好。其他模型,比如Textual Inversion和LoRA,都是在原有SD模型基础上,新衍生的绘画能力。比如我们基于SD1.5,希望能够进行微调得到善于生成“漩涡鸣人”的模型,又不希望调整SD1.5的原有参数影响其本身的生成能力,便会引入Textual Inversion或者LoRA。我们只需要几张到几十张“漩涡鸣人”的图片就能优化我们自己的模型,使用的时候加载新增的参数即可。有两个好处:一是参数少、数据少,普通人手中的资源也能训练的动;二是使用的时候即插即用,即得到了想要的新功能、又不影响模型的原有能力。 关于这类技巧,在实战篇我们会深入探讨其技术原理,敬请期待。希望能帮助到你。

2023-07-21归属地:北京2

zhihai.tu

zhihai.tu colab安装sd课程里面什么时候会讲啊?

colab安装sd课程里面什么时候会讲啊?作者回复: 你好,之前可以通过Colab使用WebUI,写这一讲的时候这个渠道被封禁了。在第二个实战篇中,会教大家如何在Colab中使用代码调用各种SD模型,敬请期待。

2023-07-21归属地:上海21 我就是我,烟火不一样的我老师在c站下载了模型之后,在webui怎么使用,怎么查看模型使用的基础模型,例如下载的是一个lora模型,怎么查看他使用的基础模型是啥,感觉使用了lora之后,画出来的画风和老师讲的不太一样

我就是我,烟火不一样的我老师在c站下载了模型之后,在webui怎么使用,怎么查看模型使用的基础模型,例如下载的是一个lora模型,怎么查看他使用的基础模型是啥,感觉使用了lora之后,画出来的画风和老师讲的不太一样编辑回复: 查看“Base Model”一项,就能知道这个模型的基础模型是什么了。

2024-01-14归属地:上海 xingliang失去了猫的特征:调整prompt,可以用mj通过图片推出描述词,作为图片描述词参考,看看是否有优化的地方。 要么与原始图像过于相似:可以调整描述词,追加灯光、视角、或者相似度参数。

xingliang失去了猫的特征:调整prompt,可以用mj通过图片推出描述词,作为图片描述词参考,看看是否有优化的地方。 要么与原始图像过于相似:可以调整描述词,追加灯光、视角、或者相似度参数。编辑回复: 赞~前两章的思考题答案也加餐放出了,欢迎去对照。

2023-08-12归属地:立陶宛 EnidYin这个问题有点问题,如何定义满意的效果,究竟要生成一张什么样的图片,可以用/blend 融合原图和一张卡通风格的图片

EnidYin这个问题有点问题,如何定义满意的效果,究竟要生成一张什么样的图片,可以用/blend 融合原图和一张卡通风格的图片作者回复: 你好。MJ的/blend功能可调试的空间较小(至少当前阶段如此),所以把不同风格、不同内容做融合,效果上有点像拆盲盒。可以考虑用LoRA来融合内容和风格,或者使用类似unCLIP的方法做图像插值融合。我们后面的课程中会详细探讨。希望能帮助到你。

2023-07-30归属地:北京 AI悦创思考题,能不能给出解决方案?一时间没有啥解决方法

AI悦创思考题,能不能给出解决方案?一时间没有啥解决方法作者回复: 你好,考虑到给一些新用户留出思考时间,我们原定计划是第二大章更新完成后,开始逐讲放出思考题的答案。也欢迎多写出你的思考,我们一起来探讨~

2023-07-24归属地:福建 AI悦创在 Midjourney 讲解部分前部分很清晰,但是后面部分不够清晰,比如:多张图片合成,具体怎么实现?不使用特殊命令,直接发送两个图片链接就可以?打马赛克可以理解,比如老师的账户名称马赛克打马赛克保护隐私,那么图片打马赛克是为什么呢?望解惑。

AI悦创在 Midjourney 讲解部分前部分很清晰,但是后面部分不够清晰,比如:多张图片合成,具体怎么实现?不使用特殊命令,直接发送两个图片链接就可以?打马赛克可以理解,比如老师的账户名称马赛克打马赛克保护隐私,那么图片打马赛克是为什么呢?望解惑。作者回复: 你好。使用Midjourney做多图融合时,输入/blend, 直接将最多5张图片拖进MJ的上传文件窗口即可,不需要使用prompt引导。针对第二个问题,图片链接打马赛克确实是非必需的,仅仅出于保护账号名的考虑。希望能帮助到你。

2023-07-24归属地:福建2 AI悦创操作的图片原图不知道能不能提供?现在的操作是截图然后使用图生图😂,希望完善配套资料。(部分涉及的案例,参数能完整就更好的复现了)当然本身课程质量很好了。

AI悦创操作的图片原图不知道能不能提供?现在的操作是截图然后使用图生图😂,希望完善配套资料。(部分涉及的案例,参数能完整就更好的复现了)当然本身课程质量很好了。作者回复: 你好。感谢你宝贵的意见反馈,到第二章我们会放出git代码仓,相关资料、图片会一并上传,帮助大家更好的实战。再次感谢,继续加油!

2023-07-24归属地:福建 peter请教老师几个问题: Q1:对于上传的图片为什么要加噪声? Q2:webUI可以用于手机端吗?比如安卓。 Q3:模型的训练时间长,但训练完成后,模型确定了,类似于有了一个确定的函数,所以运算就很快,是这样吗?

peter请教老师几个问题: Q1:对于上传的图片为什么要加噪声? Q2:webUI可以用于手机端吗?比如安卓。 Q3:模型的训练时间长,但训练完成后,模型确定了,类似于有了一个确定的函数,所以运算就很快,是这样吗?作者回复: 你好。针对Q1,因为图生图的本质是对原始图像的二次编辑,背后的原理是扩散模型(第6讲会详细介绍这个过程及原理)。向图像中添加噪声得到模糊的图像(加到我们用重绘强度指定的某一步),再利用文本信息引导模型去除噪声,便可以得到我们要编辑的效果。针对Q2,据我了解,当前WebUI还不能用在手机端,但未来随着算法加速和硬件优化,手机端AI绘画还是有可能的,这也是当前AI绘画的研究热点之一。针对Q3,你的理解基本是正确的。模型训练的过程是在训练UNet去噪结构(我们第6-8讲会详细讲),这个学习的过程需要海量的数据来驱动,需要很多GPU、很长时间;训练完成后,我们只需要使用训练好的UNet模型来帮忙计算,经过20~30 step便可以出图,因此速度就会快一些。

2023-07-22归属地:北京