22|实践:用Wasm实现AI Proxy

邢云阳

你好,我是邢云阳。

在前面的几节课中,我从 Wasm 的理论和实践两个角度,为你介绍了 Wasm。核心知识点实际上就是两块,一是 Wasm 的原理,二就是如何用 Wasm Go SDK 编写 Wasm 程序。对于原理,感兴趣的话你可以详细了解一下,而对于如何写 Wasm 程序,参考上节课的例子学会套路即可,后面用到哪个工具函数可以随时查文档。

在上节课的例子中,我们用到过 AI Proxy 这个插件,主要是为了能以网关 URL + OpenAI 协议的方式请求大模型。因为我们知道现在市面上无论是商业模型还是开源模型,基本大多都会遵循 OpenAI 标准,但每家厂商的 Base_Url 不一样,因此如果能有一个插件帮我们做好适配,让我们无论使用什么模型时,都可以以标准 OpenAI 格式请求,就会很方便。

因此本节课,我就用最近比较火的 DeepSeek 模型为例,带你写一下 AI Proxy 程序。

总体架构

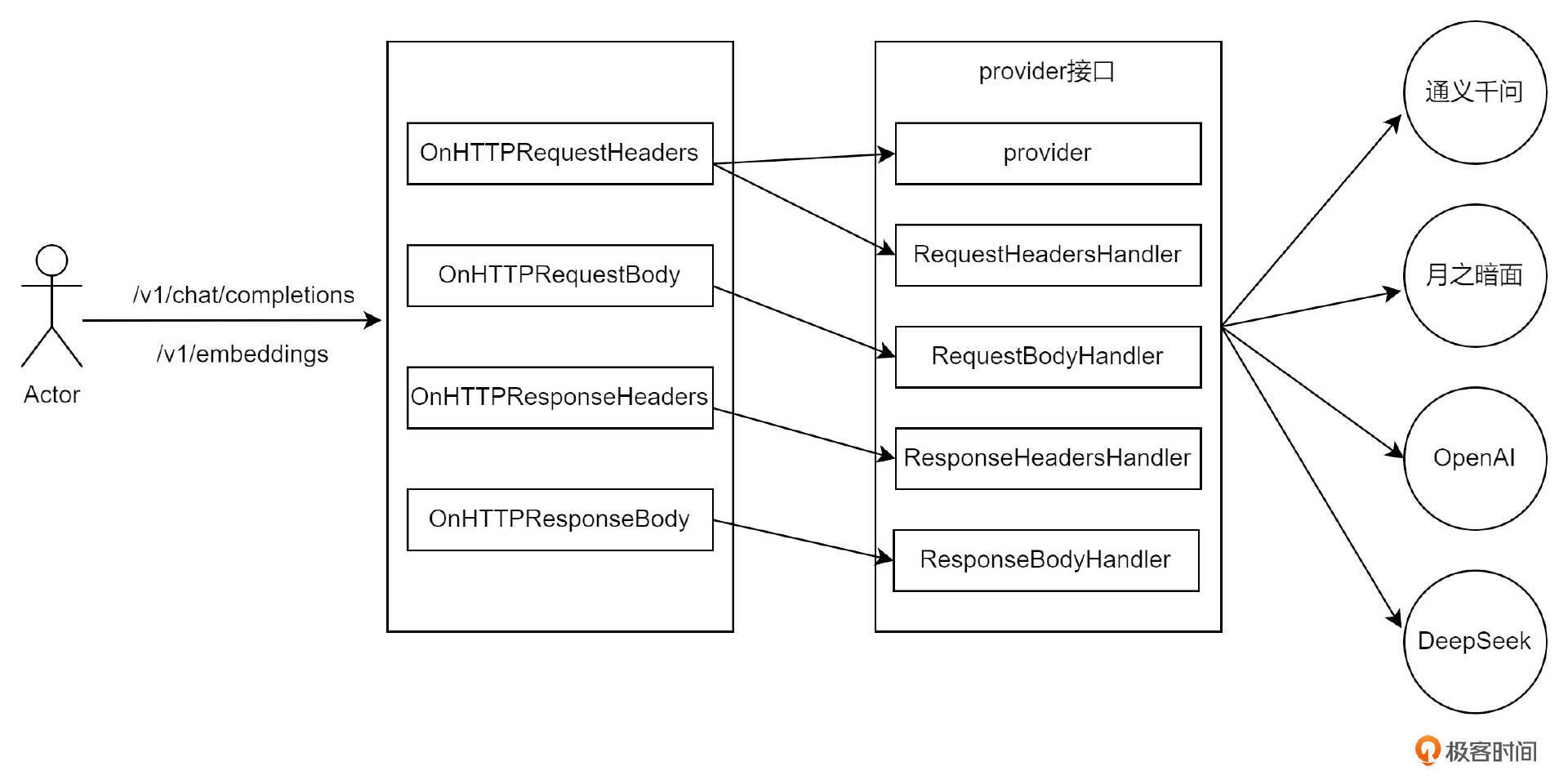

我们先来了解一下 AI Proxy 的总体架构原理。

从前面的课程中,我们已经了解到,Wasm 插件是如何在一次完整的 HTTP 请求中起作用的。简单来说,它主要在四个阶段介入:RequestHeader、RequestBody、ResponseHeader 和 ResponseBody。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. Wasm插件在HTTP请求的四个阶段中起作用,包括RequestHeader、RequestBody、ResponseHeader和ResponseBody。 2. AI Proxy插件通过provider接口定义了一组接口,通过多态的方式由各大模型厂商具体实现,完成OpenAI格式与各自协议之间的相互转换。 3. 参数配置使用了ParseOverrideConfigBy方法,确保了配置的灵活性和优先级,同时也避免了配置冲突或遗漏的问题。 4. 在onHttpRequestHeader阶段,主要工作内容是替换URL和Header信息,实现了对Path、Host等信息的替换,并添加了Authorization信息。 5. onHttpRequestBody阶段处理请求体的内容,支持配置上下文的功能,遍历上下文,添加到请求体的messages中去。 6. onHttpResponseHeaders阶段通常情况下无需额外处理,除非返回的响应头中包含了OpenAI不支持的字段,这时才需要对这些字段进行移除或调整。 7. 在onHttpResponseBody阶段,主要任务是将其他厂商模型的API响应格式转换为OpenAI格式,通过代码示例展示了如何将Claude的响应格式转换为OpenAI格式。 8. 介绍了AI Proxy插件的核心原理和新增DeepSeek模型代理的实践,帮助理解其工作机制和实现方式。 9. 提及AI Proxy支持failover特性,即可以为大模型配置多个APIToken,当其不可用时,会移出APIToken列表。 10. 讨论了AI Proxy在商业化中的应用,以及未来可能的演示内容。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《AI 重塑云原生应用开发实战》,新⼈⾸单¥59

《AI 重塑云原生应用开发实战》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论