11|变更场景(一):一条让Facebook蒸发百亿的指令

白园

想象一下,全球数十亿人突然失去了与亲朋好友的即时联系,企业沟通中断,社交媒体一片寂静。这不是科幻电影的情节,而是 2021 年 10 月 4 日,Facebook 及其旗下服务真实经历的一幕。

你好,我是白园。今天,我们将深入探讨这场技术界的“大地震”,它不仅让 Facebook 市值瞬间蒸发百亿美元,更引发了全球范围内的数字恐慌,而这一切都源于一条错误的指令。

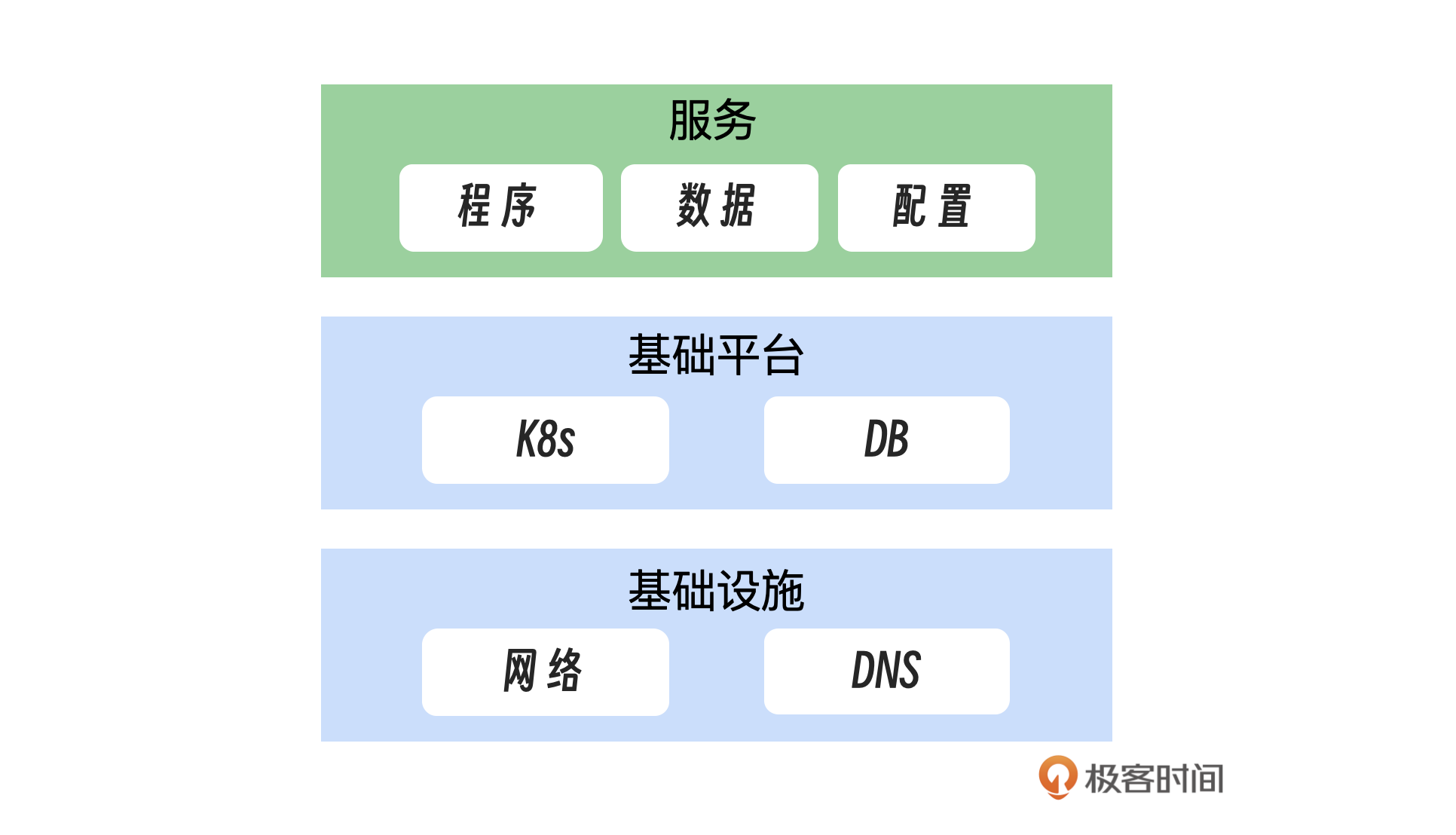

也是从这节课开始我们进入变更部分,从基础设施、基础平台到数据和配置变更,我们将通过三个案例,剖析背后的教训,学习如何在数字世界中航行,避免触礁。这节课我们就通过 Facebook 的这个故障案例来学习一下基础设施的故障:网络和 DNS。

案例回顾

2021 年 10 月 4 日北京时间 23:39,Facebook 服务全面中断,此次服务中断持续了约 7 个小时,是近年来罕见的长时间宕机事件。不仅 Facebook 本身,它旗下所有相关应用和服务全面崩溃,包括但不限于 Instagram、WhatsApp、Messenger 等主要社交平台,以及虚拟现实平台 Oculus、部分企业服务、内部工作系统。Facebook 的股价在当天下跌近 5%,创下了全年最大的单日跌幅,市值瞬间蒸发百亿美元。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. Facebook及其旗下服务经历了长达7个小时的全面中断,导致市值蒸发百亿美元,源于一条错误的指令。 2. Facebook的故障处理暴露了人为错误、影响控制不足和应急响应机制不完善等问题,需要从避免人为错误、控制故障影响和加速故障恢复三个关键层面进行深入分析。 3. 避免人为因素导致的重大故障需要改进检查机制、增强监控系统,实施严格的人工审批流程和利用平台的自动监测功能。 4. 严格遵守分级发布,从小范围开始发布,逐步扩展,确保系统稳定运行。 5. 控制故障影响需要确保网络故障不影响DNS,设计更健壮的网络架构,实施多路径探测机制和DNS撤销保护机制,以及内外网DNS独立部署和IP地址兜底机制。 6. 带外管理系统(Out-of-Band Management, OOBM)是一种独立的网络管理解决方案,能够提供对关键网络设备和服务器的远程管理能力,需要建立独立的管理网络、应急影响机制、预授权机制、紧急通道以及定期培训和演练。 7. Facebook成功应对了业务高峰期,表明在故障恢复过程中,除了关注服务的及时恢复外,还应特别注重系统在恢复后的稳定性和弹性。 8. 在执行任何系统变更或发布时,必须遵循严格的操作步骤和流程,确保有一套详尽的变更管理程序,以降低人为错误的风险,确保所有变更都经过了充分的测试和审查。 9. 基础设施的设计应包含足够的冗余,关键组件和系统应设计为可以承受部分故障而不影响整体服务的连续性。 10. 当业务的DNS故障时,应建立应急响应机制,确保快速响应和修复,同时考虑系统的稳定性和弹性。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《SRE 实践:服务可靠性案例课》,新⼈⾸单¥59

《SRE 实践:服务可靠性案例课》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论