05 | 从文本到用户画像有多远

该思维导图由 AI 生成,仅供参考

从文本开始

构建用户画像

一、结构化文本

- 深入了解

- 翻译

- 解释

- 总结

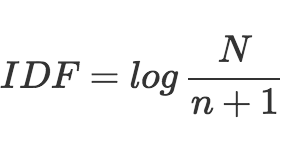

本文深入探讨了文本分析在构建用户画像中的关键作用和应用方法。通过分析用户和物品的文本数据,采用文本分析算法如TF-IDF、TextRank、内容分类、实体识别、聚类和词嵌入等,将非结构化的文本数据转化为结构化信息,丰富用户画像,更好地理解用户的兴趣和行为。特别地,文章详细介绍了Word2Vec在语义聚类方面的应用,以及卡方检验和信息增益等特征选择方法。这些算法和技术为构建更准确、全面的用户画像提供了重要的指导和支持。总的来说,本文为读者提供了深入了解用户画像构建过程中文本分析的关键概念和方法,为他们提供了宝贵的技术指导。文章内容丰富,涵盖了文本分析在用户画像构建中的关键作用和应用方法,对于从事推荐系统和数据挖掘工作的专业人士具有重要的参考价值。

《推荐系统三十六式》,新⼈⾸单¥59

全部留言(50)

- 最新

- 精选

张哲这一期信息量好大……

张哲这一期信息量好大……作者回复: 慢慢享用,嚼碎了再吞。

2018-03-1430 林彦谢谢刑无刀老师的分享。建议各种步骤和场景的工业化工具及其性能和便利,对我们读者提供了不小的价值。 1. 词嵌入里面提到学习到的包含更多语义信息的(新)词向量可以“用于聚类,会得到比使用词向量聚类更好的语义聚类效果”。这里的聚类是指文中之前提到的LDA等聚类模型来找出文章的主题吗? 2. “主题模型:从大量已有文本中学习主题向量,然后再预测新的文本在各个主题上的概率分布情况,也很实用,其实这也是一种聚类思想,主题向量也不是标签形式,也是用户画像的常用构成。”请问这里已有文中的主题向量中的主题词如果是通过LDA提取是不是需要有个停用词表排除那些所有文档中词频都很高的词?它不像TF-IDF会自动排除所有文档中词频高的词。 这种场景的聚类就是判别新的文本和哪些主题的文本比较相似(”距离“接近或主题”概率“较大),然后判别新的文本的主题? 3. ”向量中各个维度上的值大小代表了词包含各个语义的多少“ 有这句说明挺好的。我第一次阅读不太理解,后来查了一些文章,有一个解释我觉得比较直观,Word2Vec生成的向量值可以看成是N维语义空间(N个语义词)中的坐标值(每个坐标轴对应一个语义)。当2个词在同一个N维语义空间中的距离接近时,说明2个词的含义接近。

林彦谢谢刑无刀老师的分享。建议各种步骤和场景的工业化工具及其性能和便利,对我们读者提供了不小的价值。 1. 词嵌入里面提到学习到的包含更多语义信息的(新)词向量可以“用于聚类,会得到比使用词向量聚类更好的语义聚类效果”。这里的聚类是指文中之前提到的LDA等聚类模型来找出文章的主题吗? 2. “主题模型:从大量已有文本中学习主题向量,然后再预测新的文本在各个主题上的概率分布情况,也很实用,其实这也是一种聚类思想,主题向量也不是标签形式,也是用户画像的常用构成。”请问这里已有文中的主题向量中的主题词如果是通过LDA提取是不是需要有个停用词表排除那些所有文档中词频都很高的词?它不像TF-IDF会自动排除所有文档中词频高的词。 这种场景的聚类就是判别新的文本和哪些主题的文本比较相似(”距离“接近或主题”概率“较大),然后判别新的文本的主题? 3. ”向量中各个维度上的值大小代表了词包含各个语义的多少“ 有这句说明挺好的。我第一次阅读不太理解,后来查了一些文章,有一个解释我觉得比较直观,Word2Vec生成的向量值可以看成是N维语义空间(N个语义词)中的坐标值(每个坐标轴对应一个语义)。当2个词在同一个N维语义空间中的距离接近时,说明2个词的含义接近。作者回复: 你一定是个学霸,向你致敬。 1. 这里的聚类是指的传统数据挖掘中的聚类。基于距离或者密度等。如kmeans。 2. 停用词要去掉。lda在预测阶段也要迭代的,而不是计算相似度。 3. 你若理解了,就是晴天。

2018-03-1410- Drxan无刀老师,能否建立个微信群啊,大家可以对您每期的课程内容一起学习讨论

作者回复: 知识星球(原来叫小密圈)搜ResysChina。

2018-03-159  jt120针对embedding,我不太理解,之前理解就是一种映射关系,但文里为什么说结果是稠密的,这是怎么保证的

jt120针对embedding,我不太理解,之前理解就是一种映射关系,但文里为什么说结果是稠密的,这是怎么保证的作者回复: 用Word2vec跑出一个结果你就明白了,设定k维的话,你会得到一个k维向量,每个维度上都有值的。

2018-03-1426- 行行行老师,关于word2vec,有几个疑问 1 工业上如果通过word2vec得到文档的向量呢,是用累加一个文档中各个词的词向量得到的稠密向量表示吗 2 用于聚类,是用上面得到的文档向量来做吗 3 到底是如何通过计算词和词之间的相似度,扩充标签的呢

作者回复: 1.是 2.是 3.用你文本中出现的词,去查询通过word2vec计算得到的相似词,从而实现了“扩展”,原来只有两个词,现在增加了几个相似词,变成了4个词。

2018-03-2323  jt120上面提到的都是主流的推荐系统方法,例如电影,图书,新闻这些经典场景。 但对于特殊商品,例如房子,明显和上面不同,低频,高价,并且房子的特征基本都是分类特征,针对这种场景,如何选择特征,如何推荐了?

jt120上面提到的都是主流的推荐系统方法,例如电影,图书,新闻这些经典场景。 但对于特殊商品,例如房子,明显和上面不同,低频,高价,并且房子的特征基本都是分类特征,针对这种场景,如何选择特征,如何推荐了?作者回复: 这种场景下,用户也更有耐心一些,可以多向用户询问他的诉求,更像一个辅助决策系统,而不是一个纯粹的推荐系统。

2018-03-143- wjj老师,TF—IDF中的Top K 排序,实际工作中超参数K值一般取多少?

作者回复: 看情况。

2019-05-311 - Kendal邢老师你好,我是初学者,第二部分把物品的结构化信息传递给用户这里,您把他看成是一个特征选取的问题。这里没太看懂,还望能够详细解释下。 假设用户A和我们给他展现的100个物品有了2类操作(消费10,没消费90)。我的理解是这边每个被消费的物品(10个)都有自己的特征向量(假设n维),我们的任务是找到这n维里面到底哪m维是用户真正关心的。这个理解对吗?然后如何选取到这m维,并把它们融合到用户自己原来的向量中又是如何具体实现的? 谢谢指点!

作者回复: 文中有详细介绍。后续图书中有例子。

2019-02-111  预见我来补充林彦同学的第三点,”向量中各个维度上的值大小代表了词包含各个语义的多少“ 。第一遍看到这句话的时候我没有看懂,查阅资料后才明白。比如使用word embedding,一个单词“北京”,用5维向量“首都,中国,大城市,南方,没雾霾”来表示的话,他的向量形式就是[1, 1, 1, 0, 0],各个维度的值的大小代表了词包含各个语义的多少。老师要是讲的再细致一点,给出示例就更好了

预见我来补充林彦同学的第三点,”向量中各个维度上的值大小代表了词包含各个语义的多少“ 。第一遍看到这句话的时候我没有看懂,查阅资料后才明白。比如使用word embedding,一个单词“北京”,用5维向量“首都,中国,大城市,南方,没雾霾”来表示的话,他的向量形式就是[1, 1, 1, 0, 0],各个维度的值的大小代表了词包含各个语义的多少。老师要是讲的再细致一点,给出示例就更好了作者回复: 谢谢你的建议,采纳到图书中。

2018-12-011 尹士Fasttext准确率跟cnn比,有差距,我的实验结果,不知邢老师参数如何设置的,可以工程中使用fasttext

尹士Fasttext准确率跟cnn比,有差距,我的实验结果,不知邢老师参数如何设置的,可以工程中使用fasttext作者回复: 我似乎觉得工程中fasttext用得多些,尤其中小企业。

2018-04-011