25|模型工程(一):如何让你的训练数据无中生有?

模型发展

- 深入了解

- 翻译

- 解释

- 总结

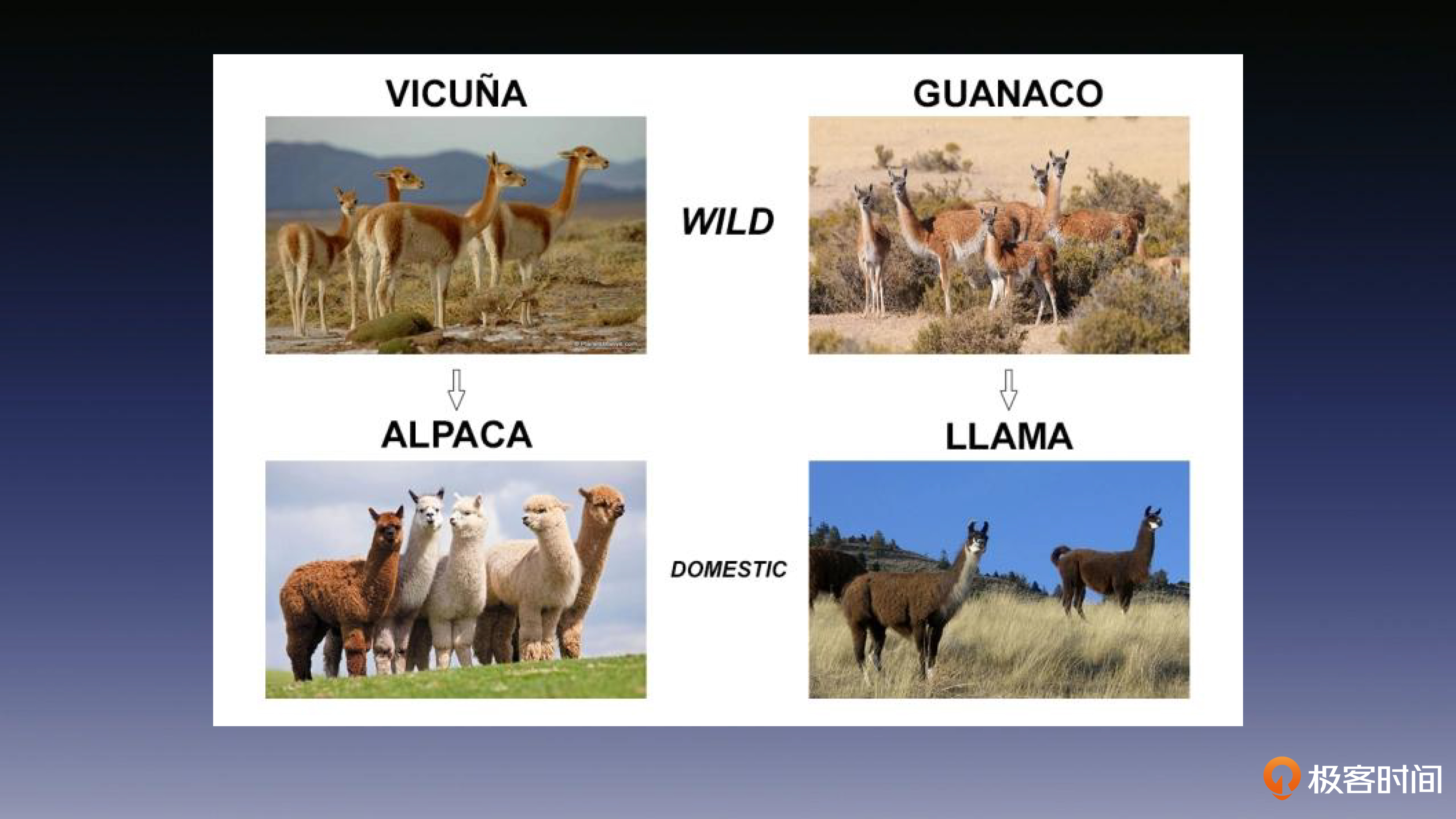

本文介绍了模型工程中的一个重要问题:训练数据的获取。作者首先介绍了大型语言模型的发展,指出了获取训练数据和足够计算资源是大型模型训练中的关键问题。然后,文章详细介绍了一种名为Self-Instruct的数据增强方法,旨在减少对人工标注的依赖。该方法通过从初始示例样本开始,以大型预训练语言模型的自我引导方式生成新的指令和示例,从而获取训练数据。具体包括准备种子数据、生成提示指令、判断任务类型、生成示例样本和数据过滤等步骤。最后,文章指出了这类数据增强方法的意义,以及Alpaca应用的普惠性。通过本文,读者可以了解到模型工程中训练数据获取的挑战和解决方法,以及相关技术的发展趋势。 Alpaca是LLaMA-7B的微调版本,它采用了Self-Instruct方式生成的数据进行了指令微调。具体来说,它利用了OpenAI的text-davinc-003模型,用175对人工标注的种子数据,构建了52K条指令微调数据,使用OpenAI API的成本仅不到500美元。Alpaca对Self-Instruct提供的方案进行了修改,使其相对简化。它使用的提示语大致是后面这样。通过这种方法得到的模型,可以在指定任务上达到SOTA的效果。这种成本对于小型的研究团队来说不成问题,这种用很少成本完成特定领域的大语言模型微调的方式,这给相关方向的研究人员打开了思路。 在此之后,领域大型语言模型如雨后春笋般涌现,比如Guanaco模型在Alpaca的基础上增加了多语言语料和指令任务。"小羊驼"模型Vicuna-13B则是基于LLaMA,并使用从ShareGPT采集的对话数据对进行了指令微调,在特定的实验设置下,仅使用了300美元训练成本,就达到了与ChatGPT相媲美的性能水平。 通过本文,读者可以了解到模型工程中训练数据获取的挑战和解决方法,以及相关技术的发展趋势。同时,Alpaca的应用展示了如何以较低成本完成大型语言模型的微调,为小型研究团队提供了新的思路和机会。

《AI 大模型系统实战》,新⼈⾸单¥59

全部留言(2)

- 最新

- 精选

顾琪瑶上限: * 就目前使用GPT来生成样本数据集的话, 那么上限应该是GPT模型本身的知识范围, 在多次对特定领域进行样本数据生成时, 次数越多, 重复的样本也会相应增多

顾琪瑶上限: * 就目前使用GPT来生成样本数据集的话, 那么上限应该是GPT模型本身的知识范围, 在多次对特定领域进行样本数据生成时, 次数越多, 重复的样本也会相应增多作者回复: 你好,顾琪瑶。回答得很好,Alpaca 或者说 self-instruct 的各种变种,本质上是在做模型对齐,如果你使用 GPT-4 来生成增强语料,则是在对齐目标任务领域上,你的模型与 GPT-4 之间的能力,所以上限就是你所选择对齐的那个模型。

2023-10-16归属地:上海4 l_j_dota_1111如果相对垂直领域进行模型微调,但是现在的垂直领域的数据都是文本(就是一个一个word文档),如何生成可以使用的样本数据呢(任务就是正常的对话)2024-01-09归属地:天津1

l_j_dota_1111如果相对垂直领域进行模型微调,但是现在的垂直领域的数据都是文本(就是一个一个word文档),如何生成可以使用的样本数据呢(任务就是正常的对话)2024-01-09归属地:天津1