“足够大的神经网络当然无所不能!”

[美] 斯蒂芬 • 沃尔弗拉姆(Stephen Wolfram)

该思维导图由 AI 生成,仅供参考

ChatGPT 的能力令人印象深刻,以至于人们可能会想象,如果能够在此基础上继续努力,训练出越来越大的神经网络,那么它们最终将“无所不能”。对于那些容易被人类思维理解的事物,这确实很可能是成立的。但我们从科学在过去几百年间的发展中得出的教训是,有些事物虽然可以通过形式化的过程来弄清楚,但并不容易立即为人类思维所理解。

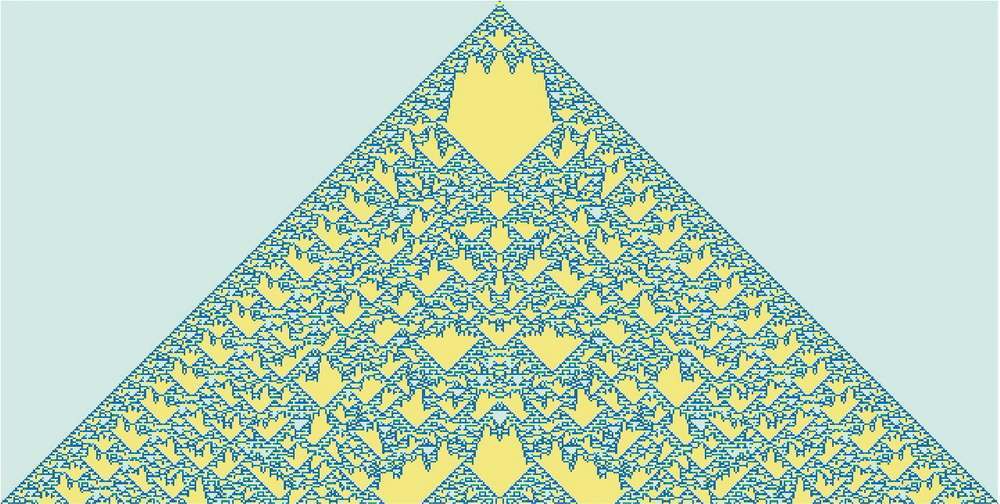

非平凡的数学就是一个很好的例子,但实际而言,一般的例子是计算。最终的问题是计算不可约性。有些计算虽然可能需要很多步才能完成,但实际上可以“简化”为相当直接的东西。但计算不可约性的发现意味着这并不总是有效的。对于一些过程(可能像下面的例子一样),无论如何都必须回溯每个计算步骤才能弄清楚发生了什么。

我们通常用大脑做的那类事情,大概是为了避免计算不可约性而特意选择的。在大脑中进行数学运算需要特殊的努力。而且在实践中,仅凭大脑几乎无法“想透”任何非平凡程序的操作步骤。

当然,我们可以用计算机来做这些。有了计算机,就可以轻松地完成耗时很长、计算不可约的任务。关键是,完成这些任务一般来说没有捷径可走。

是的,我们可以记住在某个特定计算系统中发生的事情的许多具体例子,也许甚至可以看到一些(计算可约的)模式,使我们能够做一些泛化。但关键是,计算不可约性意味着我们永远不能保证意外不会发生—只有通过明确的计算,才能知道在任何特定的情况下会实际发生什么。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

“大的神经网络当然无所不能!”这篇文章探讨了神经网络的能力和局限性。作者指出,尽管像ChatGPT这样的大型神经网络在某些方面表现出色,但在处理非平凡的数学和计算问题时,仍存在计算不可约性的挑战。文章强调了学习能力和计算不可约性之间的矛盾,以及神经网络在处理复杂计算任务时的局限性。作者还提到了工程学和现代技术世界对数学计算的依赖,以及神经网络在模拟自然界中不可约计算方面的局限性。总的来说,文章强调了神经网络的能力和可训练性之间的权衡,以及在处理复杂计算问题时的挑战。 这篇文章深入探讨了神经网络的技术特点,强调了其在处理复杂计算任务时的局限性,对读者有助于了解神经网络的能力和局限性,以及在处理复杂计算问题时的挑战。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《这就是 ChatGPT》

《这就是 ChatGPT》

立即购买

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论