概率从何而来

[美] 斯蒂芬 • 沃尔弗拉姆(Stephen Wolfram)

该思维导图由 AI 生成,仅供参考

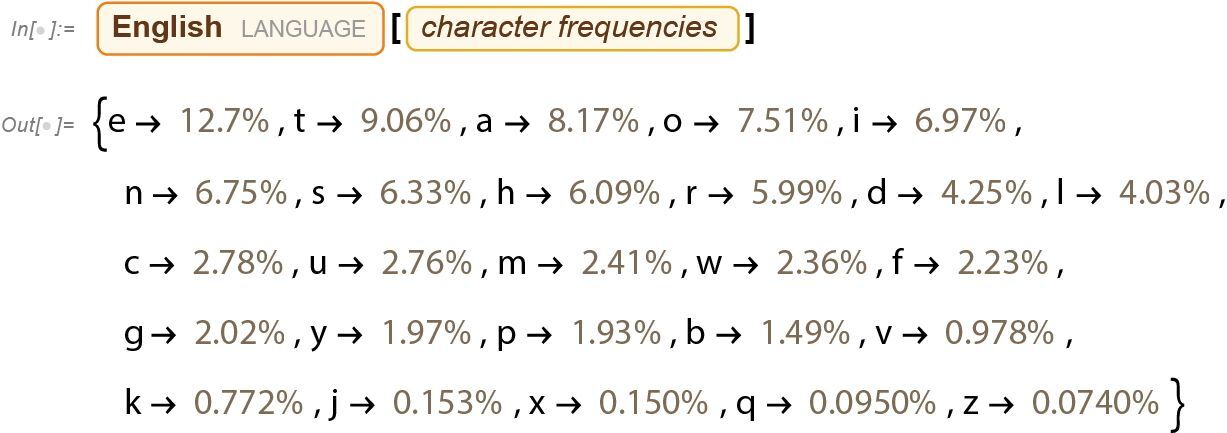

ChatGPT 总是根据概率选择下一个词,但是这些概率是从何而来的呢?让我们从一个更简单的问题开始:考虑逐字母(而非逐词)地生成英文文本。怎样才能计算出每个字母应当出现的概率呢?

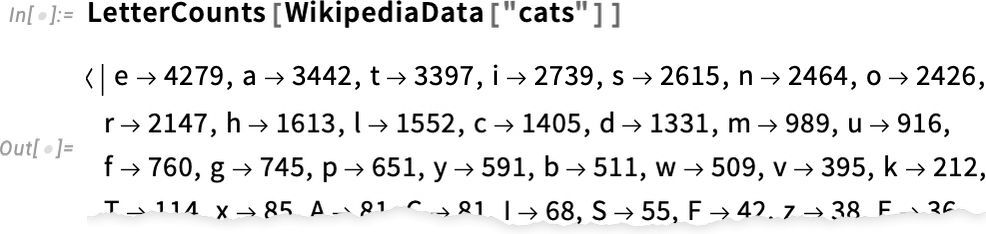

我们可以做一件很小的事,拿一段英文文本样本,然后计算其中不同字母的出现次数。例如,下面的例子统计了维基百科上“cats”(猫)的条目中各个字母的出现次数。

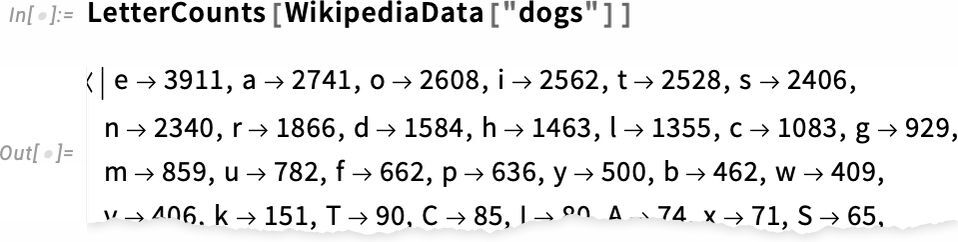

对“dogs”(狗)的条目也做同样的统计。

结果有些相似,但并不完全一样。(毫无疑问,在“dogs”的条目中,字母 o 更常见,毕竟 dog 一词本身就含有 o。)不过,如果我们采集足够大的英文文本样本,最终就可以得到相当一致的结果。

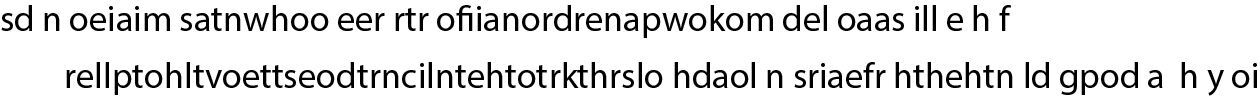

这是在只根据这些概率生成字母序列时得到的样本。

我们可以通过添加空格将其分解成“词”,就像这些“词”也是具有一定概率的字母一样。

还可以通过强制要求“词长”的分布与英文中相符来更好地造“词”。

虽然并没有碰巧得到任何“实际的词”,但结果看起来稍好一些了。不过,要进一步完善,我们需要做的不仅仅是随机地挑选每个字母。举例来说,我们知道,如果句子中有一个字母 q,那么紧随其后的下一个字母几乎一定是 u。

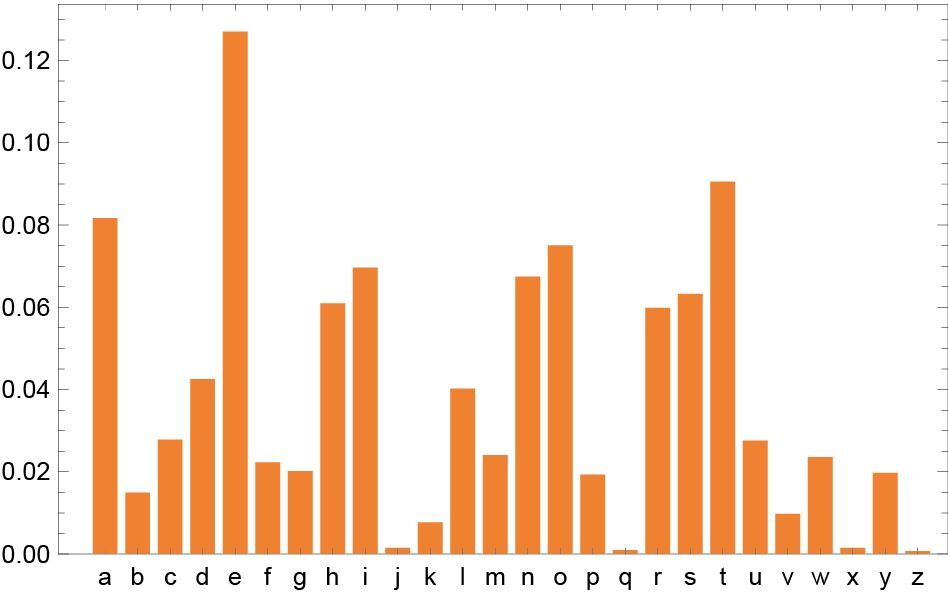

以下是每个字母单独出现的概率图。

下图则显示了典型英文文本中字母对[二元(2-gram 或 bigram)字母]的概率。可能出现的第一个字母横向显示,第二个字母纵向显示。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

文章总结:概率在自然语言生成中扮演着重要角色。本文以ChatGPT为例,探讨了概率是如何应用于逐字母和逐词生成英文文本的过程中。通过统计不同字母的出现次数,以及考虑字母对或更长的n元字母的概率,可以生成更加“真实”的文本。然而,由于英文文本的复杂性,要准确估计所有可能的n元词的概率是一项艰巨的任务。因此,建立一个能够估计序列出现概率的大语言模型是解决这一问题的最佳思路。ChatGPT正是基于这一思路构建的,能够很好地估计文本序列的概率,从而生成更加符合“正确的整体文章概率”的文本。文章通过简洁清晰的例子和图片,生动地展示了概率在自然语言生成中的应用,为读者呈现了一幅技术特点鲜明的概览。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《这就是 ChatGPT》

《这就是 ChatGPT》

立即购买

登录 后留言

全部留言(1)

- 最新

- 精选

3.141516

3.141516 这里将隐马尔可夫模型描述的通俗易懂2024-01-15归属地:广东

这里将隐马尔可夫模型描述的通俗易懂2024-01-15归属地:广东

收起评论