06|赛博记忆:为每个人生成独有的AI记忆

王吕

本门课程为精品小课,不标配音频

你好,我是王吕。

在之前的课程中,我们讨论了极客时间小助手这类聊天机器人的实现,用户可以和 LLM 对话互动,通过一问一答,获取想要的知识。不过在真实使用场景中,我们的对话都是连续的,我们也期望 LLM 能知道我们刚才说了什么。今天这节课,我就来帮你实现 AI 多轮对话的功能,并且讨论一下如何实现给每个用户增加记忆的功能。

什么是 LLM 的记忆?

记忆简单来说就是存储,把相关数据存储下来供之后使用,这就是 LLM 的记忆。可是,随着时间的增加,记忆数据越来越大,远远超过 LLM 对话的 token 长度了,这该怎么办?

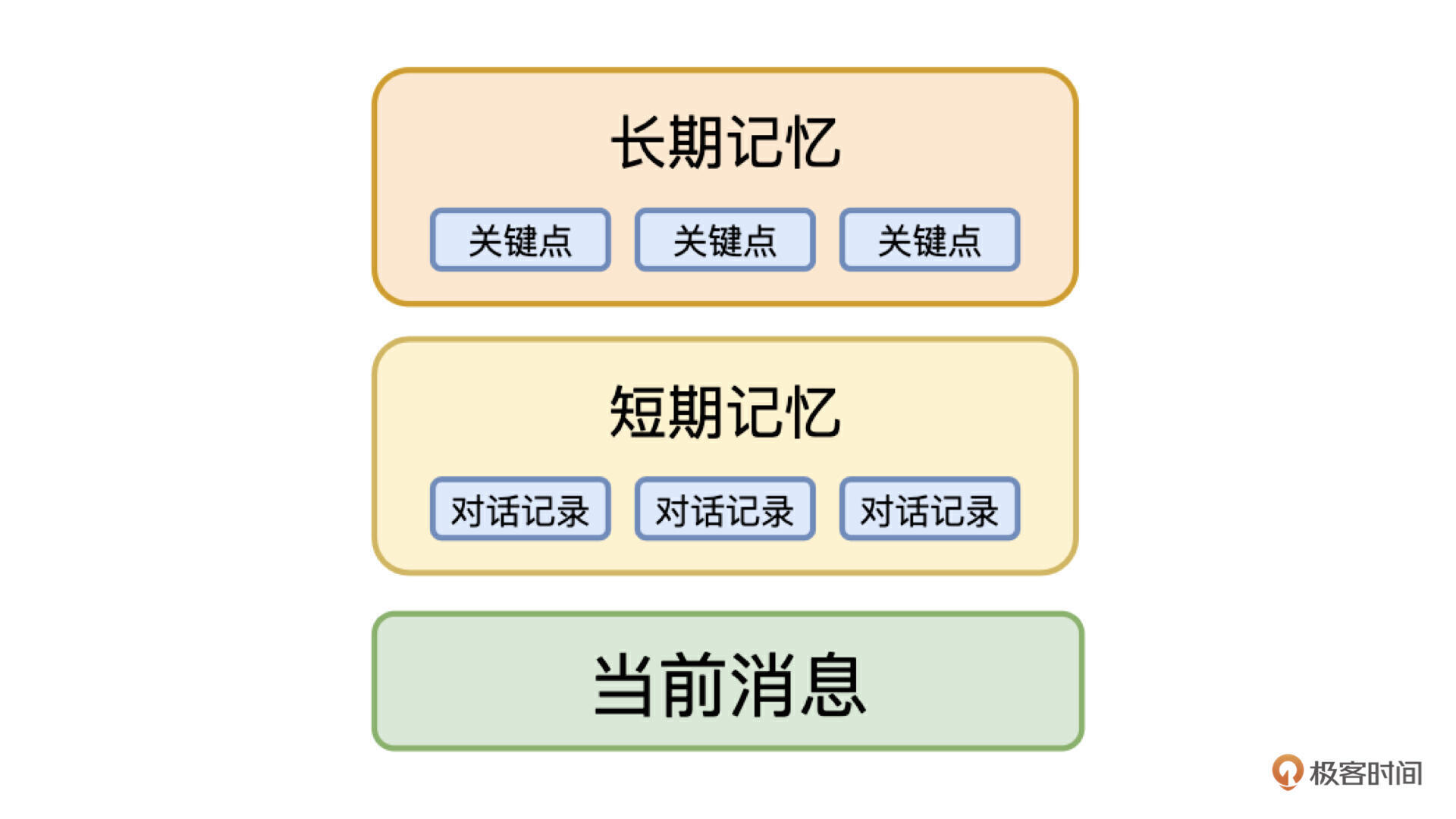

我们首先想到的就是裁剪,只保留最近的数据,但是这样就会丢失很多的重要信息。最好的解决办法是把记忆抽象为两种类型:短期记忆和长期记忆,短期记忆是精确的数据,长期记忆是模糊的数据,只记录关键信息。

在这个方法的指导下,针对对话场景,我们可以设计下边这个结构体,作为传递给 LLM 的消息。

短期记忆很简单,我们直接把对话记录的最近 N 条作为短期记忆,也就是对话上下文,这保证了用户在对话过程中聊天内容的连续性。长期记忆是把之前的历史消息进行总结提炼,只记录关键信息,类似于背景信息,再加上用户最新的对话,这三部分就组成了一个拥有记忆的 LLM,可以实现多轮对话的能力。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. LLM的记忆分为短期记忆和长期记忆,短期记忆保留对话上下文,长期记忆则提炼关键信息,使得AI能够实现多轮对话的能力。 2. Mem0是一个记忆框架,为大语言模型(LLM)设计,具有实体关系、最新性、相关性和衰减、上下文连续性、自适应学习和动态更新等优势。 3. Mem0应用广泛,可用于各种AI产品的后端,基于Mem0实现多轮对话的流程包括使用传统数据库保存历史消息,使用Mem0实现长期记忆功能,以及实现对话逻辑。 4. 实现多轮对话的主要逻辑包括获取历史消息、重写问题、获取长期记忆、组装prompt、调用LLM进行回答等步骤。 5. 记忆功能让 LLM 能够针对每个用户提供个性化的服务,在用户体验上可以提升一个档次,同时也给 LLM 扩展了很多能力,如上下文理解能力、个性化交互能力、长期任务处理能力、知识积累和更新、情感连接能力以及深度分析能力。 6. 记忆功能对 LLM 来说是如虎添翼,大大丰富了 LLM 的应用场景。 7. 记忆功能本质上是给每个用户分配了一个专有的助理,一个知道用户喜好和习惯的助理,可以为每个用户提供更加贴心的服务。 8. 记忆功能对 LLM 的应用场景大大丰富了,可以结合业务需求探索适合自己的场景。 9. 记忆功能为每个用户提供个性化服务,提升用户体验,同时也给 LLM 扩展了多种能力,丰富了应用场景。 10. 记忆功能的应用场景包括上下文理解能力、个性化交互能力、长期任务处理能力、知识积累和更新、情感连接能力以及深度分析能力。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《LLM & RAG 快速应用小册》

《LLM & RAG 快速应用小册》

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论