Encoder libx264 [libx264 H.264 / AVC / MPEG-4 AVC / MPEG-4 part 10]:

General capabilities: dr1 delay threads

Threading capabilities: other

Supported pixel formats: yuv420p yuvj420p yuv422p yuvj422p yuv444p yuvj444p nv12 nv16 nv21 yuv420p10le yuv422p10le yuv444p10le nv20le gray gray10le

libx264 AVOptions:

-preset <string> E..V....... Set the encoding preset (cf. x264

-tune <string> E..V....... Tune the encoding params (cf. x264

-profile <string> E..V....... Set profile restrictions (cf. x264

-fastfirstpass <boolean> E..V....... Use fast settings when encoding first pass (default true)

-level <string> E..V....... Specify level (as defined by Annex A)

-passlogfile <string> E..V....... Filename for 2 pass stats

-wpredp <string> E..V....... Weighted prediction for P-frames

-a53cc <boolean> E..V....... Use A53 Closed Captions (if available) (default true)

-x264opts <string> E..V....... x264 options

-crf <float> E..V....... Select the quality for constant quality mode (from -1 to FLT_MAX) (default -1)

-crf_max <float> E..V....... In CRF mode, prevents VBV from lowering quality beyond this point. (from -1 to FLT_MAX) (default -1)

-qp <int> E..V....... Constant quantization parameter rate control method (from -1 to INT_MAX) (default -1)

-aq-mode <int> E..V....... AQ method (from -1 to INT_MAX) (default -1)

none 0 E..V.......

variance 1 E..V....... Variance AQ (complexity mask)

autovariance 2 E..V....... Auto-variance AQ

autovariance-biased 3 E..V....... Auto-variance AQ with bias to dark scenes

-aq-strength <float> E..V....... AQ strength. Reduces blocking and blurring in flat and textured areas. (from -1 to FLT_MAX) (default -1)

-psy <boolean> E..V....... Use psychovisual optimizations. (default auto)

-psy-rd <string> E..V....... Strength of psychovisual optimization, in <psy-rd>:<psy-trellis> format.

-rc-lookahead <int> E..V....... Number of frames to look ahead for frametype and ratecontrol (from -1 to INT_MAX) (default -1)

-weightb <boolean> E..V....... Weighted prediction for B-frames. (default auto)

-weightp <int> E..V....... Weighted prediction analysis method. (from -1 to INT_MAX) (default -1)

none 0 E..V.......

simple 1 E..V.......

smart 2 E..V.......

-ssim <boolean> E..V....... Calculate and print SSIM stats. (default auto)

-intra-refresh <boolean> E..V....... Use Periodic Intra Refresh instead of IDR frames. (default auto)

-bluray-compat <boolean> E..V....... Bluray compatibility workarounds. (default auto)

-b-bias <int> E..V....... Influences how often B-frames are used (from INT_MIN to INT_MAX) (default INT_MIN)

-b-pyramid <int> E..V....... Keep some B-frames as references. (from -1 to INT_MAX) (default -1)

none 0 E..V.......

strict 1 E..V....... Strictly hierarchical pyramid

normal 2 E..V....... Non-strict (not Blu-ray compatible)

-mixed-refs <boolean> E..V....... One reference per partition, as opposed to one reference per macroblock (default auto)

-8x8dct <boolean> E..V....... High profile 8x8 transform. (default auto)

-fast-pskip <boolean> E..V....... (default auto)

-aud <boolean> E..V....... Use access unit delimiters. (default auto)

-mbtree <boolean> E..V....... Use macroblock tree ratecontrol. (default auto)

-deblock <string> E..V....... Loop filter parameters, in <alpha:beta> form.

-cplxblur <float> E..V....... Reduce fluctuations in QP (before curve compression) (from -1 to FLT_MAX) (default -1)

-partitions <string> E..V....... A comma-separated list of partitions to consider. Possible values: p8x8, p4x4, b8x8, i8x8, i4x4, none, all

-direct-pred <int> E..V....... Direct MV prediction mode (from -1 to INT_MAX) (default -1)

none 0 E..V.......

spatial 1 E..V.......

temporal 2 E..V.......

auto 3 E..V.......

-slice-max-size <int> E..V....... Limit the size of each slice in bytes (from -1 to INT_MAX) (default -1)

-stats <string> E..V....... Filename for 2 pass stats

-nal-hrd <int> E..V....... Signal HRD information (requires vbv-bufsize; cbr not allowed in .mp4) (from -1 to INT_MAX) (default -1)

none 0 E..V.......

vbr 1 E..V.......

cbr 2 E..V.......

-avcintra-class <int> E..V....... AVC-Intra class 50/100/200/300/480 (from -1 to 480) (default -1)

-me_method <int> E..V....... Set motion estimation method (from -1 to 4) (default -1)

dia 0 E..V.......

hex 1 E..V.......

umh 2 E..V.......

esa 3 E..V.......

tesa 4 E..V.......

-motion-est <int> E..V....... Set motion estimation method (from -1 to 4) (default -1)

dia 0 E..V.......

hex 1 E..V.......

umh 2 E..V.......

esa 3 E..V.......

tesa 4 E..V.......

-forced-idr <boolean> E..V....... If forcing keyframes, force them as IDR frames. (default false)

-coder <int> E..V....... Coder type (from -1 to 1) (default default)

default -1 E..V.......

cavlc 0 E..V.......

cabac 1 E..V.......

vlc 0 E..V.......

ac 1 E..V.......

-b_strategy <int> E..V....... Strategy to choose between I/P/B-frames (from -1 to 2) (default -1)

-chromaoffset <int> E..V....... QP difference between chroma and luma (from INT_MIN to INT_MAX) (default 0)

-sc_threshold <int> E..V....... Scene change threshold (from INT_MIN to INT_MAX) (default -1)

-noise_reduction <int> E..V....... Noise reduction (from INT_MIN to INT_MAX) (default -1)

-udu_sei <boolean> E..V....... Use user data unregistered SEI if available (default false)

-x264-params <dictionary> E..V....... Override the x264 configuration using a :-separated list of key=value parameters

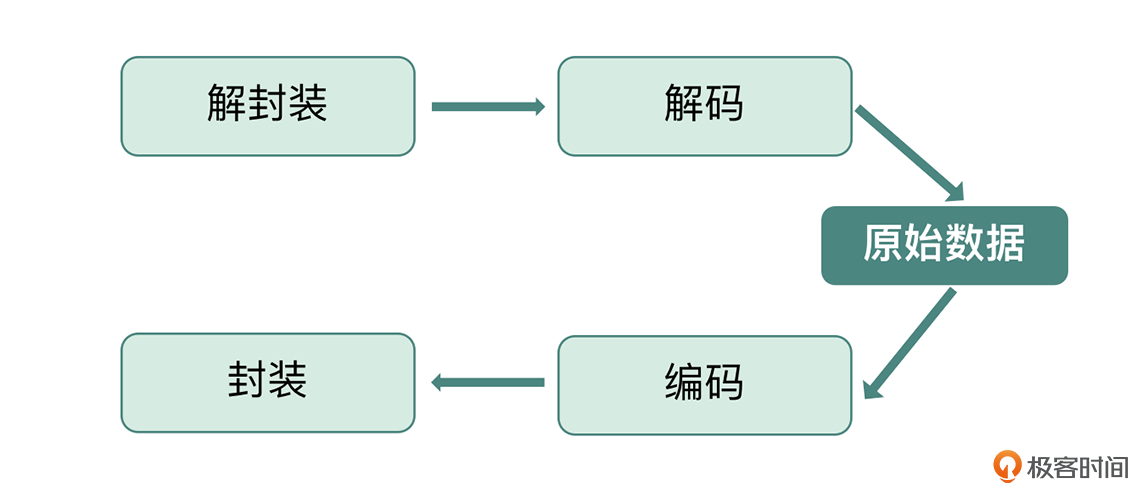

大土豆PC和手机还不太一样,PC的音视频硬件是集成在GPU中的,而手机就不一样了,是分开的。手机上职责还挺清楚的,CPU解封装,音视频专用器件硬解码,再给GPU进行渲染和图像处理(OpenGL部分)

大土豆PC和手机还不太一样,PC的音视频硬件是集成在GPU中的,而手机就不一样了,是分开的。手机上职责还挺清楚的,CPU解封装,音视频专用器件硬解码,再给GPU进行渲染和图像处理(OpenGL部分) peter请教老师几个问题: Q1:需要安装libx264吗? 文中有这样一句“使用命令行 ffmpeg -h encoder=libx264 查看”。 执行命令: ffmpeg -h encoder=libx264 输出:Codec 'libx264' is not recognized by FFmpeg. 提示没有libx264。 用这个命令:ffmpeg -encoders | grep H.264 输出:V..... h264_v4l2m2m 请问:“h264_v4l2m2m”和libx264是什么关系?需要安装libx264吗?(需要的话,怎么安装?) Q2: 转码用CPU还GPU,是由谁决定的? 是用户在ffmpeg的命令里指定吗? 还是由ffmeg自动决定? Q3:“转码”是把一个视频文件的编码从原来的编码方式转换为另外一种编码方式,比如,原来是A编码,转换为B编码。 对吗? Q4::本文讲的是视频转码,请问有音频转码吗?

peter请教老师几个问题: Q1:需要安装libx264吗? 文中有这样一句“使用命令行 ffmpeg -h encoder=libx264 查看”。 执行命令: ffmpeg -h encoder=libx264 输出:Codec 'libx264' is not recognized by FFmpeg. 提示没有libx264。 用这个命令:ffmpeg -encoders | grep H.264 输出:V..... h264_v4l2m2m 请问:“h264_v4l2m2m”和libx264是什么关系?需要安装libx264吗?(需要的话,怎么安装?) Q2: 转码用CPU还GPU,是由谁决定的? 是用户在ffmpeg的命令里指定吗? 还是由ffmeg自动决定? Q3:“转码”是把一个视频文件的编码从原来的编码方式转换为另外一种编码方式,比如,原来是A编码,转换为B编码。 对吗? Q4::本文讲的是视频转码,请问有音频转码吗? xueerfei007老师您好,我最近在使用ffmpeg编码工业相机sdk提供的raw帧数据。目前编码后,视频的时间与原始视频流对不上,编码长度比录制时长多了一倍。猜测可能与pts/dts的设置有关。这个需要如何设置,或者有什么方法定位到问题的具体原因?

xueerfei007老师您好,我最近在使用ffmpeg编码工业相机sdk提供的raw帧数据。目前编码后,视频的时间与原始视频流对不上,编码长度比录制时长多了一倍。猜测可能与pts/dts的设置有关。这个需要如何设置,或者有什么方法定位到问题的具体原因? Wonderfulpeng老师的课非常精彩,看了这节课我想请教的问题如下: 针对,“设置视频编码流为 CloseGOP,关键帧间隔的 -g 设置成 fps 的一半即可,fps 需要使用参数 -r:v 来设置,例如设置 -r:v 为 30,就是 30 fps”,那想问下: 1、OPENGOP如何设置呢? 2、网上说H265编码GOP只是OPENGOP,是否正确? 3、GOP设置对于视频编码压缩的影响?哪里能参考到相关最好的说明?

Wonderfulpeng老师的课非常精彩,看了这节课我想请教的问题如下: 针对,“设置视频编码流为 CloseGOP,关键帧间隔的 -g 设置成 fps 的一半即可,fps 需要使用参数 -r:v 来设置,例如设置 -r:v 为 30,就是 30 fps”,那想问下: 1、OPENGOP如何设置呢? 2、网上说H265编码GOP只是OPENGOP,是否正确? 3、GOP设置对于视频编码压缩的影响?哪里能参考到相关最好的说明? ifelse

ifelse 学习打卡2023-12-27归属地:浙江

学习打卡2023-12-27归属地:浙江 jcy尝试回答一下思考题: ffmpeg -i input.mkv -x264opts "bframes=2:b-adapt=0" -r:v 30 -g 60 -sc_threshold 0 -vf "scale=1280:720" output.mkv2022-09-02归属地:北京

jcy尝试回答一下思考题: ffmpeg -i input.mkv -x264opts "bframes=2:b-adapt=0" -r:v 30 -g 60 -sc_threshold 0 -vf "scale=1280:720" output.mkv2022-09-02归属地:北京