04|快速上手(二):LobeChat+AI 网关 +Ollama打造高可用大模型集群

邢云阳

你好,我是邢云阳。

在上一节课,我们使用 Ollama 部署了一个 DeepSeek-R1:32B 的模型,并通过修改聊天模板,完成了让模型强制 think 的修改。今天这节课,我们继续上一节课的思路,完成多 Ollama 实例的负载均衡的配置,使之成为一个高可用的 Ollama 集群。

话不多说,让我们先从集群架构设计开始吧。

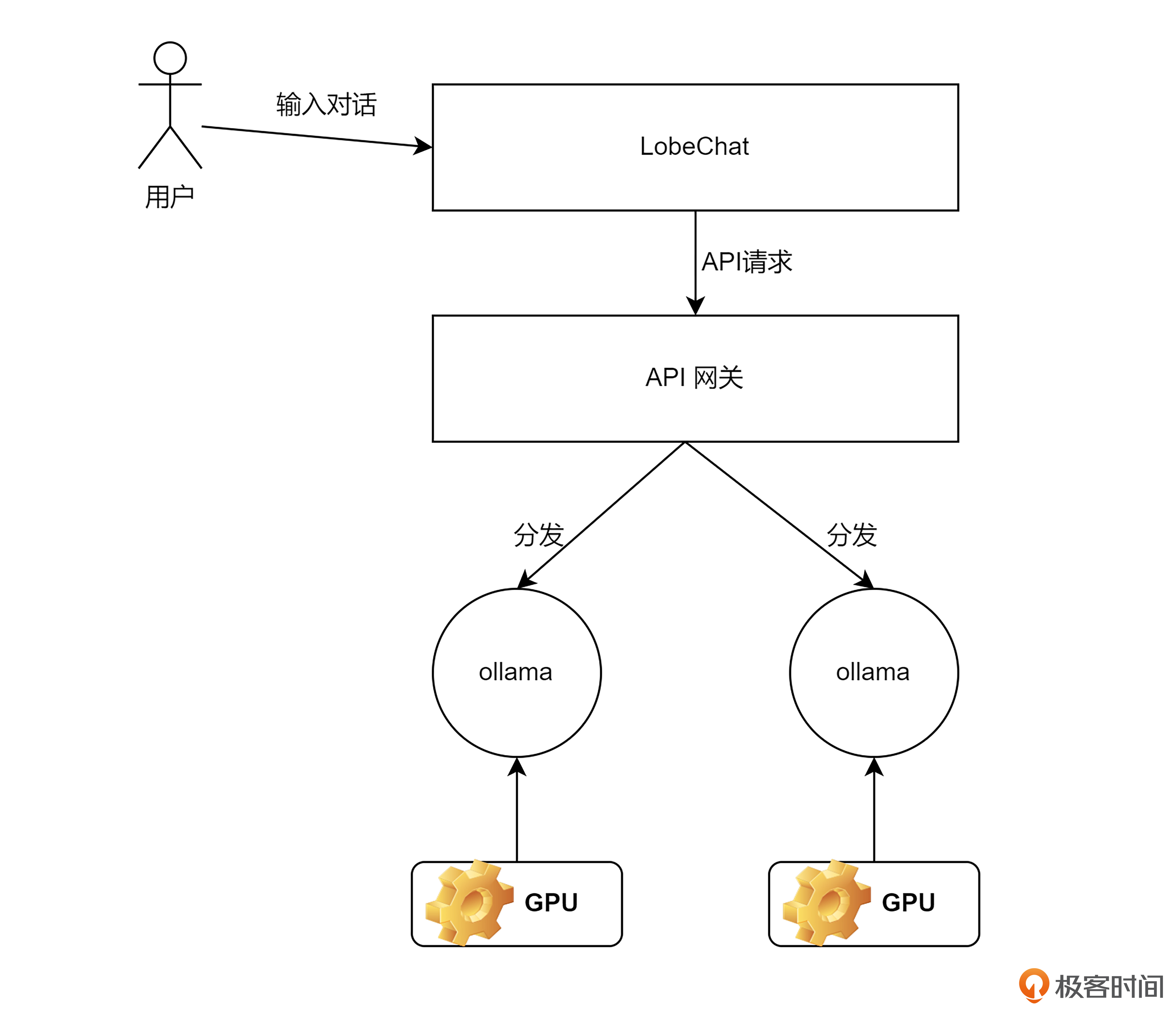

部署架构图

首先看一下整体的部署架构。

上节课,我介绍过,在我的服务器上,有两张 T4 卡,因此我会创建两个 Ollama 实例,两个实例分别占用一张卡,并且每一个实例都对应一个 DS-R1:32B 模型。

之后为了满足对于大模型服务的负载均衡和流量转发,我们需要针对 AI 时代的新需求去对 API 网关进行选型。

最后为了能让用户像使用 ChatGPT 一样,通过一个前端页面与大模型进行问答交互,我部署了开源社区特别火的一款对话前端,名字叫 LobeChat。LobeChat 开箱即用,支持多模型的对接,非常适合我们做对话测试。

使用 Ollama 启动 DS 模型

接下来,我们启动一下两个 Ollama。我依然使用的是将模型下载服务器,然后挂载到 Docker 容器内的启动方式。命令行如下所示,注意区分两个实例的名称以及端口号,不能重复。同时要注意 --gpus 参数的设置,第一个实例用 0 号卡,第二个实例用 1 号卡。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 介绍了如何使用 LobeChat+AI 网关+Ollama 搭建高可用大模型集群,展示了整体的部署架构,并介绍了使用 Ollama 启动 DS 模型的步骤。 2. AI 时代给网关带来的挑战,包括服务连续性、资源安全、商业模式保护、内容安全和多模型管理。 3. Higress 的部署与测试,以及其提供的 API Key 二次分租功能,用于满足面向多用户提供服务的场景。 4. Higress 控制台的功能,包括添加大模型服务、添加大模型的访问路由和设置每个服务的请求比例。 5. Higress 提供的部署模式和 AI 流量入口管理的功能,以及基于 K8s 和 Docker 的部署模式。 6. Higress 的 API Key 二次分租功能,可以控制消费者的调用权限和调用额度,配合可观测能力,对每个消费者的 token 用量进行观测统计。 These points summarize the key aspects of the article, focusing on the deployment of the AI model cluster, challenges in the AI era, Higress deployment and features, and the API Key management functionality.

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《DeepSeek 应用开发实战》,新⼈⾸单¥59

《DeepSeek 应用开发实战》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论