04|本地部署:如何本地化部署开源大模型ChatGLM3-6B

独行

你好,我是独行。

前面听我讲了这么多,相信你也很想上手试一试了。从这节课开始,我们进入一个新的章节,这部分我们会学习如何部署开源大模型 ChatGLM3-6B,本地搭建向量库并结合 LangChain 做检索增强(RAG),并且我会带你做一次微调,从头学习大模型的部署、微调、推理等过程。

这节课我们就来讲一下如何本地化部署 ChatGLM3-6B(后面我们简称为 6B)。讲 6B 之前我们先整体看一下目前国内外大模型的发展状况,以便我们进行技术选型。

大模型的选择

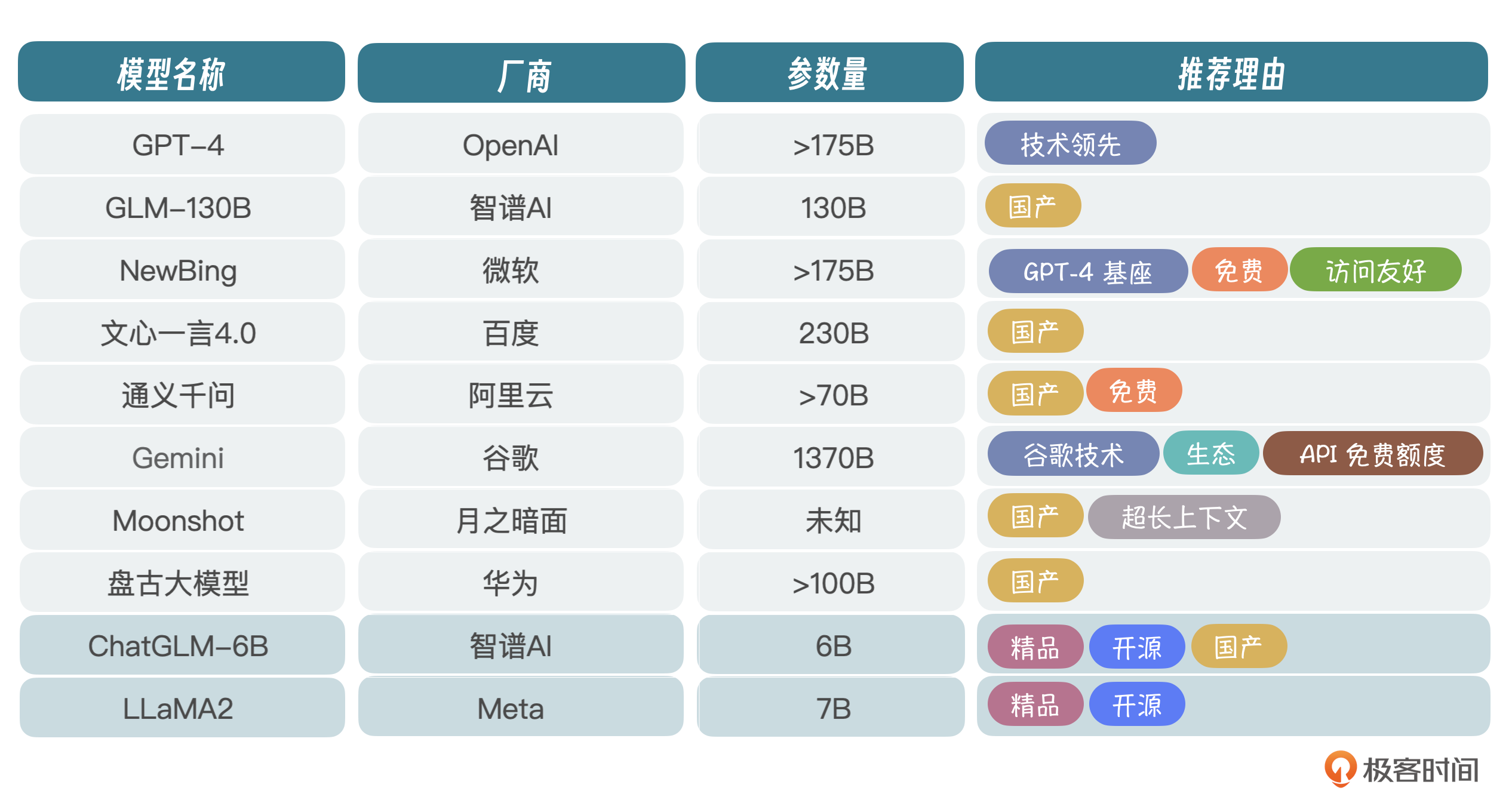

当前环境下,大模型百花齐放。我筛选出了一些核心玩家,你可以看一下表格。非核心的其实还有很多,这里我就不一一列举了。厂商虽然很多,但真正在研究技术的没多少,毕竟前面我们讲过,玩大模型投入非常大,光看得见的成本,包括人才、训练和硬件费用,一年就得投入几个亿,不是一般玩家能玩得起的。

当然,也有不少厂商是基于 LLaMA 爆改的,或者叫套壳,不是真正意义上的自研大模型。

ChatGLM-6B 和 LLaMA2 是目前开源项目比较热的两个,早在 2023 年年初,国内刚兴起大模型热潮时,智谱 AI 就开源了 ChatGLM-6B,当然 130B 也可以拿过来跑,只不过模型太大,需要比较多的显卡,所以很多人就部署 6B 试玩。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. ChatGLM3-6B是一个开源大模型,可以在本地部署,需要解决计算资源问题,建议申请GPU资源。 2. 部署ChatGLM3-6B需要在Linux环境下进行,推荐使用Python 3.10~3.11版本,Transformers库推荐4.36.2版本,Torch推荐使用2.0及以上版本。 3. 部署ChatGLM3-6B的具体步骤包括克隆代码、安装依赖、下载模型、修改示例代码、命令行启动等。 4. 在部署好模型后,可以进行推理,可以设置超参数来控制模型的推理准确度。 5. ChatGLM3-6B在语义、数学、推理、代码、知识等不同角度的数据集上表现出色,具有多个长文理解能力版本。 6. ChatGLM3-6B的推理效果良好,适合在本地进行部署和应用。 7. ChatGLM3-6B有3个参数可以设置,包括max_length、temperature和top_p,用来控制模型的推理准确度。 8. 新的Prompt格式增加了系统、用户和助手三种角色,以及代码场景中的observation角色,用于控制模型与用户交互的范围和防止输入注入攻击。 9. 部署ChatGLM3-6B的过程相对简单,需要解决计算资源问题,推荐申请GPU资源。 10. 大模型的参数规模62亿表示模型的复杂度和容量,影响模型的学习能力和推理效果。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《AI 大模型实战高手课》,新⼈⾸单¥59

《AI 大模型实战高手课》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论