01|读懂Attention:测试工程师驾驭LLM的第一步

陈磊

你好,我是陈磊。

欢迎你和我一起聊一聊大模型和测试的这些事,这是我们专栏的第一课,我们先从一个测试工程师需要掌握的大模型的基础内容开始。

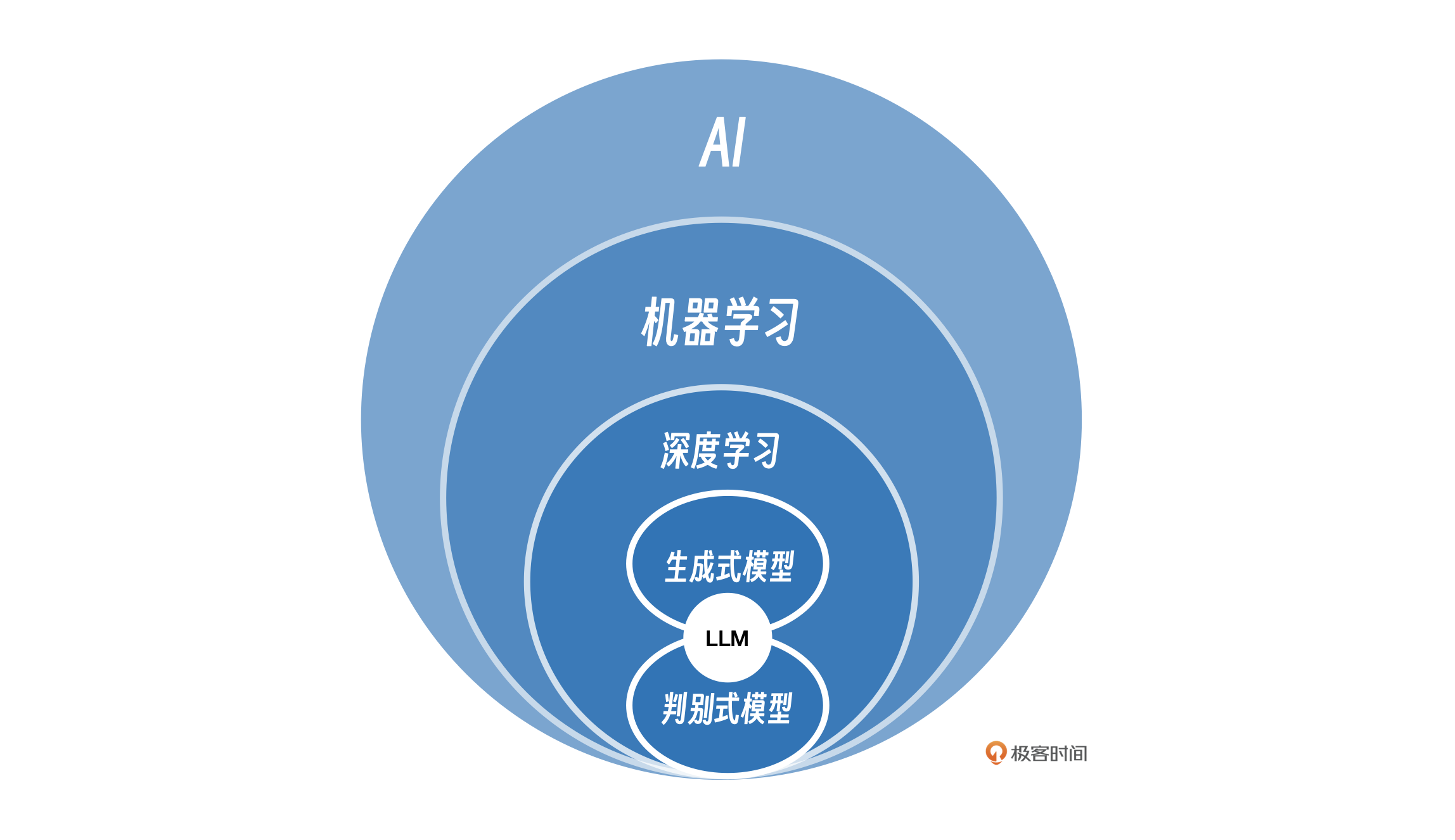

从 1936 年图灵的《论可计算数及其在判定问题中的应用》到 1956 年夏天,麦卡锡、明斯基等科学家在美国的达特茅斯学院讨论如何用计算机模拟人的智能开始,AI 这个概念就在计算机科学领域扎下了根。在 AI 的发展过程中经历了机器学习(Machine Learning,简称 ML)、深度学习(Deep Learning,简称 DL),大语言模型(Large Language Model,简称 LLM)等研究方向,这些概念的相互关系如下图。

DL 包含了生成式模型(Generative)和判别式模型(Discriminative),判别式模型学习数据的边界和差异,用于分类或预测。例如,一个模型判断一张图片“是猫”还是“不是猫”,它就是在做判别。

生成式模型学习数据的潜在分布和规律,用于生成新的、类似的数据。例如,让模型“画一只猫”出来,它就是在做生成。LLM 本质上就是生成式模型,但是 LLM 被微调用于判别任务(分类、问答打分、检索排序等),训练流程中常用的奖励模型 、RLHF (基于人类反馈的强化学习,全称 Reinforcement Learning from Human Feedback )、对比学习等也包含判别式损失。因此在功能和训练组成上,LLM 会与判别模型有交集。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 大模型的发展历程:从机器学习到深度学习再到大语言模型(LLM),以及它们之间的相互关系和应用领域。 2. Attention机制的重要性:理解“attention is all you need”论文的基础内容对测试工程师驾驭LLM至关重要,因为Attention机制能够解决神经网络模型无法处理的远距离依赖和全局关注的问题。 3. LLM的本质和应用:LLM本质上是生成式模型,但在实际应用中常被微调用于判别任务,训练流程中也包含判别式损失,因此在功能和训练组成上与判别模型有交集。 4. 神经网络模型的比喻:FNN(前馈神经网络)类比为手忙脚乱的新厨师,RNN(循环神经网络)类比为有经验的厨师,CNN(卷积神经网络)类比为擅长找规律的厨师,以及它们各自的特点和局限性。 5. 神经网络模型的应用场景:FNN适合独立步骤的任务,RNN适合处理序列,CNN擅长捕捉局部规律,而Attention机制则能够动态地“聚焦”处理全局和远距离依赖。 6. temperature控制输出文本的随机性和创造性,通过调整模型预测的概率分布。 7. top_k和top_p参数的作用和影响,以及在调整超参数时的实际应用场景。 8. Token是LLM处理文本的单位,不同语言的Token计算方式不同,测试开发工程师需掌握Tokenization以评估模型的上下文限制和效率。 9. 超参数调优对模型行为的影响:超参数如temperature、top_k、top_p显著影响LLM输出,测试开发工程师需通过调整这些参数解决重复输出或不连贯输出等问题,同时结合任务需求和模型特性进行优化。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《AI 重塑测试开发系统实践》,新⼈⾸单¥29

《AI 重塑测试开发系统实践》,新⼈⾸单¥29

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论