开篇词|大模型安全不是黑科技,是新的基本功

赵帅

讲述:赵帅AI版大小:6.03M时长:17:32

你好,我是赵帅。

一名有着 11 年工程经验的 AI 算法工程师,从最初的知识图谱和智能问答系统,到近年来越来越热门的预训练生成式语言模型,我亲身经历了技术的多次跃迁,也目睹了它带来的冲击、挑战与风险。

我曾带领团队针对“车载助手”实现了大模型从 0 到 1 的自研与部署,不过这个过程让我印象最深的不是“它有多强”,而是“它有多难控”。我们用了大量的时间去优化推理速度、提升多轮对话体验,但最后最花精力的,不是算法优化,而是安全问题。

在一次面向开放用户的实际测试中,模型处于某个场景下,测试人员随口问了个听上去无伤大雅的问题——涉及到汽车品牌影响力的相关问题,但模型的回答让现场一阵沉默。它不仅没有模糊回答,反而还自动补充了大量未经验证的推测性内容,甚至牵涉到了一位公众人物与某位企业创始人的关系等敏感判断。这类生成如果在真实产品中对公众可见,不仅会带来品牌灾难,甚至可能导致合规事故。在国内环境下,这是不可触碰的红线。

安全不是黑科技,而是新基本功

后来,我们干脆拉了一套红队测试机制,请安全测试人员对模型疯狂攻击,发现的风险远比我们想象中多得多。比如,有人用反问句的方式来诱导模型自黑,有人用提示注入劫持模型人格,还有人用错别字和符号绕过关键词拦截……更可怕的是,模型每次出事的方式都不一样。那一刻我意识到,大模型不应该被认定为是一个黑盒工具,它应该是一种“类智能系统”。安全,不再是传统安全的那一套,而是新的战场、新的边界。

坦率讲,一开始我并没有打算专门开一门关于“大模型安全”的课程。我以为这是相关服务供应商才关心的问题,跟广泛的技术人员关系不大。但当越来越多的同行来问我:

“我们项目用开源大模型接了 RAG,但老板担心会出安全事故,怎么办?”

“如果用户给模型输入不合规内容,模型会不会出事?”

“我们想做一个 To C 的模型应用,怎么通过备案?”

“我们接了行业私有数据,怎么保证模型不会把客户数据拿去训练?”

“听说很多提示词被泄露后会被滥用,怎么保护好这些 Prompt?”

“你们是怎么设计提示词过滤器的?我也想做一个……”

我开始意识到,大模型的安全问题已经从“前沿实验室话题”,变成了每一个开发者、产品人、技术负责人都绕不开的现实问题。更可怕的是,这个领域的知识是零散的。你可能看过一些新闻稿、白皮书,甚至也读过 RLHF、红队测试的论文,但你仍然很难回答这几个问题:

如何系统地识别大模型的风险类型?

怎样构建从输入到输出的安全闭环?

哪些防护机制是必要的?哪些是锦上添花?

合规、安全、审计、伦理、对齐,这些到底怎么落地?

于是,我决定把我这些年在实际项目中经历过的坑、踩过的雷,以及摸索总结出来的一套系统化的做法,整理成一门完整的课程。希望通过它,帮助你从理论到实践,真正建立起一整套可落地的安全思路、技术手段和架构策略,让安全原则不仅仅停留在概念上,而是能在你们自己的 AI 产品和平台设计中变成可执行的方案、可操作的流程,成为一条真正的安全落地路线。

不做“聪明的疯子”

你可能已经在应用大模型,也可能准备在公司内部上线一个基于大模型的应用。这时你很可能有这样一些顾虑:

我的模型会不会被“提示注入”?

我的输出是不是含有违禁词、歧视言论或政治敏感内容?

我的系统是否具备对“幻觉”、“虚假信息”的拦截机制?

我的团队有没有足够的安全设计能力来通过监管审核?

假如你的脑海中闪现过这类想法,那么你已经隐约意识到了安全的重要性。这是迈向构建稳固、可靠的大模型应用的第一步。因为大模型的能力越强,它的“不受控性”也越强。今天的大模型不像过去的 FAQ、Task Bot 那样写死意图流程,它是生成的。也就是说,你没办法预判它每次都会说什么,它可能临场发挥,也可能语出惊人。你能做的,是通过系统性机制,让它“不该说的话说得合规、说得有据、说得安全”。所以大模型安全的目标,绝不是百分百防止事故,而是:

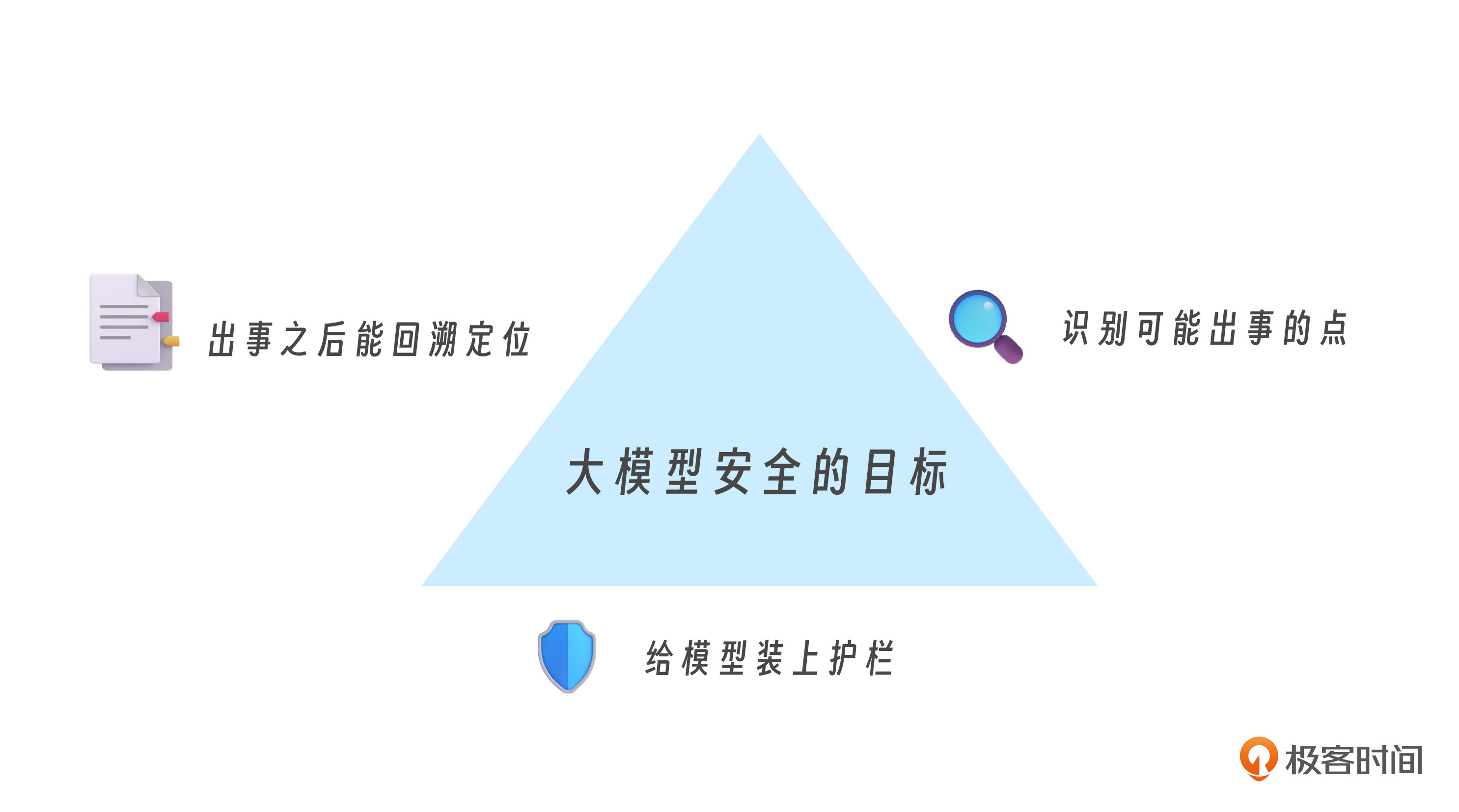

大模型安全的目标

识别可能出事的点

给模型装上护栏

出事之后能回溯定位

这三步,就是我们这门课程要带你构建的安全闭环。但故事并没有结束,当你真正开始设计一个安全可控的大模型系统时,你会遇到一些比技术更难解决的问题。比如,我们是否应该对所有用户输入都进行过滤?过滤机制是集中式的,还是多层渐进的?如果用户使用模型进行创造性工作,是否允许越界式的探索?如果用户输入的是双关语、讽刺话、或者模棱两可的语言,我们如何判断它是否违规……

甚至于,我们可能得承认,安全从来不是做好了就一劳永逸的事。它更像是一个动态的系统,是随模型能力增长、用户需求变化而持续演化的博弈过程。有时候,它甚至是妥协的艺术。你可能为了合规,牺牲一点自由度;为了更丰富的回答,容忍一点模糊边界;为了提升效率,接受某种风险的容忍线。所以,我们需要的是一种理解力,这种理解力不是对一两个风险术语的背诵,而是对整个模型运行机制和交互逻辑的整体把握。

刚刚说的可能有点抽象,我给你举个例子。很多人以为安全问题就是输出内容不当,比如说了违禁词,触犯了敏感线。但你有没有想过,模型为何会说出这些话?也许它是为了顺应用户的“期待”;也许是因为语料里暗藏了偏见;也许是因为缺乏正确反馈进行对齐;也许……是因为它不知道不该说的边界在哪。

那我们能不能让它知道?你看,这其实不是一句“不要生成违规内容”就能解决的问题。我们要教会它认识风险,引导它做选择,在生成时自我约束,而不是靠最后一层“关键词屏蔽”来兜底。这就需要我们回到系统设计的起点:输入能不能有指引?中间能不能有调控?输出能不能有控制?

如果你从事 AI 相关开发,尤其是想做一个 To B 或 To C 的大模型产品,我相信你早晚也会被这些问题困住。因为今天的大模型,是“生而强大,但未必可控”的。就像在你面前放了一头驯服但有野性的狮子,你不能靠锁链控制它,而是要建立一种认知边界,让它知道什么时候应该保持沉默,什么时候可以发挥本领。

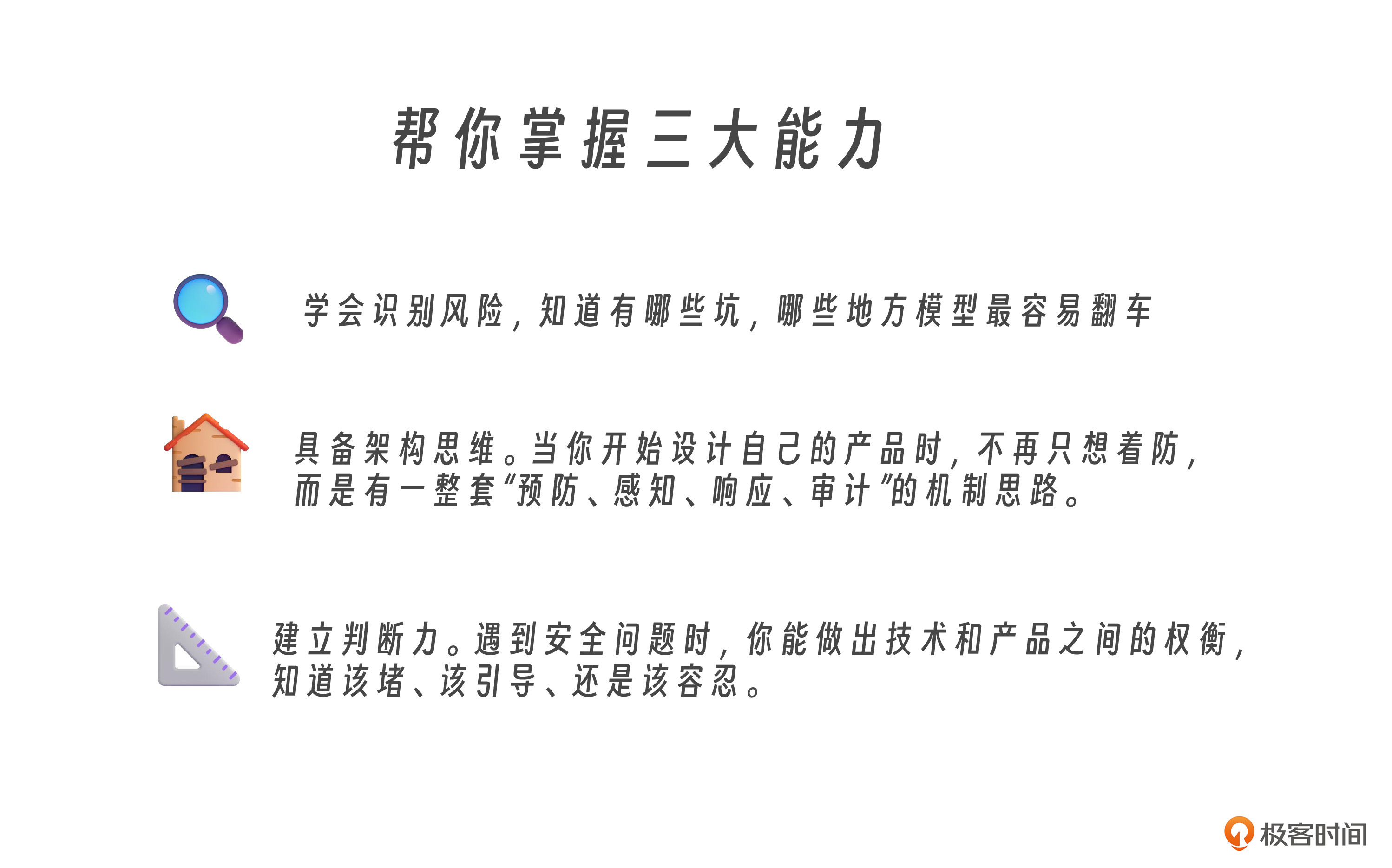

安全,其实是模型走向成熟的一种“自觉”,课程中我们将逐步展开一套系统的方法路径,因为很多东西还在变化,每家头部公司也都在边走边调。通过这门课,我最想传授给你的是三种能力,这些也是我亲身实践中,解决大模型安全问题时最有帮助的武器。

第一,学会识别风险,知道有哪些坑,哪些地方模型最容易翻车。第二,具备架构思维。当你开始设计自己的产品时,不再只想着防,而是有一整套“预防、感知、响应、审计”的机制思路。第三,建立判断力。遇到安全问题时,你能做出技术和产品之间的权衡,知道该堵、该引导、还是该容忍。

这是一次系统性的思考练习。它不会告诉你哪一个“过滤器”最灵,但会带你建立自己的“安全判断框架”。这就是我想做这门课的理由:不是因为我“知道一切”,而是因为我走过那条不断踩坑、不断反思、不断修正的路,我希望你能走得更顺一些。

安全,不应该是一道“封闭题”。它是开放的、动态的、场景化的。我们需要的,不是照搬答案,而是学会思考。在不确定中建立确定性,在风险中寻找可控边界。这些问题,其实技术并没有标准答案。它们涉及审美、伦理、品牌定位、法规理解,甚至用户体验哲学。之后你会意识到,模型的安全,其实从来不是一套算法就能兜住的。它是一种治理能力,是架构、策略、监管、训练、提示、输出和审计的协同结果。

谁来为“安全事故”买单

在我们说完“安全不是固定的答案,而是一种动态治理能力”后,你可能又冒出这样一个疑问——那这些风险出事了,到底该由谁负责?我们接下来就要聊聊“谁来为安全事故买单”这个问题。

大模型的安全,不光是应用者的问题。很多人误以为,基座模型的提供方应该“兜住所有风险”,但事实远比这复杂。你可能听说过这样一种情况:某个公司选了一个主流的开源大模型,接上自家知识库,在公司内测时一切正常。但在上线对外服务时,用户一问“某地疫情数据怎么瞒报的”,模型就开始胡编乱造,甚至还煞有其事地引用了不存在的新闻源。这时候,公司就会追问,这不是开源模型的错吗?为什么你们模型里面有这样的回答?

但是问题是,开源模型出厂时并没有这样的数据,是你在微调过程中加进去了某些训练数据,还是你用的上下文窗口太大,导致用户历史输入干扰了当前输出?抑或是你没有设置系统提示,模型在没有约束的情况下发挥过头?这时候,责任边界就模糊了。

安全责任链,最脆的一环在哪?

基座模型的厂商,更多提供的是一个能力容器,他们的任务是让模型更强、更通用。而一旦到了实际落地环节,比如连接数据库、执行代码、回答用户,安全责任链条就变得极其复杂。例如是谁设置的提示词策略?是谁决定了输出要不要二次过滤?是谁在业务流程中加入了模型判断结果?是谁把模型回答作为产品官方说法对外发布的?你会发现,安全从来不是一个人的事,而是整个链条的事。而链条最脆的地方,往往是在接入场景的那一环。

大模型的基座厂商,国外的 OpenAI、Anthropic、Google,或国内的字节跳动、深度求索、阿里巴巴,他们现在几乎都走的是“技术中立 + 平台责任”的思路。他们提供接口,提供默认策略,甚至还开源了一些审查模块,但他们不会告诉你怎么在你自己的业务中落地这些能力。原因很简单,每一个行业的监管尺度、内容敏感度、用户习惯都不一样。比如教育行业必须避免不良价值观的传播;金融行业要规避合规用语和投资误导;医疗行业对内容的准确性和可追溯性要求极高;政务行业更是每一个用词都要慎之又慎……

没有标准答案,只有治理能力

你会看到,在应用侧,公司不仅需要理解模型怎么训练的问题,更重要的是要构建业务里的安全逻辑。比如你在做智能客服,你可能得设定三类问题不回答、五类回答要加免责声明、十类关键词触发人工转接;你做的是 AI 代码生成工具,你可能得屏蔽高危函数、加入权限校验、设置文件系统沙箱……

这些策略,其实没有统一标准,它取决于你对业务的理解、对模型能力的评估,以及对风险的容忍边界。而且,最难的一点是模型能力和风险不是线性增长的,你做得越智能,越自然,它出错的方式也越隐蔽,越难察觉。

最初的 AI 可能只是语法错误,后来的 AI 可能是情绪倾向,再后来你发现它懂得顺着用户说话,那时候它犯错就不再是逻辑问题,而是道德问题、法律问题、价值问题了。说到底,大模型不是会说话的数据库,它是一个正在成长的智能系统。而我们这些构建它、使用它、管理它的人,就是它的环境变量。

一起构建安全系统的认知闭环

你不能只希望大模型是“有道德的”,你得把那些约束和善意写进它的输入、训练、对齐机制、交互流程和输出结构中。这门课,也正是从这样的视角出发,不仅讲攻击防御,不只讲合规机制,而是想和你一起,把大模型安全当作一个系统工程去思考,不是哪个过滤器最强,也不是哪个漏洞最流行,而是怎么把你的业务风险,翻译成模型的运行边界?怎么把你的产品责任,拆解成技术机制和流程治理?怎么在现实业务中,落地一套不拖慢产品节奏、但又守得住底线的安全体系?

课程里我一共设计了四个模块,来循序渐进提升你的模型安全认知水平和实战落地能力。

启航篇,我们先来认识大模型安全的本质与价值,模型的运行机制,识别高频的风险类型,了解大模型安全架构逻辑。学完这个部分,你就能对大模型安全建设建立一个多维、系统的认识。

风险篇会针对大模型的高频风险,和你深入探讨“大模型被欺骗”(提示注入、上下文劫持、微调投毒等问题)“大模型被盗窃”(逆向攻击)“大模型说错话”(内容越界、隐私泄露)等诸多现实落地风险要如何判别和预防。我会从原理上解释这些攻击是如何发生的,还将配合典型案例展示风险发生的实际路径,帮你稳步提升“风险识别能力”。

防御篇我们在深入理解风险的基础上,将会掌握大模型安全的应对策略。重点讲解如何通过系统性设计手段构建大模型的“安全防线”。围绕“输入 - 处理 - 输出”这一工作流程,我们将介绍包括 Prompt 过滤、上下文权限隔离、内容输出拦截与标识、审计日志回溯等在内的核心机制,同时进一步引入如 RLHF(强化学习人类反馈)、宪法式 AI、红队测试、系统提示对齐等业界主流安全机制。

最后是企业篇,这个部分会将安全从“原理”与“机制”层面,进一步推进到“场景实践”的维度。不同场景的安全需求各不相同,对策设计也应有所侧重。我们将结合真实案例来加强自己的“安全落地工程”的实战能力。这一章精选了多个代表性的具体业务场景,让你掌握如何在具体产品(聊天类助手、编程类助手、教育、金融、医疗、政务等行业智能体)中实现“因地制宜”的模型安全控制。

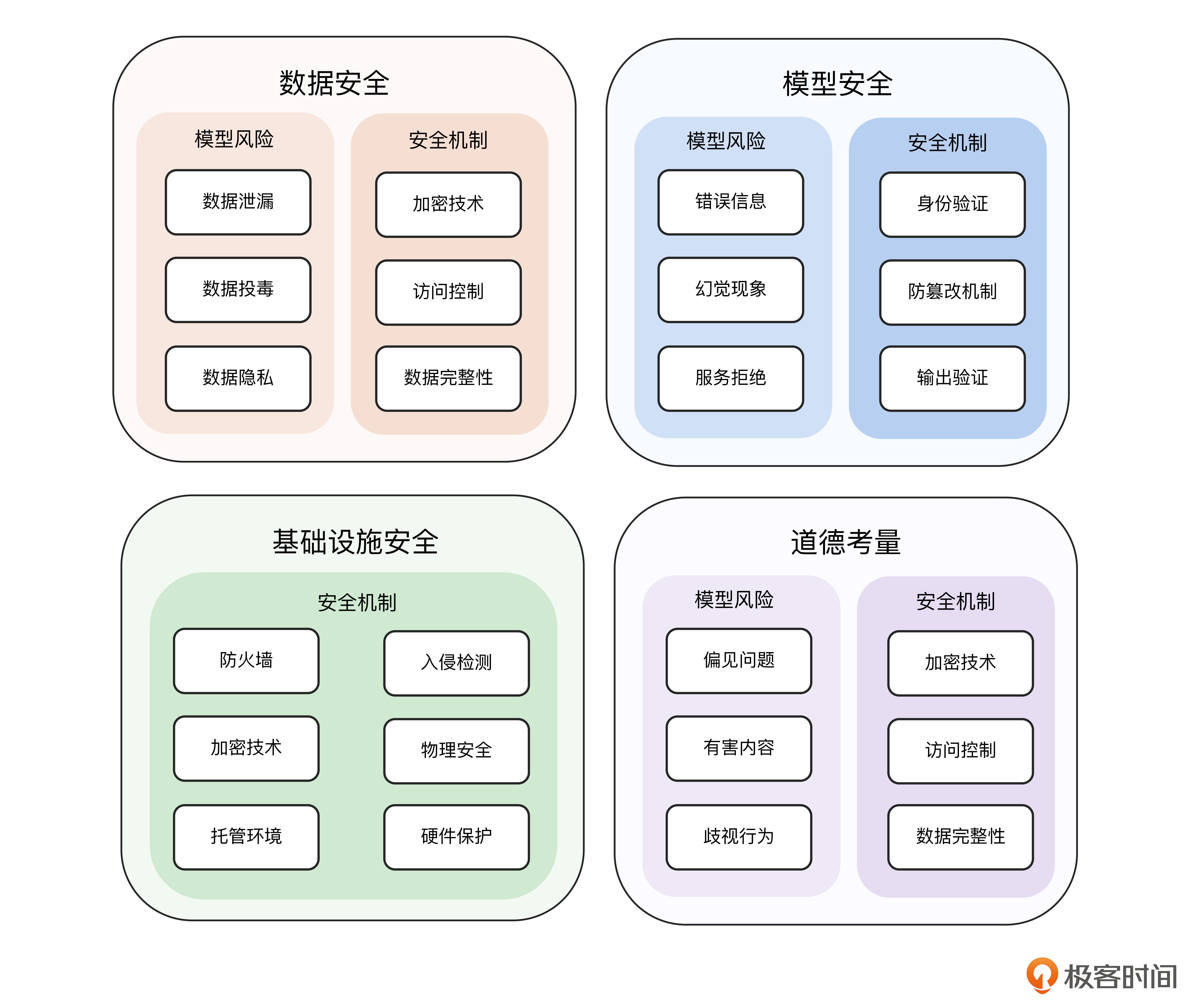

这里我还梳理了一张知识导图,帮你直观了解大模型安全中的四大支柱。

大模型安全中的四大支柱

跟我学完这门课,你今后在面对最前面的那些困惑时,将不再只是感觉有问题,而是真的知道怎么应对。我将用接地气的语言、系统化的路径、实操性的案例,帮助你从认知混沌中跳出来,构建自己的安全设计思维。不是为了安全而安全,而是为了让你的 AI 产品真正落地——落得下去,守得住场,撑得起责任。

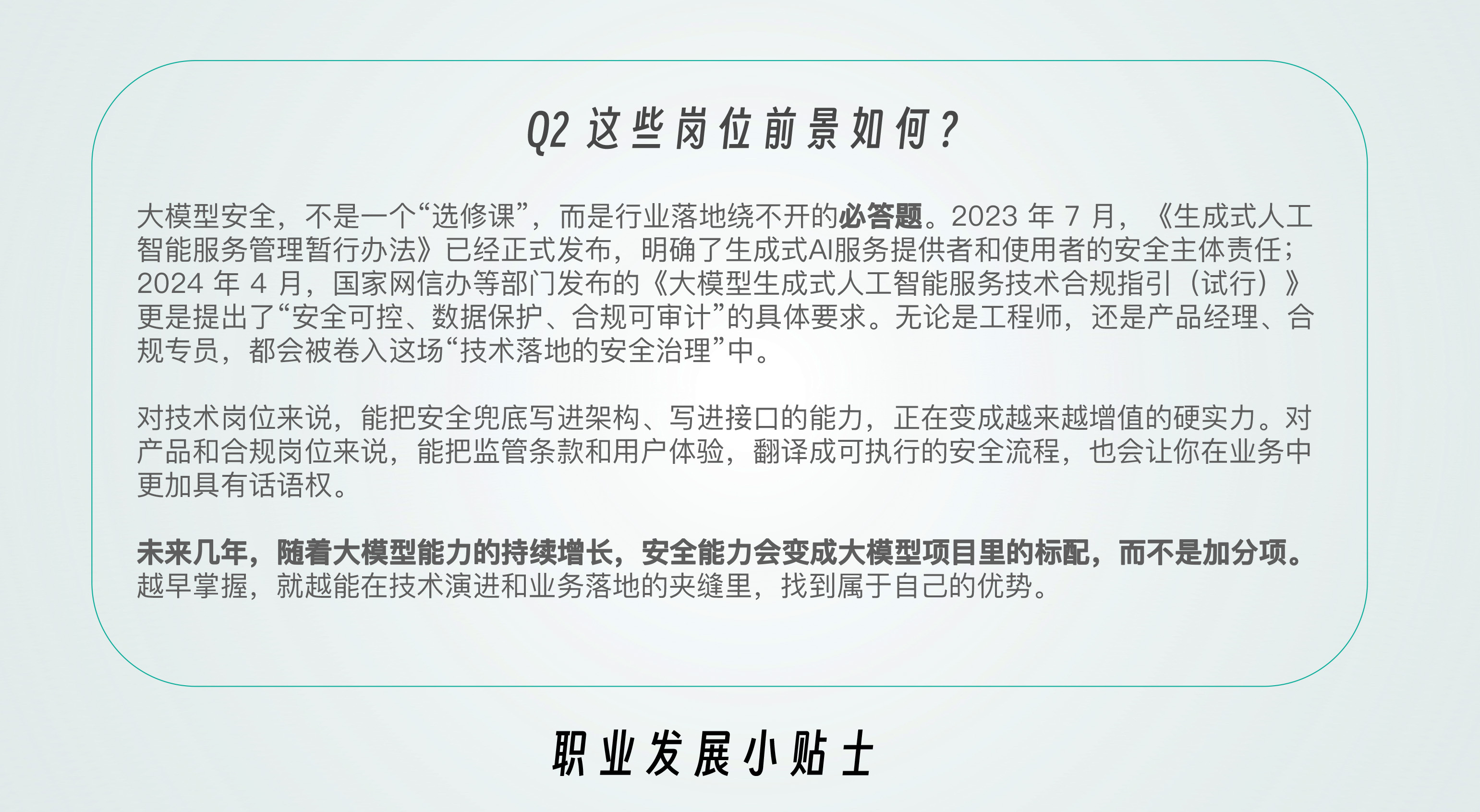

后面是这门课的职场小贴士,方便你快速了解学习这门课对从事哪些岗位有帮助,他们的前景又是怎么样的。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. 大模型的安全问题已经成为每一个开发者、产品人、技术负责人都绕不开的现实问题。 2. 大模型不应该被认定为是一个黑盒工具,它应该是一种“类智能系统”。 3. 需要建立起一整套可落地的安全思路、技术手段和架构策略,让安全原则在AI产品和平台设计中变成可执行的方案、可操作的流程。 4. 安全不是一套固定的答案,而是一种动态治理能力。 5. 安全责任链条极其复杂,最脆弱的环节在接入场景的那一环。

2025-07-08给文章提建议

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《大模型安全实战课》,新⼈⾸单¥59

《大模型安全实战课》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论