09|如何使用LLaMA 3进行多轮推理的反馈增强?

Tyler

你好,我是 Tyler!

今天,我们来聊聊如何通过反馈增强来提升 LLaMA 3 的多步推理能力。我会给你介绍几种反馈增强的技术,以及它们是如何有效提升智能体表现的。我们将重点讨论推理(Reasoning)、行动(Act)和反应(ReAct)这三者之间的相互作用。

反馈增强的形式

在探讨反馈增强之前,我们首先要理解多步推理的重要性。现代智能体系统中的推理不再是简单的单一响应,而是一个由反馈驱动的动态决策过程。通过将复杂任务分解为多个步骤,模型可以更深入地理解任务的不同方面,提升执行的效率与准确性。

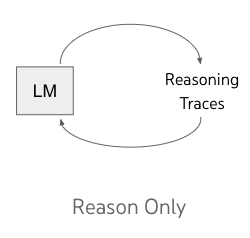

Reasoning(推理闭环)

首先我们回顾一下推理闭环,推理是 LLaMA 3 面对复杂任务时最关键的能力之一。我们之前提到的思维链 (CoT) 是一个非常有效的框架,用来实现分步骤的推理过程。

图片来自ReAct: Synergizing Reasoning and Acting in Language Models

通过将复杂问题分解成多个小步骤,思维链能够让模型更好地理解问题,并提升推理能力。比如说,假设模型遇到一个包含加法和减法的数学题。用思维链的方法,模型会把问题拆成:

计算第一个加数和第二个加数的和。

从上述结果中减去第三个数。

这样的推理方式让模型更清楚逻辑关系。比如在题目“5 + 3 - 2”中,模型首先会算出“5 + 3 = 8”,然后再算“8 - 2 = 6”。CoT 明显提升了模型在复杂场景中的表现能力。

公开

同步至部落

取消

完成

0/2000

笔记

复制

AI

- 深入了解

- 翻译

- 解释

- 总结

1. LLaMA 3 通过反馈增强来提升多步推理能力,重点在于推理闭环、行动和反应的相互作用。 2. 推理闭环中的思维链(CoT)框架能够有效提升模型在复杂场景中的表现能力,但在处理多个变量和条件的组合推理时仍会遇到挑战。 3. 行动在多步推理中扮演至关重要的角色,模型需要考虑环境信息与下一步行动之间的关系,以提高决策准确性。 4. ReAct方法结合了推理和行动的思想,要求模型在每次行动后观察结果,并基于观察结果进行新的推理和决策,从而提高模型的灵活适应能力。 5. LLaMA 3 的多步推理能力得益于其对多步推理和工具使用的增强,通过合成数据生成和提示生成来实现。

仅可试看部分内容,如需阅读全部内容,请付费购买文章所属专栏

《LLaMA 3 前沿模型实战课》,新⼈⾸单¥59

《LLaMA 3 前沿模型实战课》,新⼈⾸单¥59

立即购买

© 版权归极客邦科技所有,未经许可不得传播售卖。 页面已增加防盗追踪,如有侵权极客邦将依法追究其法律责任。

登录 后留言

精选留言

由作者筛选后的优质留言将会公开显示,欢迎踊跃留言。

收起评论